Jusqu’en 2009, tous les appareils se reposaient sur la technologie GPS américaine. La concurrence et les algorithmes changent la donne.

“Vous êtes ici” : une brève histoire de la géolocalisation

Du smartphone à la voiture connectée, la géolocalisation est aujourd’hui au cœur de notre quotidien et de nos usages. Depuis 1974, la technologie GNSS (Global Navigation Satellite System) peut se féliciter d’avoir ouvert la voie à des milliers d’applications et de services utilisés dans le monde entier.

Pourtant, les limites techniques et le développement des technologies concurrentes poussent aujourd’hui les ingénieurs à imaginer des solutions encore plus précises.

Transit : la conquête spatiale comme point de départ

C’est tout d’abord grâce aux systèmes terrestres de radionavigation que les premières innovations en matière de géopositionnement ont été menées.

Toujours utilisé aujourd’hui, notamment dans le secteur de l’aéronautique, ce système reposant sur le signal radio envoyé par plusieurs stations émettrices se révèle précis à l’échelle locale, mais vite approximatif à longue distance du fait de la rotondité de la Terre.

En 1957, date identifiée comme le début de la conquête de l’espace, le gouvernement soviétique lance Spoutnik 1, le premier d’une longue liste de satellites artificiels de la Terre. Les ingénieurs américains comprendront rapidement que l’effet Doppler repéré sur les signaux du satellite permet de déduire ses paramètres orbitaux, donc sa position exacte.

En 1964, l’armée américaine finalise la mise en œuvre de Transit, le tout premier système de positionnement par satellites de l’Histoire capable de situer en plusieurs heures un récepteur avec une précision oscillant entre 200 et 1 000 m, cela grâce aux signaux et aux éphémérides de la poignée de satellites mis en orbite. Un bon début qui ouvrira la voie à une utilisation pour le grand public.

GPS : géolocalisation pour tous

Jusqu’alors réservée à un usage quasi exclusivement militaire, la technologie de géolocalisation se démocratise en 1995 avec la mise en service du GPS (Global Positioning System), avancée américaine initiée dès 1974 et dont la précision repose sur la présence d’un maillage d’au moins 24 satellites du système NAVSTAR gravitant autour du globe à une distance moyenne de 20 000 km de la surface de la Terre.

Les ondes radio envoyées depuis l’espace à la vitesse de la lumière permettent au récepteur GPS, à l’aide de l’heure de réception du signal, de déduire assez facilement la distance d’un satellite.

Par triangulation, il devient donc possible d’estimer la position géographique exacte d’un récepteur avec une précision d’une trentaine de mètres. En ouvrant cette technologie GPS aux civils en 1995, le gouvernement américain permet la démocratisation des appareils commerciaux de géopositionnement.

Les avancées en matière de miniaturisation des puces GPS permettront dès 1999 au premier modèle de téléphone portable géolocalisé (le Benefon Esc!) de voir le jour. La fin de la détérioration volontaire du signal GPS décidée en mai 2000 par le gouvernement américain marque une étape importante : elle permet notamment l’arrivée sur le marché d’appareils de navigation embarquée qui couplent la technologie GPS à des interfaces de cartes en « vue d’oiseau”. TomTom, avec le TomTom GO en 2004, en est le précurseur.

Présentation de Galileo, le système de navigation européen

Beidou, GLONASS, Galileo : la concurrence au service de l’utilisateur

La position de dominante des États-Unis sur le marché de la géolocalisation par satellites a encouragé le reste du monde à développer ses propres technologies.

Ainsi, la Russie et la Chine ont successivement mis sur orbite GLONASS (24 satellites pleinement opérationnels depuis 2011) et le réseau Beidou 1 et 2 (depuis 2000). L’Union européenne, elle aussi, développe depuis les années 2000 Galileo, déjà opérationnel, mais qui sera pleinement déployé au cours de l’année 2020 avec 24 satellites en service.

Si ces réseaux n’apportent pas d’innovation particulière par rapport à la technologie américaine existante, à ceci près que leur récence garantit une précision accrue, ils ont considérablement amélioré la qualité des données utilisées aujourd’hui par la plupart des applications.

Ainsi, l’iPhone 4S est le premier smartphone à avoir annoncé en 2011 sa compatibilité avec le réseau GLONASS. En compilant les signaux de GPS et GLONASS, l’appareil peut garantir à l’utilisateur une meilleure fiabilité des données de positionnement.

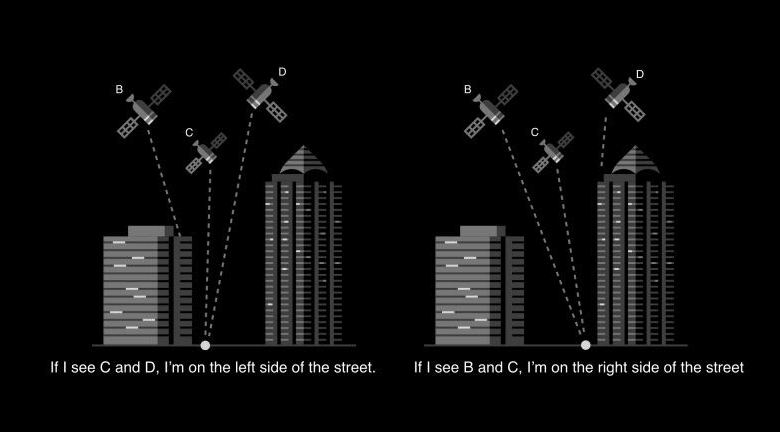

En 2019, la plupart des appareils agrègent également les informations transmises par Galileo et Beidou. Ils se reposent donc sur une armada de satellites américains, russes, chinois et européens, ce qui permet d’améliorer la qualité du signal quand la transmission est imparfaite. C’est le cas en zone urbaine, où les immeubles de grande taille et les rues étroites provoquent un effet de “canyon urbain”.

Quand le phénomène de « canyon urbain » altère la qualité du signal GPS en ville.

Les algorithmes s’en mêlent : l’avenir de la géolocalisation

Jusqu’à présent, l’acuité parfois relative de la technologie GNSS suffisait aux usages des utilisateurs. Avec l’avènement des applications de service de livraison ou de covoiturage, la marge d’erreur doit encore être réduite… à l’échelle du centimètre dans la sphère industrielle.

C’est ce que promet Broadcom avec sa puce BCM47755, qui croise pour la première fois les données des quatre réseaux de satellites internationaux avec celles émises par les capteurs d’un smartphone (accéléromètre, magnétomètre, gyroscope).

À ces innovations déjà très ambitieuses s’ajoutent les réflexions autour des algorithmes qui, couplés aux signaux des satellites, vont révolutionner la précision des applications.

Andrew Irish et Danny Iland, fondateurs de la start-up Shadow Maps acquise en 2016 par Uber, consacrent leur quotidien à combattre la réflexion du signal GPS particulièrement forte dans des villes comme New York. Tout le principe de leur algorithme repose sur l’interprétation en trois dimensions d’une carte et la prise en compte du facteur de distorsion du signal, le “rapport signal sur bruit” (SNR, pour signal-to-noise ratio).

En considérant la détérioration des signaux, en projetant ces informations sur une carte et en y ajoutant une pincée de machine learning, il devient plus facile pour les serveurs d’envoyer au chauffeur la position vraiment exacte d’un individu situé d’un côté ou de l’autre de la rue.

Comment le signal-to-noise ratio améliore l’application Uber

S’il est impossible de modifier l’architecture technique des satellites envoyés en orbite ces quarante-cinq dernières années, cette méthodologie pourrait permettre dans un futur très proche d’obtenir une précision chirurgicale pour l’ensemble des applications du quotidien.

A lire aussi sur Hello Future