Vers la décentralisation : pourquoi les SmartGrids ne seront pas des « réseaux intelligents » !

L’utilisation (que nous éviterons) de l’expression « réseau intelligent » pour traduire littéralement « smart grid » en français [3], aurait de quoi susciter des doutes chez tous ceux qui possèdent la culture « classique » des télécommunications. Cette expression a en effet désigné, jusqu’à la fin des années 1990, ce qui était l’ultime tentative de perpétuer le modèle centralisé des télécommunications « pré-internet » Essentiellement promu par les acteurs historiques (opérateurs de télécommunications et leurs équipementiers), ce modèle cherchait, pour permettre de proposer de nouveaux services sans remettre en question l’architecture du réseau, à enrichir son intelligence en la maintenant résolument dans le cœur de celui-ci et à en laisser la maîtrise à ses opérateurs. La contrepartie de la centralisation du réseau intelligent était dans le rôle « esclave » des équipements terminaux connectés à ce réseau, dont la configuration et les fonctions étaient entièrement contrôlées depuis le cœur du réseau.

Le modèle d’architecture internet était d’emblée radicalement opposé, et basé sur le principe end-to-end , d’après lequel l’intelligence applicative (du niveau de ce que les télécommunications appelaient traditionnellement des services) devait au contraire migrer du cœur vers la périphérie du réseau, c’est-à-dire sur les équipements et plates-formes d’extrémités, le réseau devant être le plus transparent et le plus passif possible, limitant son rôle à connecter ces équipements intelligents qui supportent eux-mêmes directement les applications, dont la configuration, le contrôle et l’existence même peuvent échapper entièrement au réseau. C’est ainsi qu’un article de 1997 a pu avoir un écho durable en promettant, sans crainte du paradoxe, « l’avènement du réseau stupide » comme une conquête et un progrès permettant de sortir de l’obscurantisme du réseau intelligent, désormais voué aux poubelles de l’histoire technologique…

A l’échelle de temps des technologies de l’information, l’ère de ces réseaux intelligents là peut paraître si lointaine et si définitivement révolue que ce télescopage de vocabulaire pourrait sembler ne pas mériter plus qu’une note de bas de page. Si nous l’évoquons ici c’est en fait parce que cette confusion possible recouvre précisément l’enjeu essentiel de l’évolution vers les SmartGrids, enjeu qui tourne, comme à l’époque de la transition du réseau intelligent vers l’internet, autour du choix entre architectures centralisées et décentralisées. Cette évolution a sa logique propre, et la technologie internet s’est imposée parce qu’elle est plus efficace, plus robuste et surtout plus « scalable », dans un processus autonomisé d’évolution d’un système technique (ressortissant au « technium » de Kevin Kelly) qu’on peut comparer au processus de l’évolution biologique.

« Smart Home Grid »

L’échelle la plus naturelle pour analyser les possibilités nouvelles de gestion décentralisée de l’électricité (et aussi de l’énergie en général) est celle de l’unité de base où la pénétration de l’informatique banalisée par l’internet est la plus avancée, à savoir celle de la maison.

On se place dans une perspective où un « Smart Home Grid », réseau local couplant énergie et information, intégrerait l’ensemble des équipements de la maison qui ont un impact énergétique, sans se limiter à ceux qui possèdent aujourd’hui une connexion réseau directe (voir un de nos articles de recherche pour des solutions techniques utilisables à cette fin). Il comprendrait ainsi non seulement les équipements domestiques classiques vus comme charges électriques (produits « blancs » et « bruns »), mais aussi aux équipements de stockage et de génération de l’énergie disponibles au niveau de la maison, le cas échéant. Combinée avec la disponibilité d’une information fine et complète sur les activités présence ou activités des occupants de la maison), la gestion intégrée et compréhensive de l’ensemble des équipements de la maison doit permettre une gestion locale qui aille bien au-delà d’une optimisation sous contrainte exclusive du réseau global, comme l’effacement ou le décalage de charges par rapport aux périodes de pointe, ce qui est demandé dans la perspective « évolutionnaire » d’un réseau restant géré de manière centralisée. Cette gestion locale peut correspondre d’abord à une exploitation des gisements d’efficacité énergétique pure existant au niveau de la maison, mais surtout, dans une perspective à plus long terme de généralisation de génération répartie, à l’optimisation locale qui peut permettre l’utilisation des charges par rapport à la disponibilité en puissance instantanée de sources locales (provenant typiquement d’énergies renouvelables) ou de réserves d’énergie stockées localement, l’appel à des ressources distantes étant alors vu comme un recours en cas de non disponibilité de ces ressources locales, avec une pondération en fonction du prix ou du contenu carbone de l’énergie distante

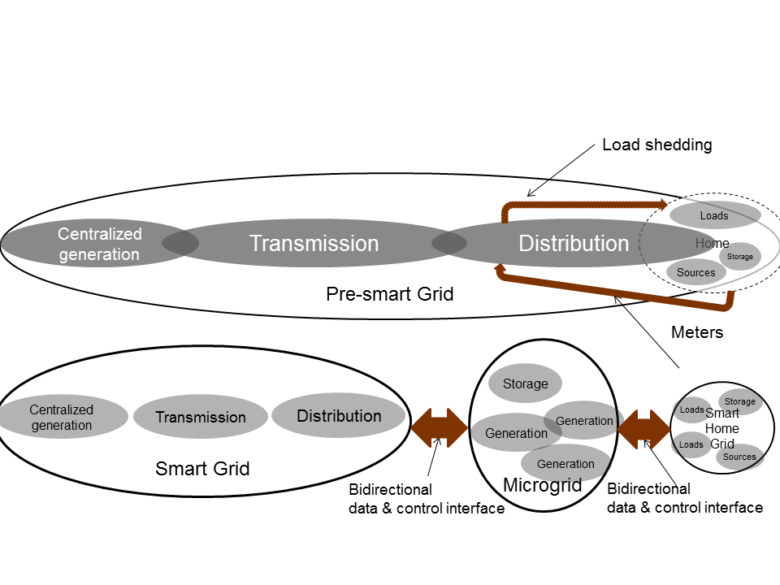

La figure ci-dessous illustre l’alternative de principe entre une optimisation centralisée, typiquement limitée à de la gestion de la demande dirigée par le réseau, et une telle optimisation locale, décentralisée à l’échelle du Smart Home Grid. Dans le premier cas, les équipements gros consommateurs d’électricité à l’intérieur de la maison peuvent être commandés directement par l’opérateur de distribution pour être délestés ou décalés en cas de besoin. Ce cas revient en fait à étendre le réseau de distribution (ou au moins sa gestion centralisée « top-down ») jusqu’à ces équipements. Dans le deuxième cas on a au contraire une autonomie de contrôle de la maison et une séparation nette entre le réseau de distribution et le Smart Home Grid, avec une interface qui permet d’échanger l’information agrégée nécessaire à l’interfonctionnement entre le Smart Home Grid et le réseau global, mais qui cache l’information purement locale à la maison et laisse à ce niveau le choix de la manière de répercuter les contraintes arrivant du niveau supérieur. Ce dernier point est conforme au principe de la « séparation des intérêts » (« separation of concerns »), universellement adopté dans la conception des grands systèmes d’information, parce qu’essentiel à la scalabilité et la robustesse de ces systèmes.

Séparation des intérêts et autonomie de contrôle des échelles « Home Smart Grid » et « Microgrid ».

De la maison aux microgrids

Partant du Smart Home Grid défini comme un sous-réseau semi-autonome à l’échelle de la maison, on peut définir des sous-réseaux similaires à des échelles plus larges, éventuellement emboitées, comme les réseaux de bâtiments, de quartiers ou de villes. L’autonomie partielle de gestion de ces réseaux peut exister déjà pour certains bâtiments non résidentiels, et à un moindre degré pour des quartiers. Elle existe de manière obligatoire pour certains réseaux de petite taille comme dans des iles, ou dans certains pays en développement où le réseau électrique n’est pas entièrement connexe. L’expression « microgrid » sous-entendant l’autonomie de contrôle au moins partielle et un équilibrage local minimal entre charges, sources et stockage est surtout utilisée pour l’échelle de quartiers, et elle a déjà été largement étudiée, même si elle est n’est déployée que dans des projets pilotes.

La décentralisation du contrôle rendue possible par ces différentes solutions ne se généralisera sans doute qu’assez lentement, mais le processus pourra reproduire certaines caractéristiques de la décentralisation des réseaux de télécommunications classique. Le processus de décentralisation opérerait lui-même très logiquement de manière… décentralisée, c’est-à-dire en partant de petits sous-réseaux périphériques pour lesquels les enjeux de sécurité ne sont pas actuellement perçus comme trop critiques.

Les modèles de contrôle adoptés pourront eux-mêmes évoluer en partant d’un contrôle traditionnel reproduisant une certaine centralisation, avec un contrôleur unique coordonnant la gestion à l’échelle de chacun de ces niveaux intermédiaires, pour aller, au moins partiellement, vers des solutions beaucoup plus radicales de systèmes multi-agents, où chaque entité connectée au réseau se voit représentée par un agent logiciel qui participe à l’optimisation globale en échangeant ses propres contraintes avec les autres agents, l’ensemble arrivant à une solution satisfaisant (de manière en général sous-optimale) l’ensemble des contraintes sans qu’un contrôleur central n’intervienne. Ces solutions largement étudiées dans les laboratoires de recherche représentent l’aboutissement ultime de la logique de décentralisation du contrôle. Dans une vision encore plus radicale et plus long-terme les échanges entre agents ne seraient pas limités à des contraintes d’optimisation mutuelle, mais serviraient de support à des enchères pour la fixation des prix auxquels des quotas d’énergie électrique seraient achetés ou vendus par des agents agissant pour le compte de charges ou des sources, respectivement. La granularité de ces enchères pourrait être temporellement aussi fine que le justifieraient les fluctuations des conditions part et d’autre, sans limite autre que celles placées par les réticences des agents humains à laisser la maîtrise de leur énergie à des agents logiciels.

On voit ainsi jusqu’où peut aller une évolution qui rend l’énergie « intensive en information » à très fine granularité, ce qui suppose une gestion de la connexion au réseau qui intègre « nativement » cette connectivité informationnelle, et pas seulement la connectivité électrique, problématique qui correspond au second aspect de la révolution des réseaux électriques.

Interopérabilité et connectivité : quand la prise électrique est un modèle pour les technologies de l’information !

Par un paradoxe dont l’ironie n’est pas toujours relevée, alors que les technologies de l’information promettent de révolutionner le réseau électrique, elles voient l’une de leurs tendances les plus récentes, l’ « utility computing », emprunter, au moins métaphoriquement, son inspiration au réseau électrique, et il s’agit bien ici du réseau électrique « pré-smart », cette relique du 20e siècle…

Sans rentrer ici dans les distinctions entre « grid computing », « cloud computing » et « utility computing [4] », le point commun entre ces tendances est l’idée d’une disponibilité de la capacité de traitement d’information qui soit aussi transparente et universelle que l’est la disponibilité de la puissance électrique au travers du bon vieux réseau électrique : il suffit de brancher, et ça marche… Cette idée implique, entre autres, la disponibilité d’une connectivité qui soit aussi simple et universelle que l’est celle de l’interface d’une prise électrique.

Le paradoxe précédent se dédouble ici en une boucle étrange, parce que si cette connectivité était effectivement simple et universelle pour le réseau électrique traditionnel [5], elle devient beaucoup moins évidente pour les SmartGrids, précisément parce qu’ils héritent des multiples niveaux de connectivité inhérents aux réseaux de données, et de la difficulté d’être compatible et d’interopérer à tous ces niveaux ! Nous essayons d’expliquer dans la suite en quoi la connectivité des SmartGrids implique beaucoup plus que le simple contact de deux fils conducteurs, et comment les notions de connectivité héritées des modèles complexes de système d’information doivent désormais s’y appliquer.

Avatars de la connectivité

Il est intéressant de repartir de l’exemple du Smart Home Grid pour illustrer ce que peut impliquer la notion de connectivité quand on passe du réseau traditionnel aux SmartGrids.

La connexion au Smart Home Grid d’un équipement, par exemple un appareil électroménager, va se traduire par le fait que cet équipement va être « reconnu », c’est-à-dire identifié individuellement et représenté en tant que tel dans un système d’information, aux fins de pouvoir au minimum offrir une interface permettant à une application informatique de le superviser et de le contrôler par l’intermédiaire du réseau de données qui fait partie intégrante du Smart Home Grid. Ce type de processus est connu sous le nom de mécanisme « plug and play » pour la connexion d’équipements du domaine des technologies de l’information, cette expression s’étant généralisée de la connexion de périphériques d’ordinateur (à quoi elle s’appliquait à l’origine) à la connexion d’équipements à un réseau. Différents protocoles assurent normalement le caractère automatique de cette reconnaissance de nouveaux équipements par les réseaux de données, mais de nombreuses difficultés apparaissent en pratique du fait de la grande hétérogénéité et diversité des équipements et des réseaux, de la non-universalité des protocoles et des différents niveaux de couches protocolaires superposées qui sont impliqués dans cette connectivité, toutes les couches devant inter-opérer à leur niveau pour que la connectivité soit assurée. Des infrastructures de haut niveau sont supposées prendre en charge des couches inférieures elles-mêmes hétérogènes, mais ne peuvent en fait reconnaître que des équipements qu’elles connaissent déjà. Sans entrer dans les détails de ces protocoles et infrastructures, on peut distinguer grossièrement un ensemble de niveaux d’interopérabilité (tous les niveaux inférieurs) pour lesquels la correspondance est d’ordre syntaxique, c’est-à-dire qu’elle repose sur la reconnaissance exacte de séquences conformes à la syntaxe [6] d’un protocole standard. Au niveau supérieur apparaît une interopérabilité de nature différente, puisqu’elle suppose la correspondance entre des notions de niveau sémantique, intégrant la signification formelle attachée aux unités syntaxiques résultant de la mise en correspondance par les niveaux inférieurs. Pour donner tout de suite un exemple qui rende concrètes ces généralités très abstraites, la connexion, assurée par un mécanisme de « plug and play » classique d’un équipement de type « imprimante » à un «Smart Home Grid» et au réseau informatique qui en constitue la couche informationnelle, peut aller jusqu’à l’échange d’une information de niveau sémantique définissant cet équipement en tant qu’imprimante, avec ses caractéristiques et les fonctions spécifiques qu’il offre. Même si ces caractéristiques n’étaient pas fournies par l’imprimante exactement avec la même syntaxe que ce qu’attend le réseau, une correspondance de niveau sémantique peut éventuellement être faite avec les informations attendues par le réseau, pour autant qu’un certain nombre de concepts communs soient partagés, ou réconciliables par approximation sémantique s’ils ne sont pas directement partagés. L’interopérabilité sémantique est donc un moyen de résoudre « par le haut » une non-correspondance syntaxique à un niveau inférieur [7]. Une application de gestion énergétique pourra elle-même disposer par une ontologie [8] partagée de la connaissance générale associée au concept d’imprimante défini à ce niveau de généralité sémantique (indépendamment d’un modèle commercial particulier, mais avec des variantes éventuelles correspondant à imprimante laser, à jet d’encre, etc.) pour savoir ce qu’il est possible ou interdit de faire avec une imprimante (par exemple ne pas la mettre en veille ou la couper tant qu’un travail est en cours, sauf cas d’urgence).

Aussi abstraites et éloignées de l’électricité que ces notions puissent paraître, la communauté des électrotechniciens en a d’ores et déjà intégré l’importance en standardisant un modèle d’information commun [9] qui est une première définition sémantique [10] des équipements connectables aux réseaux de transmission et distribution électrique, pour en assurer, par avance, la connectivité jusqu’au niveau le plus élevé qui devient effectivement pertinent pour les SmartGrids.

Oublier l’horloge : du synchronisme à l’asynchronisme

Le troisième aspect de la transformation informationnelle des réseaux électriques est le moins couramment perçu car sans doute s’agit-il d’idées qui se généraliseront à beaucoup plus long terme. Ici encore on retrouve l’analogie avec les réseaux de télécommunications classiques, qui, comme les réseaux électriques traditionnels, étaient essentiellement synchrones, par opposition au modèle asynchrone des réseaux issus de l’internet [11]. Cette opposition synchronisme/asynchronisme revêtant des sens différents et se déclinant de manière très différente suivant les niveaux auxquels elles est prise, nous l’explicitons ici en partant des notions issues des réseaux de données, pour tenter de montrer ensuite comment elles pourraient s’appliquer à l’évolution des réseaux électriques.

Synchronismes

Une distinction essentielle doit être faite entre le synchronisme absolu, qui réfère à l’alignement de processus séparés, ou de sous-ensembles d’un système, sur une horloge commune fournissant une référence temporelle partagée, et le synchronisme relatif, qui réfère à la nécessité pour des processus séparés d’avoir un « rendez-vous temporel » pour fonctionner conjointement, typiquement pour échanger des données. Le premier type de synchronisme est plutôt caractéristique des couches basses des réseaux ou de circuits électroniques, même si des alternatives asynchrones (c’est-à-dire sans horloge partagée) peuvent également être utilisées à ces niveaux. Le synchronisme relatif réfère au contraire typiquement à des couches plus élevées, et nous l’illustrerons surtout au niveau applicatif : les applications « classiques » des télécommunications comme le téléphone et la télévision, sont synchrones, au sens relatif pour la première, absolu pour la seconde. Les applications caractéristiques des réseaux internet, et qui se sont partiellement substituées aux précédentes (respectivement par exemple la messagerie et le téléchargement vidéo) sont au contraire asynchrones.

Indépendamment des changements importants d’habitudes que ces transformations représentent pour les utilisateurs, la généralisation de l’asynchronisme a des incidences techniques et économiques qui ont en fait été décisives dans l’accélération de la migration des infrastructures de télécommunications vers l’internet : l’asynchronisme est en général plus efficace et permet une meilleure utilisation des infrastructures parce qu’il permet pour celles-ci, dans l’idéal, un dimensionnement par rapport à la moyenne là ou les solutions synchrones demandent un dimensionnement par rapport au pire cas. La combinaison de différents niveaux d’asynchronisme (comme la couche IP et la couche application), a un effet cumulatif par rapport à cet avantage d’efficacité.

Des données asynchrones à l’électricité asynchrone

Le synchronisme (au sens absolu) des circuits microélectroniques et des couches basses de réseaux de données a un analogue direct pour l’électricité, qui est la synchronisation nécessaire des circuits à courant alternatif. Dans les deux cas la nécessité de maintenir cette synchronisation impose des contraintes souvent difficiles à satisfaire. Les avantages de solutions asynchrones ne sont pourtant pas décisifs aux niveaux des couches basses des réseaux de données ou pour les circuits microélectroniques, ce qui fait que le synchronisme y reste encore largement répandu, voire dominant pour la micro-électronique. Pour les circuits électriques, les avantages historiques du courant alternatif par rapport au courant continu ne sont apparemment plus aussi universels et décisifs qu’à l’époque de la « guerre des courants ». Des solutions mixtes sont aujourd’hui largement envisagées, et pas seulement aux échelles où la meilleure efficacité du transport en courant continu est décisive.

Des solutions ont été proposées dans la littérature de recherche pour une architecture de réseau électrique permettant de généraliser l’asynchronisme à ce niveau. Cette solution repose sur le découpage et le découplage du réseau en cellules entre lesquelles le synchronisme n’est plus nécessaire, puisque l’interface électrique de ces cellules utilise systématiquement une conversion AC-DC-AC. Contrairement au cas des réseaux d’information, il est difficile (voire impossible ?) d’avoir un fonctionnement asynchrone à haut niveau si l’on n’a pas aussi un découplage physique, donc un asynchronisme à bas niveau de ce type, et la justification principale de cette solution semble se trouver dans le fait de supporter l’asynchronisme aux niveaux supérieurs et d’être associée à la décentralisation du contrôle aux mêmes échelles.

Conclusion

Notes :

[1] on prend ici ce terme dans le sens d’un faisceau de ruptures technologiques concomitantes et faisant système, donc un sens proche de ce que Schumpeter appelait déjà une « grappe » (cluster) d’innovations, bien avant que Clayton Christensen ne popularise ces idées et qu’elles ne deviennent un des clichés les plus rebattus de la littérature de management.

[2] les exemples les plus connus, comme le passage de la photo argentique à la numérique, de la musique enregistrée à la musique en ligne, ou du livre papier à l’e-book, portent sur des technologies individuelles plus souvent que sur des systèmes techniques complets comme c’est le cas pour les réseaux télécoms ou les smart grids, et peuvent donc fausser la perspective.

[3] Réseau Intelligent au sens des télécommunications se traduit lui-même par « intelligent network », en anglais, où le risque de confusion avec « smart grid » n’existe donc pas.

[4] Voir « The Big Switch » de Nicholas Carr pour une perspective historique très large qui met en lumière le parallèle entre les progrès décisifs rendus possibles par la disponibilité généralisée du réseau électrique des « utilities », et les progrès et risques à attendre de l’ « utility computing », perspective qui pourrait être nuancée à la lumière du paradoxe mentionné plus haut.

[5] En laissant de côté les ajustements de tension, de fréquence, de taille physique et de forme des prises qui étaient nécessaires en passant d’un pays à l’autre, (adaptations qui restent très simples à comprendre, même pour des non-techniciens) l’interface était bien effectivement universelle, au moins à l’échelle d’un pays ou d’une zone comme l’Europe.

[6] La syntaxe en question ici est un ensemble de règles définissant une séquence correcte de signes (symboles d’un alphabet) comme conforme à un protocole, qui est en fait un cas simple de langage formel.

[7] Elle suppose néanmoins le fait que le codage et la représentation de l’information sémantique elle-même soient partagés, ce qui est en général le cas aujourd’hui avec l’utilisation de représentations basées sur XML.

[8] Une ontologie comprend, en sciences de l’information, la définition formelle de l’ensemble des entités sémantiques de base d’un domaine (ici le domaine technique des équipements connectés au réseau électrique) et de leurs inter-relations et de leurs propriétés caractéristiques pertinentes.

[9] Common Information Model (CIM) défini dans les normes IEC 61970-301 pour la transmission et IEC 61968-11 pour la distribution.

[10] Formellement une ontologie définie en UML, ou RDF/XML.

[11] Ceci n’est pas en fait contradictoire avec l’existence de couches synchrones (au sens absolu comme SONET ou relatif comme TCP) dans les réseaux de type internet et de couches asynchrones comme ATM dans les réseaux de télécommunications centralisés.

Bibliographie :

CARR N. The big switch, Rewiring the world, from Edison to Google, W.W. Norton & Company, 2009

KELLY K. What Technology Wants, Viking, 2010

Crédits Photographiques : commons.wikimedia.org