Le paradigme (ou le buzz word, selon le point de vue) du Big Data a été formulé autour des 3V (volume, vélocité et variété).

Alors que chercheurs et ingénieurs dans le monde entier travaillent à maîtriser les 3V de ce véritable data tsunami, il est important de s’interroger sur de nouveaux questionnements scientifiques moins évidents qui pourraient structurer la recherche dans ce domaine.

Lors de l’introduction d’une journée scientifique du Phi-Tab (laboratoire commun lancé entre Orange et l’Institut Mines-telecom), j’ai tenté de formuler quelques enjeux pour la recherche sur le big data

Big Algebra

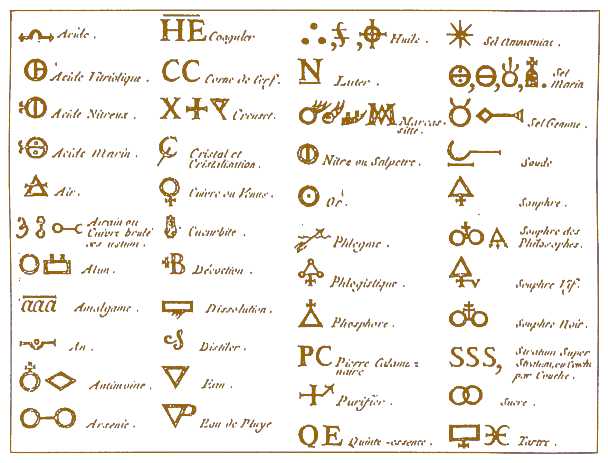

Lorsqu’il élabore une solution big data pour résoudre un problème donné, le « data scientist » ressemble beaucoup à un alchimiste. Préparation des données, choix et paramétrage de la méthode de traitement de données (ou, le plus souvent, d’une succession de méthodes), choix et paramétrage des outils de visualisation des résultats, interprétation des résultats et de leurs incertitudes… autant d’étapes complexes et enchevêtrées où son savoir faire et son expertise vont être employés.

La « chymie » avant l’invention des équations chimiques modernes – Encyclopédie de Diderot et d’Alembert – Source Wikipedia

L’invention de la notation permettant de décrire les équations chimiques a été un véritable coup d’accélérateur permettant l’apparition de la chimie moderne, comme l’invention des notations de l’algèbre moderne avait été un véritable coup d’accélérateur au développement des mathématique.

Pour noter, partager, raisonner sur les opérations du big data, ne faut-il pas inventer une notation algébrique adaptée ? Pour programmer simplement une suite de traitement big data, ne faut-il pas développer un langage informatique adapté ?

Sur le dernier point, on peut se demander si l’APL, langage mythique datant des années 70, ne pourrait pas reprendre du service… au prix d’un sérieux lifting bien sûr !

Big Noise

Les spécialistes du « Data Mining » savent bien que l’accumulation de données ne suffit pas pour extraire des informations utiles. Comme le disais Pierre Dac (ou Alphonse Allais?), « Tout est dans tout… et inversement ». Le site « Spurrious Correlations » le démontre avec humour : on trouvera toujours un « signal » (dans ce cas une simple correlation due au hasard) dans une très grande masse de données.

La question de séparer le « signal » du « bruit », l’« information » du « hasard » dans une grande masse de donnée reste largement ouverte au sein du monde scientifique.

Si des décisions d’ordre économique ou politique sont prises sur la base d’analyses « big data » par des humains (ou des machines comme dans le trading haute fréquence), des techniques de « spam/scam numériques » vont apparaître, qui consisteront à générer massivement de fausses « données » dans le but de manipuler des informations agrégées ou biaiser les décisions prises (ex : un générateur de faux tweets pour créer un buzz qui sortira tout naturellement des robots d’analyse de tweeter ; un pluggin de navigateur qui émet de fausses requêtes Google pour obscurcir la vue de Google de ce que fait réellement l’utilisateur du moteur de recherche, ce qui sape le modèle de données de Google et adsense).

Le « problème inverse » est aussi un sujet scientifique à développer largement : comment, en injectant le minimum d’information biaisée ou fausse, peut-on modifier le résultat d’une chaîne de « data mining », et en biaiser les conclusions dans un sens favorable au truqueur ? Comment prévenir et détecter de tels comportements ?

La lutte contre le « spam de données » va rapidement devenir nécessaire pour préserver la valeur du big data et les enjeux de d‘authentification des sources, de « traçabilité » des chaînes de décisions digitales seront cruciaux.

Big time

Par ailleurs, l’intégration de la dimension temporelle est mal traitée dans le big data. A titre d’exemple, identifier que le taux de natalité dépend d’évènements -divers d’ailleurs- ayant eu lieu 9 mois avant (facteurs ayant influencé la conception), et éventuellement de facteurs ayant eu lieu 20 ou 30 ans auparavant (éducation, conflits…) n’est pas à la portée de l’outillage habituel du big data. Dans le même ordre d’idée, pouvoir extraire en temps réel des informations dans un large flux de données ou d’évènements (fast data) reste difficile. Enfin, l’explosion prévisible des capteurs de l’internet des objets va générer une croissance du flux de données capturés par l’internet qui dépassera, et de loin, la croissance de notre capacité à stocker ces données. Il faudra donc choisir quelles données brutes stocker, et quelles données oublier.

La question du temps devient une dimension essentielle de la recherche en Big Data, pour discerner « la causalité » de « la correlation » mais aussi pour permettre des cycles d’analyse/décision/action temps réel et pour décider quelles données stocker.

Big structures

Les technologies du big data et du data mining ont historiquement d’abord traité des données de nature et de structures très simples : tableaux de chiffres (par exemple l’âge, le salaire, le nombre d’appels téléphoniques passés…), tableaux d’attributs (masculin ou féminin, ville du domicile…), graphes (qui est en relation avec qui ?)… En termes informatiques, on parlerait de « typage » simple des structures de données.

Visualisation d’un réseau social – Source Wikimedia

Mais les problèmes de très grandes masses de données couvrent des types de données de nature et de structures bien plus variées : images, videos, larges corpus de livres tels que ceux présents au sein de la Bibliothèque Nationale de France, représentations de l’espace géographie présentes au sein de systèmes d’information géographiques, représentations des paramètres du monde physique, de l’échelle sub-atomique à l’échelle astrophysique, représentations des paramètres du monde du vivant, depuis le déploiement d’une protéine, jusqu’à la dynamique complexe de la biosphère dans son intégralité, représentations d’objets technologiques sophistiqués…

La première ère du traitement de données massives portait largement sur des tableaux et des graphes « plats » qui sont des structures de données relativement simples : le futur devra s’intéresser à des structures de données plus complexes et hiérarchiques. Les architectures et outils pour capturer, stocker, et analyser une telle diversité de structures de données massive restent largement à inventer.

Big reality

L’explosion du Big Data permet effectivement de quantifier une part croissante de notre monde physique et d’alimenter des modèles et décisions dans un nombre croissant de domaines : le Big Data permet l’outiller l’analyse de phénomènes physiques comme la météo ou l’astronomie, des enjeux de connaissance comme le traitement du Web ou de documents, l’analyse des interactions comme par exemple les analyses basées sur les graphes sociaux. Néanmoins, le grand mirage de l’Internet amplifié par le prisme du big data entraîne un grand risque de considérer que le réel se réduit à ce qui est représenté sous forme de données. Du coup, ce qui n’a pas été mesuré est absent des analyses.

Le « mirage » du big data ne doit pas nous rendre aveugle à ce qui , dans le monde réel, n’a pas encore été quantifié.

Big human

Un dernier point d’attention porte sur les multiples facteurs humains liés au big data. Les mécanismes de fascination ou de rejet provoqués par ces nouvelles technologies entraîneront immanquablement un cortège de mythes et de peurs.

Face à la capacité limitée du cerveau humain pour se représenter de grandes quantités d’information, de nouveaux problèmes de visualisation et de représentation des données massives se poseront.

Nos mécanismes cognitifs, qui se sont construits depuis des millions d’années pour tirer le maximum d’information d’un très faible nombre de données, y compris notre intuition, seront mis à l’épreuve par ces nouvelles capacités d’analyse de données massives.

The only really valuable thing is intuition (Albert Einstein). Source Wikimedia

Les sciences statistiques ont montré au XVIIIème siècle les limites de notre intuition : la question de l’intégration des capacités du big data pour enrichir nos mécanismes cognitifs est ouverte.

Big Data évolution ou révolution ?

Au final, le big data n’est qu’une évolution technologique autour d’un simple changement d’échelle : faire rapidement et massivement ce que nous savions faire pour un petit nombre de données. Mais ce changement d’échelle est à la source d’un changement de paradigme profond, dans le champs scientifique, dans le domaine des applications, sur le plan économique et dans l’outillage du politique.

Mais la vraie révolution ne serait-elle pas dans le champs de l’humain : une nouvelle perception du monde, une redéfinition de l’intuition, un nouvel espace symbolique avec ses peurs et ses mythes ?

Bon, ça ne vaut certainement pas les 23 problèmes de Hilbert (1), mais je serais curieux de recevoir les avis de la communauté sur ces enjeux.

(1) Incidemment, Hilbert a beaucoup travaillé sur les relations entre mathématiques et intuition… s’il avait connu les Big Data, nul doute qu’il aurait aussi pensé les relations entre « big mathématiques » et intuition.

En savoir plus :

[1] Big Data – Wikipedia

[2] Alchimie et Histoire de la Chimie – Wikipedia

[3] Big Data’s Argyle Principle

[4] Les 23 problèmes de Hilbert

[5] Hilbert’s program – Standford Encyclopedia of Philosophy

Ecosystème :

Phi-TAB Coopération Orange – Telecom Paristech pour développer des méthodes d’optimisation et d’apprentissage statistique pour l’analyse de données massives. Contact Adam Ouorou – adam.ouorou@orange.com