- Décisions et connaissance

- Expériences dans la maison et l’entreprise

- IA

- Objets connectés

- Société numérique soutenable

Comment les internautes s’emparent-ils de cette proposition paradoxale de “converser” avec des automates? S’adressent-ils au chatbot comme ils le feraient avec un vendeur, ou bien l’interrogent-ils par mots-clefs, comme ils le feraient avec un moteur de recherche ? Les échanges restent-ils purement langagiers, ou bien sont-ils enrichis par d’autres formes d’interactions avec des écrans : boutons, menus, parcours guidés ? Finalement, à quoi ressemblent ces interactions entre humains et robot? L’étude présentée dans cet article apporte des éléments de réponse grâce à l’analyse des logs d’interaction avec le bot Djingo Pro, déployé depuis 2017 sur le portail Orange à destination des clients professionnels et des entreprises.

“Les logs mettent en évidence une diversité des manières d’interagir avec le chatbot, qui s’éloigne d’un modèle unique d’interactions langagières.”

Peyri Herrera – Flickr – CC BY-ND 2.0

Djingo Pro, le bot d’assistance pour les pros

L’ouverture de Messenger aux bots par Facebook en 2016 marque l’essor des chatbots : la presse professionnelle en marketing et en relation client s’intéresse à ce nouveau support d’interaction qui semble pouvoir combiner les avantages de l’automatisation et le caractère chaleureux et ouvert de la conversation (voir Dialoguer avec des machines : entre mythes et réalité). A partir de 2017, de nombreuses entreprises se lancent dans l’expérimentation de l’outil, afin d’en mesurer les potentialités et les limites.

Orange fait partie de ces pionniers, en lançant le développement d’une série de bots textuels, ou “chatbots”. L’ensemble de ces bots sont présentés aux utilisateurs comme des instances d’une interface conversationnelle unifiée et multicanale de la marque.

Le portail “professionnels” (pro.orange.fr) est l’un des premiers à implémenter une solution de bots, avec une première mise en production en septembre 2017. Il prend directement en charge des demandes d’assistance technique via son interface conversationnelle. Le premier cas d’usage concerne la récupération du code PUK, nécessaire lorsque l’on a bloqué son mobile après plusieurs saisies erronées du code PIN. Par la suite, ce périmètre fonctionnel s’est élargi rapidement : activation de carte SIM, informations sur la facture, informations pratiques générales, assistance technique internet, fixe, ou encore routage vers un conseiller et redirection vers d’autres services digitaux.

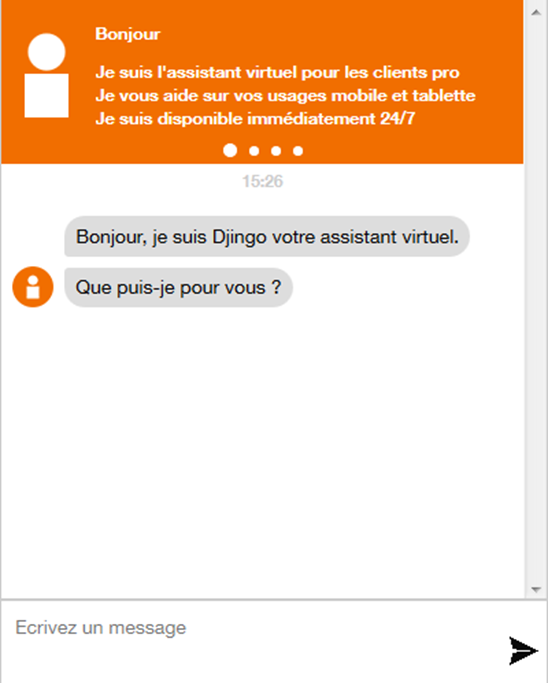

Figure 2. Djingo Pro, 2018

Pour comprendre comment les utilisateurs de Djingo Pro s’adressent à ce chatbot, cette étude s’appuie sur l’analyse des logs du bot en mai et juin 2018. Le jeu de données étudié est constitué de 2.771 séquences d’interaction avec le bot. Ces interactions ont été anonymisées, découpées en tours de parole alternatifs entre le bot et l’utilisateur. Enfin, pour analyser quantitativement les tournures de phrases employées par les utilisateurs, un étiquetage morphosyntaxique a été réalisé, un procédé automatique permettant d’identifier dans un texte les verbes, noms, infinitifs, genres, etc. Ces outils fonctionnent bien sur des textes grammaticalement “corrects” ; dans le cas présent, leur performance reste bonne car les textes des utilisateurs de ce bot sont globalement “bien” écrits.

Depuis lors, le périmètre fonctionnel de Djingo Pro ainsi que le parcours utilisateur ont évolué, et la gestion des ambiguïtés a été améliorée ; cette étude a permis d’améliorer la connaissance des usages du chatbot.

Le cadrage des interactions conversationnelles

Les interactions avec le chatbot sont globalement brèves. Une “conversation” avec Djingo Pro au printemps 2018 se déroulait sur 11,3 tours de parole en moyenne (médiane : 9). Pour l’utilisateur, cela correspond à 5,1 tours de parole en moyenne (médiane : 4). Cette longueur est bien sûr variable suivant le moment où l’utilisateur suspend l’interaction, et la capacité du chatbot à apporter satisfaction à l’utilisateur : l’authentification est un point de blocage important, et au moment de l’étude, près d’une conversation sur trois s’arrête à cette étape.

Cela étant, lorsque les utilisateurs obtiennent une réponse au besoin qu’ils expriment via le bot, les deux tiers répondent à la demande de feedback, positif ou négatif, formulée par le bot, “Êtes-vous satisfait de ma réponse ?”, près de la moitié détaille cet avis, et un tiers va jusqu’à la clôture par le bot de la conversation en écrivant “Bonne journée”. Ainsi, une part importante des utilisateurs du chatbot suit le script conversationnel et répond aux sollicitations même après avoir reçu l’information qu’elle en attendait.

Si le format de la conversation sert de cadre à l’interaction, celle-ci est très guidée dans son déroulement, schématiquement structuré en trois temps : l’expression du besoin, la réponse à ce besoin, et le feedback utilisateur. Dans un premier temps, l’interaction s’ouvre avec une question ouverte du chatbot, “Bonjour, Je suis Djingo, votre assistant virtuel. Que puis-je pour vous ?”. Cette question amène les utilisateurs à exprimer librement leur besoin ou leur situation. Une part essentielle du travail de l’équipe projet est dédiée à l’interprétation correcte de cette première requête, et à sa traduction en un besoin formalisé, une série de solutions répertoriées, et un déroulé plus ou moins long pour y parvenir, notamment lorsque l’utilisateur doit s’authentifier.

Dans le système technique du bot, ce mécanisme est présenté sous la forme d’une liste “d’intentions” auxquelles le bot est en capacité de répondre, et de “variations”, une liste des formulations des utilisateurs pouvant correspondre à ces intentions. L’équipe projet mène un effort constant d’examen des logs d’interaction pour identifier ces manières de dire afin d’améliorer l’efficacité de la reconnaissance des intentions.

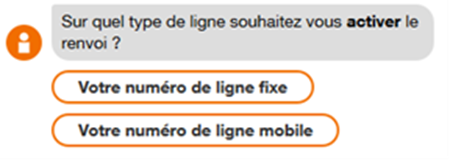

Ainsi, une fois passée la première expression de sa situation, l’utilisateur du chatbot est, dans le reste de l’interaction, guidé par le script de l’intention qui a été reconnue : dans cette seconde phase, l’interaction fait le moins possible appel à l’expression libre de l’utilisateur, mais lui propose au contraire, autant que possible, des réponses limitées sous formes de boutons.

Ce recours aux boutons-réponses est à la fois un moyen d’améliorer l’efficacité du service en explicitant les réponses attendues, et de diminuer la charge interactionnelle pour l’utilisateur, qui n’a pas à rédiger un texte mais simplement à cliquer.

Dans une troisième phase de l’interaction, le chatbot sollicite l’utilisateur sur son retour d’expérience, rouvrant la possibilité d’un texte libre, mais qui cette fois ne fait pas l’objet d’interprétation sous forme d’intention.

Ce déroulement en trois actes de l’échange avec le bot se traduit en pratique par une forte prévalence des réponses-boutons dans les interactions. La majorité (48%) des tours de parole des utilisateurs consiste en des actions sur boutons, 9% correspondent à des saisies d’identifiants à des fins d’authentification, et seuls 42% sont des écrits “naturels”, soit 2,2 tours de parole par conversation en moyenne.

Types de tours de parole des utilisateurs

Ces écrits naturels des utilisateurs sont souvent brefs : ils comptent 8,8 mots en moyenne (médiane 6, max. 141) : “il me faut mon code puk”, “code de réinitialisation du mot passe”, ou “Bonjour je souhaite désimlocker un mobile”.

Six manières d’interagir avec le bot

La manière dont l’utilisateur va formuler sa première interaction avec le chatbot est donc capitale pour le déroulement de l’interaction. C’est la demande d’expression la plus ouverte, et c’est la plus essentielle au succès de l’interaction. Comment les utilisateurs du chatbot s’expriment-ils à ce moment précis ? Sont-ils à même de formaliser un besoin explicite ? Prennent-ils la peine de rédiger des phrases complètes ?

Deux oppositions structurent les modes d’expression :

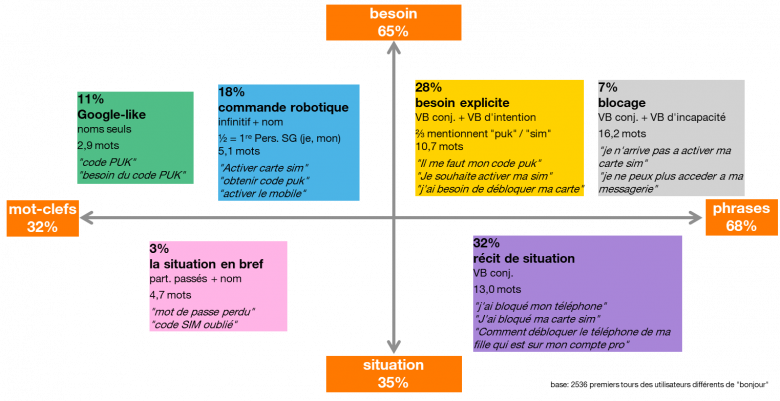

- mots-clefs (32%) vs. phrases (68%) : les deux tiers des besoins sont exprimés sous forme d’une phrase comprenant un verbe conjugué, comme “Je souhaite activer ma carte SIM”. Dans les autres cas, la forme courte est privilégiée : “code PUK”, “activer carte SIM”.

- besoin (65%) vs. situation (35%) : 65% des utilisateurs formulent un besoin explicite aligné avec le répertoire de services proposés par le chatbot : “il me faut mon code puk”, “activer carte SIM”. Les autres utilisateurs décrivent plutôt leur situation, et attendent de l’outil qu’il leur propose des solutions adaptées : “j’ai bloqué mon téléphone”, “mot de passe perdu”.

Six modalités d’expression du besoin

Le croisement de ces deux dimensions et l’examen approfondi des formulations permettent de dresser une typologie en six grandes modalités de l’expression de leur besoin par les utilisateurs du chatbot.

Dans les formes courtes d’expressions, le mode requête Google (“code PUK”, “besoin code PUK”) apparaît relativement minoritaire (11%) ; en revanche, la commande robotique reconnaissable par l’emploi de syntagmes verbaux à l’infinitif (“activer carte SIM”, “obtenir code PUK”) regroupe près d’une expression sur 5 (18%). Ces formes brèves sont largement utilisées lorsque l’utilisateur a une idée précise de ce qu’il attend du bot : bien plus rarement (3%), elles sont utilisées pour formuler une situation en bref.

Les trois autres régimes d’expression suivent le format conversationnel suggéré par le chatbot : les utilisateurs rédigent des phrases grammaticalement complexes, de plus d’une dizaine de mots, à la première ou à la troisième personne. Trois sous-groupes se distinguent. D’un côté, l’expression de besoins explicites (28%) ou de blocages (7%) correspondent à des situations où l’utilisateur sait précisément ce qu’il attend du chatbot, que l’emploi de verbes d’intention ou de verbes d’incapacité permet d’identifier : “Il me faut mon code puk”, “je n’arrive pas à activer ma carte sim”. Enfin, un tiers de ces interactions s’engagent sur un récit circonstancié de situation (32%) par l’utilisateur : “j’ai bloqué ma carte sim”, “comment débloquer le téléphone de ma fille qui est sur mon compte pro”.

Ces récits de situation et ces descriptions de blocage sont au printemps 2018 les endroits où le système du bot a le plus de mal à rattacher l’expression de l’utilisateur au registre des “intentions” prévues et codées. Là où les mentions de “code puk” ou de “activer SIM” sont facilement reconnaissables, la multitude des situations individuelles et des solutions possibles rend plus incertaine la traduction de l’expression initiale en besoin client formalisé du point de vue de l’entreprise. Fort de ces résultats d’étude, l’équipe projet s’est ainsi attelée à inclure ces types d’expressions dans l’apprentissage supervisé du chatbot.

Vers une supervision ciblée des logs

Les logs mettent en évidence une diversité des manières d’interagir avec le chatbot, qui s’éloigne d’un modèle unique d’interactions langagières. Ainsi, un tiers des utilisateurs des chatbots font l’économie de la conversation, préférant utiliser des mots-clefs comme on le fait avec un moteur de recherche ; un autre tiers s’exprime au contraire par des phrases construites, voire sous la forme de récits. Si la demande initiale est formulée de manière textuelle, une moitié des interactions ne sont pas même du texte, mais des boutons cliqués : il n’existe donc pas une usager-type, mais une pluralité d’usages et de possibilités d’utilisation de l’interface.

Cette typologie montre donc que les chatbots n’offrent pas un modèle unique d’interactions, bien que le cadrage des conversations reste crucial pour l’utilisation de l’interface ; cette diversité d’usages a permis à l’équipe projet du chabot Djingo Pro de se pencher sur ces différents modes d’interactions, afin de porter une attention particulière aux modalités d’expressions plus ambigües à traiter. Patrice Anglard, Product Owner du projet, explique ainsi que ces résultats ont permis de mieux prendre en compte la diversité des expressions des usagers, et de proposer des solutions ciblées : “La “désambiguïsation automatique” permet de prendre en charge les demandes trop vagues ou trop confuses des utilisateurs… D’un autre côté, Djingo Pro encourage aussi les utilisateurs à s’exprimer avec des phrases, lorsque ceux-ci n’utilisent que quelques mots-clés.”

Si les phrases des usagers sont trop longues, l’interface va ainsi proposer une reformulation simplifiée du propos, ou bien proposer des réponses à choix multiples. Au contraire, lorsque les expressions sont trop courtes pour que le chatbot tranche entre plusieurs réponses, celui-ci propose aux usagers de formuler une phrase complète. En prenant en compte ces deux modalités d’expression, l’interface est à même de comprendre une plus grande diversité de langage, mais aussi d’amener les utilisateurs à s’exprimer de manière plus homogène lorsque ces modalités d’expression sont trop éloignées du modèle de compréhension de Djingo Pro.

Le traitement du langage naturel ne peut fonctionner que selon une anticipation plus ou moins élargie des besoins exprimés par les utilisateurs : tandis que l’analyse du langage naturel et des interactions des usagers fait l’objet d’une activité continue de la part des équipes projets développant des chatbots, une analyse ciblée des modes d’expression des usagers permet d’approfondir les connaissances relatives aux usages de ces dispositifs, et dans le cas présent, d’en améliorer le fonctionnement au moyen de solutions basées sur les usages réels du dispositif.