“Les self-trackers qui visent par conception le changement de comportements et incorporent des normes soulèvent des interrogations concernant les conséquences de leur ‘force prescriptive’.”

La mesure ou surveillance de soi (“self-tracking”) via des artefacts techniques (carnets, balance, etc.) est une pratique très ancienne qui connait un développement sans précédent avec la multiplication des dispositifs numériques (montres ou bracelets connectés, applications pour la mesure d’activités physiques, du sommeil, etc.). Ce développement du marché des “self-trackers” peut être vu comme un phénomène plus global qui s’inscrit dans le secteur du “bien-être”, dans lequel les technologies numériques ont progressivement pris de l’importance.

Cet article [4] vise à apporter un éclairage sur la conception des dispositifs de self-tracking, notamment à partir de la littérature en Interaction Humain-Machine (“Human Computer-Interaction” – HCI) car c’est principalement dans ce domaine où ces principes ont été développés, notamment à partir de théories psychologiques de la motivation et du changement du comportement.

Les théories les plus mobilisées dans ce domaine sont la théorie de la fixation des buts (“Goal-Setting theory”), le cadre des technologies persuasives, et le modèle transthéorique du changement du comportement. Bien qu’il n’existe pas de données empiriques permettant de soutenir que les systèmes commercialisés aient été explicitement développés sur la base de ces théories, une bonne partie de ces systèmes incluent des fonctionnalités qui relèvent des principes de conception qui dérivent de ces théories. Ces principes seront ainsi illustrés par des dispositifs existants sur le marché.

La théorie de la fixation d’objectifs (“goal-setting theory”)

Développée à partir de la fin des années 60 par les psychologues Locke et Latham [5], cette théorie s’intéresse aux rôles des objectifs dans l’activité et la motivation, en particulier dans le cadre du travail. Elle décrit la manière dont les individus réagissent à différents buts, notamment du point de vue de leurs effets sur leur motivation et leur performance. Selon cette théorie, les buts dynamisent la performance, motivent les individus à poursuivre une activité, et orientent leur attention vers les comportements et les résultats pertinents. Pour qu’un objectif soit efficace en termes d’effets motivationnels, il doit être clair, précis, et difficile, tout en étant réaliste. En outre, il doit être accompagné d’un retour informationnel (“feed-back”) quant à son atteinte, d’un soutien pour l’atteindre, ainsi que de l’attribution de récompenses lors de son atteinte. Enfin, il doit avoir été établi en faisant participer tous les collaborateurs impliqués.

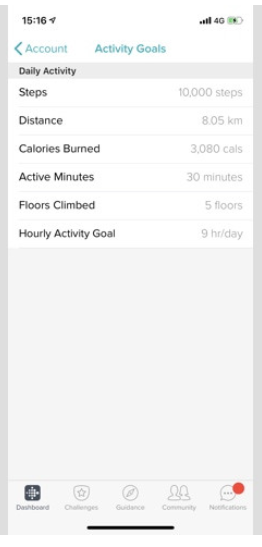

Cette théorie a été largement utilisée dans le HCI pour concevoir des “self-trackers”, notamment sous la forme de fonctionnalités de fixation de buts et de retours informationnels sur l’atteinte de ceux-ci. Ces fonctionnalités sont aujourd’hui omniprésentes dans une bonne partie de dispositifs commercialisés. Par exemple, l’application de Fitbit “charge 3” offre à l’utilisateur une interface où il peut définir ses buts (figure 1).

Figure 1 – Interface de Fitbit Charge 3 pour la fixation de buts concernant les activités physiques (nombre de pas, distance parcourue, étages montés, etc.).

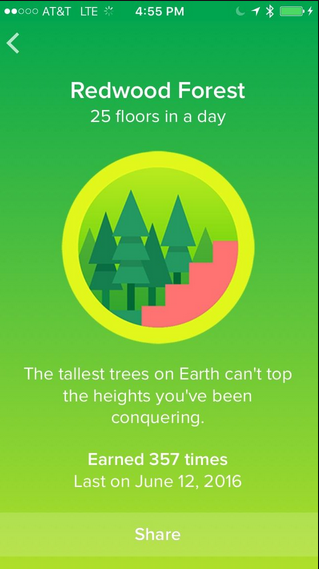

Dans ces applications, les buts peuvent être définis par défaut (par exemple, dix mille pas ou huit heures de sommeil) ou paramétrés par l’utilisateur. Des retours informationnels sur la réalisation des buts sont donnés à l’utilisateur sous différentes formes, par exemple, des nombres, des graphiques ou des notifications (Figure 2). Ces retours reposent sur une évaluation des écarts entre les buts et ce qui est réalisé à un instant donné ; ils sont parfois accompagnés de messages incitatifs à réaliser les buts fixés ou de récompenses qui relèvent de procédés de gamification ou ludification (Figure 2).

Figure 2 – Exemples de retours informationnels sur la réalisation des buts. À gauche : l’application Fitbit indique à travers un codage couleur et des anneaux les écarts par rapport aux buts (vert et anneau complet = buts atteints ; bleu et anneau partiel = buts non encore atteints). À droite : un “badge” (ludification) qui récompense l’utilisateur pour avoir monté 25 étages dans la journée.

Ces récompenses incarnent le procédé dit du “renforcement positif” développé dans le cadre du béhaviourisme [1]. Il consiste à augmenter la probabilité de répétition d’un comportement, via des “stimulus” agréables ou valorisants.

Le cadre des technologies persuasives

Les technologies persuasives constituent depuis une quinzaine d’années un domaine de recherche très actif, qui porte sur la conception et l’utilisation de dispositifs informatiques comme outils de modification des comportements. De façon générale, ces technologies sont définies comme des systèmes spécifiquement conçus pour “changer les attitudes et les comportements des utilisateurs à travers la persuasion et l’influence sociale” [6]. Une partie importante des travaux menés dans ce domaine vise ainsi à élaborer et étudier des principes de conception qui favorisent ou facilitent ces changements.

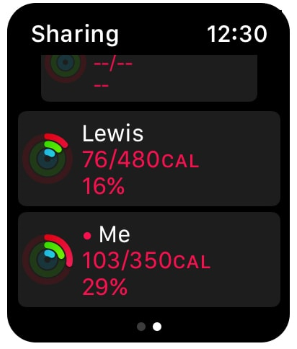

Quatre dimensions sont ainsi considérées comme fondamentales dans la conception des dispositifs persuasifs. La première concerne le soutien au développement du comportement (ou l’attitude) cible ; par exemple à travers la réduction (faire en sorte que l’effort requis pour engager l’individu dans le comportement soit minimal), la personnalisation, l’auto-suivi (“selfmonitoring”) ou la simulation (permettre à l’utilisateur d’explorer les liens entre cause et effet relatifs à ces comportements). La deuxième dimension porte sur le dialogue Humain-Machine ; il s’agit de faire en sorte que le système fournisse à l’individu des retours informationnels pour l’aider à progresser vers ses objectifs de changement de ses comportements, par exemple via des messages positifs (félicitations, compliments, etc.), des récompenses, des rappels ou des suggestions. La crédibilité du système, considérée comme essentielle à la réussite de la persuasion, constitue la troisième dimension. Elle passe par des principes de conception qui sont, par exemple, l’expertise (le système doit faire preuve d’expertise dans le domaine concerné) ; l’autorité (il doit se référer à, ou mentionner des autorités compétentes, reconnues) ; ou encore la vérifiabilité (les contenus ou informations doivent être vérifiables). Enfin, la quatrième dimension concerne l’influence sociale. Elle consiste à s’appuyer sur l’environnement social pour motiver les individus à transformer leurs comportements, par exemple, à travers la comparaison sociale, la compétition, la coopération, la “pression” normative ou la reconnaissance sociale.

Ces principes reprennent des techniques de changement de comportement déjà citées plus haut (par exemple, le renforcement positif basé sur des récompenses, ou le feed-back sur la réalisation des buts). De façon plus générale, les auteurs qui s’inscrivent dans cette approche persuasive s’inspirent de différentes théories psychologiques de la persuasion, de la motivation ou du changement de comportement. De nombreuses recherches ont mobilisé ce cadre des technologies persuasives, notamment pour la conception de systèmes visant à favoriser la santé et le bien-être. Même s’ils ne sont pas présentés comme des systèmes “persuasifs” par les entreprises qui les commercialisent, cette visée transformationnelle des comportements se retrouve assez nettement dans certains dispositifs (figure 3).

Figure 3 – Exemple de procédés d’incitation à l’activité physique et de comparaison sociale utilisée dans l’Apple watch. À gauche : une notification incitant l’utilisateur à poursuivre la réalisation de son but (“se lever et bouger”) et lui indique en même temps qu’il s’en rapproche (“you’re getting closer to your stand goal”). À droite : écran qui indique à l’utilisateur les performances physiques (nombre de calories brûlées) d’un “ami” (Lewis) qui partage avec lui ses données et réciproquement.

Cette approche persuasive a fait l’objet de nombreuses critiques, en particulier du point de vue de ses implications sociales et éthiques. Par exemple, le fait que ces systèmes peuvent “imposer” des normes de comportement qui sont définis par les concepteurs. C’est par exemple le cas des dix mille pas à faire dans la journée. Cet objectif a fait l’objet de nombreuses critiques, par exemple : il ne prend pas en compte l’intensité de la marche, constitue une norme trop élevée, et peut même être source de problèmes de santé pour certaines personnes [7]. D’autres critiques soulevées concernent les risques de manipulation ou encore l’usage par les entreprises des données personnelles collectées par ces systèmes. Par exemple une version de l’application Apple Watch pour le jeu Pokemon Go propose de comptabiliser le nombre de pas effectué, de distance parcourue ou de calories dépensées lors des chasses aux Pokémon. À première vue, cette utilisation de la chasse aux Pokémon peut être interprétée comme une source d’activité physique à encourager, mais on peut se demander si cela ne constitue pas aussi une forme d’incitation ou manipulation subtile à jouer à ce jeu. Les intentions des concepteurs posent ici question.

Ces problèmes ont ainsi conduit au développement de règles éthiques qui visent à encadrer la conception des systèmes persuasifs. Par exemple, respecter la vie privée des utilisateurs, rendre publics les buts des concepteurs et les méthodes de persuasion utilisées, ne pas concevoir des systèmes à des fins de manipulation, tenir compte de sa responsabilité en tant que concepteur pour toutes les conséquences possibles de l’usage d’un système persuasif [8].

Le modèle transthéorique du changement du comportement

Développé dans les années 70, ce modèle décrit les stades par lesquels passe un individu lorsqu’il cherche à changer de comportements [9]. Ce modèle, qui est appelé transthéorique, car il intègre des principes et des modèles issus d’autres théories psychothérapeutiques du changement du comportement, distingue sept stades, qui ne sont pas linéaires mais doivent être franchis un par un pour qu’un changement se produise et perdure : pré-contemplation, contemplation, détermination, action, maintien, rechute, accomplissement.

Pour illustrer ces stades, prenons le cas de la consommation de tabac. Au premier stade, l’individu a peu ou pas conscience d’un problème lié à cette habitude et il y a une résistance à l’idée de reconnaître le besoin de changer (il ne considère pas que fumer est un problème et ne souhaite pas s’arrêter). Lorsqu’il passe au stade de la contemplation, il commence à prendre conscience du problème et de l’intérêt qu’il pourrait y avoir à changer ses habitudes. Il pense sérieusement à changer (arrêter de fumer), mais n’est pas encore prêt à s’engager concrètement dans ce changement. Dans la phase de détermination, l’individu forme un plan d’action (par exemple, consulter un médecin pour arrêter de fumer). L’action est la phase où l’individu commence à introduire des modifications dans ses comportements (par exemple, réduction de la consommation de tabac). Le maintien décrit le stade où l’individu s’efforce de ne pas revenir à l’étape qui précède le changement. La rechute est le stade qui décrit un retour aux stades antérieurs. L’accomplissement correspond à la phase où l’individu adopte définitivement le comportement visé (arrêt de la consommation de tabac).

Selon ce modèle, la production du changement implique dix “processus” qui permettent de passer d’un stade à un autre, par exemple, la prise de conscience des causes et conséquences liées à un comportement, la réévaluation des effets de la continuation ou de l’arrêt d’un comportement sur l’environnement social, la mise en place de “stimulus” visant à favoriser le changement ou encore l’auto-renforcement. Ce modèle a été repris par quelques auteurs pour concevoir ou penser les systèmes d’auto-mesure dans une perspective d’aide au changement de comportements, par exemple, motiver les individus à adopter des comportements plus écologiques. Mais l’utilisation de ce modèle du changement de comportement dans la conception reste marginale et il semble peu probable qu’il ait été utilisé dans d’autres cadres de conception que celui de la recherche.

Conclusion

De l’examen de la littérature et de dispositifs du marché, il ressort que les principales sources théoriques utilisées (explicitement ou implicitement) dans la conception de “self-trackers” sont des théories psychologiques de la motivation et du changement du comportement. Si les “trackers” étaient au début principalement centrés sur la quantification, on voit aujourd’hui apparaître des dispositifs qui incorporent de plus en plus de fonctionnalités qui visent la transformation des comportements. Ainsi, ces dispositifs prennent de plus en plus en charge des opérations de régulation (contrôle et évaluation) des comportements sur la base d’objectifs définis par les concepteurs ou par l’utilisateur. Ces dispositifs impliquent ainsi une forme hybride de régulation distribuée de soi puisqu’une partie de la régulation est par conception “déléguée” à ces systèmes. Qui plus est, certaines entreprises comme Fitbit présentent même ces dispositifs comme des “coachs électroniques”. Le site web de l’entreprise rapporte des “histoires” qui racontent comment leurs produits ont aidé des personnes à changer leurs comportements et plus largement leur vie. Ces systèmes ne sont plus ainsi pensés comme de simples outils de quantification mais comme de véritables “agents” qui accompagnent le changement des comportements. L’utilisation de systèmes d’intelligence artificielle dans certaines applications sous forme de “chatbot” capables de dialoguer va dans ce sens (voir par exemple, la société Lark qui propose une “IA coach personnel” dans le domaine de la santé [2]).

Cependant, cette orientation consistant à développer des systèmes qui incluent des techniques de changement du comportement fait débat, notamment à propos de l’approche persuasive. Il questionne le rôle des concepteurs, ainsi que celui des technologies dans le contrôle des activités des utilisateurs. L’un des points du débat est la crainte que les systèmes développés selon cette approche prescrivent voire imposent subrepticement des normes sociales, des conduites qui sont définis par des concepteurs ou des acteurs privés voire politiques. De façon générale, il est essentiel que les questions d’ordre éthiques et sociales comme celles-ci soient prises en compte dans la conception de services de “self-tracking” qui incluent des techniques de changement du comportement. Ceci peut notamment passer par une plus grande transparence des entreprises sur les techniques et les “normes” mobilisées dans les “self-trackers” (par exemple : d’où viennent les normes ? Qui les a produites ? Quelles sont les techniques utilisées ?). Il convient aussi de s’interroger sur les implications sociales de la “force prescriptive” de ces systèmes dès lors qu’ils incorporent ces techniques et des normes. Enfin, au-delà des questions soulevées par l’utilisation de techniques de changement des comportements, se posent aussi celles qui concernent l’exploitation par les entreprises des données personnelles qui sont collectées par ces systèmes (traitement, stockage, diffusion). La récente acquisition de la société Fitbit par Google réactive des craintes quant à la manière dont Google pourrait utiliser des données personnelles [3]. Ces craintes indiquent une fois encore l’importance de la transparence des entreprises du numérique sur ce qu’elles font avec les données personnelles collectées.

Pour aller plus loin

- [1] Courant de la psychologie qui cherche à rendre compte des comportements en termes de relations entre « stimulus » et « réponses ».

- [2] https://www.lark.com

- [3] Dans un récent communiqué, Google assure qu’il protégera la vie privée des utilisateurs et que ces derniers auront un contrôle sur leurs données (https://blog.google/products/devices-services/fitbit-acquisition)

- [4] Cet article est basé sur un travail réalisé dans le cadre du projet QUANTISELF – Projet ANR 16-CE26-0009

- [5] Locke E.A., Latham G.P., « Building a Practically Useful Theory of Goal Setting and Task Motivation: A 35-Year Odyssey », American Psychological Review, vol. 57, n°9, 2002, pp. 705-17.

- [6] Fogg, B.J. (2002). Persuasive Technology: using computers to change what we think and do. Morgan Kaufmann, 2002.

- [7] https://www.theguardian.com/lifeandstyle/2018/sep/03/watch-your-step-why-the-10000-daily-goalis-built-on-bad-science

- [8] Berdichewsky D., Neuenschwander E., « Toward an ethics of persuasive technology », Communications of the ACM, vol 42, n°5, 1999, pp. 51-58.

- [9] Prochaska J. O., Velicer, W. F., « The transtheoretical model of health behavior change », American Journal of Health Promotion, vol. 12, 1997, pp. 38–48.

- [10] Zouinar, M., « Théories et principes de conception des systèmes d’automesure numériques. De la quantification à la régulation distribuée de soi », Réseaux, 2019/4 (n° 216), pp. 83-117.