Classements, palmarès, compteurs, cartes, listes, recommandations, notes… prolifèrent sur les interfaces des services du web. Ils orientent l’attention des internautes, guident leurs navigations, classent les informations, suggèrent des amis, recommandent des contenus ou personnalisent la publicité à laquelle ils sont exposés. Si le discours public sur le big data se concentre aujourd’hui sur le volume des données, le principal enjeu de ce mouvement est la capacité à interpréter ces données à l’aide de calculateurs susceptibles de leur donner du sens. Il importe ainsi de savoir comment les produits visibles du filtrage algorithmiques (compteurs, cartes, listes, recommandations, boutons…), s’ajustent ou non aux conduites et aux représentations des utilisateurs.

Deux regards sur la personnalisation

La présence grandissante de ces outils calculatoires suscite en effet de nombreux débats dans lesquels est toujours convoquée la menace de l’instauration d’une nouvelle « gouvernementalité algorithmique » (Antoinette Rouvroy, 2013 [1]). Le spectre de « Big Brother » n’est jamais loin et mêle deux risques : celui de voir le comportement des internautes prescrit et déterminé par les calculateurs des plateformes (classement, suggestion, recommandation, etc.) et celui de perdre la possession de ses données et traces personnelles. Dans cette optique, les internautes se trouveraient de plus en plus enfermés dans l’univers construit par les algorithmes du web : moteurs de recherche, ciblage publicitaire, systèmes de notation ou encore personnalisation subie et filtrage des informations. Ce dernier, particulièrement présent sur les réseaux sociaux, porterait atteinte à l’autonomie des utilisateurs et réduirait leurs capacités critiques (voir Eli Pariser, The filter bubble, 2011 [2]).

Deux conceptions s’opposent dans le débat public : d’un côté, les acteurs produisant les technologies du web défendent l’idée de la personnalisation dans le but de renforcer la qualité et la pertinence des services web, de l’autre, des « lanceurs d’alerte » s’inquiètent des menaces sur la vie privée et de la limitation des possibilités offertes aux personnes lorsque les interfaces prétendent disposer d’une connaissance calculée de leurs désirs et de leurs volontés. Les accusations envers les géants du web sont de plus en plus nombreuses. Elles combinent des critiques économiques et des craintes relatives à la gestion des données personnelles. Les internautes sont souvent pris entre ces deux logiques : à titre d’exemple, les inquiétudes toujours plus fortes à l’égard de la politique de Facebook concernant les données personnelles n’empêchent pas le réseau social de rassembler plus de 31 millions d’utilisateurs actifs mensuels en France (source: Facebook, 2016).

Plusieurs aspects de la question du guidage algorithmique des internautes méritent attention. Le premier est qu’en réalité, personne ne sait très bien ce que les internautes font, ou ne font pas, avec les métriques du web (nombre de vues, de like, de retweet, etc.) et comment elles influencent leurs comportements. Les effets des algorithmes sont le plus souvent simplement déduits des intentions de leurs concepteurs. Certains discours critiques annoncent une société orwellienne en procédant à une généralisation extensive du discours des concepteurs sur ce qu’ils essayent de faire faire à leurs outils.

Cette généralisation pose deux problèmes. Le premier est de penser que les algorithmes font véritablement le genre de chose que leurs concepteurs souhaitent leur faire faire – ce que l’histoire des sciences et des techniques dément. Le second est de concevoir les utilisateurs comme des acteurs naïfs et passifs dont les comportements seraient entièrement programmables depuis les plateformes – ce que la sociologie des usages démonte. La réalité de la force prescriptive des métriques du web est beaucoup plus complexe, incertaine et diluée.

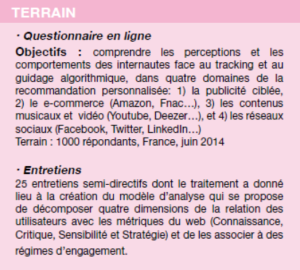

L’objet de l’enquête que nous avons menée est précisément de documenter ces pratiques numériques: comment les internautes appréhendent-ils le guidage algorithmique et l’intègrent-ils dans leurs usages sur différents types de plateformes web ?

Savoirs pratiques

Le premier résultat significatif montre que, globalement, les utilisateurs ont une faible connaissance du fonctionnement des plateformes étudiées (Google, Amazon, Facebook, YouTube, Twitter, etc.) et sont très peu critiques à l’égard du caractère contraignant de ces outils calculatoires. Seuls 16 % savent que le filtrage du fil d’actualité de Facebook est fondé sur les publications d’amis avec lesquels l’utilisateur a le plus d’interactions, et seulement 5 % savent que les résultats de la recherche sur Google favorisent en premier lieu les sites recevant des liens depuis d’autres sites web populaires (le PageRank).

Lors des entretiens, les internautes ne perçoivent pas l’idée d’un guidage ou d’une influence mis en œuvre par les plateformes, et leur principale inquiétude concerne l’exploitation des données privées. Le jugement sur les algorithmes de personnalisation est ambivalent, et varie selon les univers : la recommandation est jugée « intrusive » surtout dans le cas de la publicité (78 %) et du e-commerce (61 %), mais également pour le filtrage du fil d’actualité de Facebook (59 %). Pour autant, les internautes ne sont pas forcément opposés au principe même de cette personnalisation algorithmique : 4 internautes sur 10 jugent que la personnalisation de la publicité est « une bonne idée », et 6 sur 10 déclarent que c’est une bonne idée pour le e-commerce et la musique ou la vidéo.

Pour les utilisateurs, la connaissance des algorithmes est donc avant tout issue de leurs pratiques. Ainsi, les internautes ont souvent fait l’expérience d’une personnalisation algorithmique « ratée ». Ces ratages sont de deux natures. Dans l’univers de la sollicitation commerciale, la recommandation pêche par répétition, parce qu’elle « montre sans arrêt la même chose ». Ce type de ratage est pointé par 80 % des internautes à propos de la publicité, et 61 % à propos du e-commerce. En ce qui concerne les outils de recommandation de contenus, le manque de pertinence est le principal écueil : environ 4 répondants sur 10 ont fait l’expérience de « contenus qui ne [les] intéressent pas » dans le fil d’actualité de Facebook, ou dans les recommandations de musique/vidéo (Youtube, Deezer, etc.).

Face à des outils difficilement compréhensibles, souvent jugés intrusifs, les internautes ne restent pas passifs, et mobilisent des registres d’action variables selon les prises que les sites leur offrent. Ces moyens relèvent soit de la soustraction totale (37 % utilisent des bloqueurs de publicité, 72 % nettoient l’historique de leur navigation), soit du paramétrage (52 % tentent de désactiver les recommandations, 38 % en suppriment certaines), soit de la participation à la pertinence (29 % renseignent des goûts et des préférences, 34 % évaluent des produits ou des contenus pour améliorer la qualité des recommandations). En somme, aux deux formes de ratage des algorithmes, la répétition et la non pertinence, l’internaute oppose deux registres de réactions, relevant de l’évitement dans un cas, et de l’amélioration dans l’autre. C’est là le deuxième résultat significatif de notre enquête : les internautes ne se soumettent pas complétement aux prescriptions des algorithmes du web. Dans leurs pratiques concrètes, les internautes montrent des attitudes réflexives face aux zones calculées et aux métriques du web.

Nous identifions 5 types de couplage entre les internautes et les fonctions de guidage et de recommandation algorithmiques, cinq manières pour l’algorithme et l’internaute d’avoir prise l’un sur l’autre :

- mode HORS PRISE : ignorer l’algorithme, être indifférent, hors cadre. « Quand je publie, ce n’est que pour moi, Facebook c’est mon mémo. »

- mode EMPRISE : accepter l’algorithme, se laisser guider sans le connaître, s’en satisfaire tel quel. « Je prendrai quasiment toujours le premier ou le deuxième, c’est toujours le cas, je prends quasiment toujours le premier, le deuxième ou le troisième résultat. »

- mode PRISE : s’approprier l’algorithme, y prêter attention et en avoir une connaissance pratique, y adhérer. « Je trouve que l’algo de Spotify me correspond mieux que celui de Deezer. »

- mode REPRISE : prendre la main sur l’algorithme, être stratège, le paramétrer, l’explorer. « Les gens se connectent sur Facebook autour de 9h, 12h, 16h et 18h, alors je publie dans ces créneaux-là. »

- mode DÉPRISE : se libérer de l’algorithme, le contourner, l’éviter. « La navigation privée, je m’en sers régulièrement quand je ne veux pas qu’il y ait une trace. »

C’est donc plutôt la figure d’internautes pragmatiques, opportunistes, mobilisant localement des savoir-faire et des prises en fonction de leurs besoins et de leurs intérêts qui s’impose. Et s’il arrive en entretiens que les internautes mentionnent la thématique de l’aliénation algorithmique généralement véhiculée dans la presse, c’est toujours à la troisième personne : « des gens qui ont du pouvoir peuvent facilement se servir de ce genre d’outil pour manipuler, mais je fais attention », « les gens ne savent pas trop, et c’est assez dangereux ». En d’autres termes, le guidage algorithmique est dangereux pour les autres, mais pas pour eux-mêmes.

Pour une « culture algorithmique »

Un enjeu majeur et très clivant en termes d’usages ressort de cette enquête : celui de la « culture algorithmique » qui permet aux internautes de se positionner en connaissance de cause. Si des sujets comme les données personnelles sont particulièrement mis en avant et ont donné lieu à des campagnes de prévention et d’information, la thématique du guidage algorithmique est encore absente des initiatives. Elle paraît pourtant être un thème central dans le développement d’une « culture numérique » puisqu’elle se trouve au cœur des interactions entre les plateformes web et les utilisateurs.

Notre terrain a révélé des connaissances tout à fait inégales entre les enquêtés concernant le guidage algorithmique, pouvant parfois leur donner un sentiment d’incompétence. L’école pourrait donc être un lieu privilégié pour combattre ces inégalités. Le domaine de l’éducation est d’ailleurs traversé aujourd’hui par une véritable dynamique numérique : le MOOC « Enseigner et former avec le numérique » lancé en mai 2014 par le ministère de l’Éducation nationale à destination des professeurs et des formateurs, ou encore la formation facultative au code informatique dans les écoles primaires à la rentrée 2016 en sont de bons exemples. Il nous semble qu’un programme de sensibilisation aux algorithmes du web centré aussi bien sur leurs aspects techniques que sur la notion de guidage pourrait trouver aisément sa place au sein des différentes initiatives. Un tel programme permettrait à la fois de réduire la relative naïveté des internautes face aux dispositifs numériques et de favoriser la logique d’empowerment et de développement d’une culture numérique. Il resterait alors à construire les dispositifs adéquats afin d’accompagner cette démarche et de l’inscrire dans un parcours d’utilisation.

Parallèlement, un ensemble d’efforts serait à mener du côté des outils algorithmiques eux-mêmes pour constituer cette culture algorithmique et accompagner son inscription dans des pratiques. Il apparaît en effet nécessaire de concevoir des outils de calcul, laissant une place et une possibilité de paramétrage aux utilisateurs afin qu’ils puissent plus facilement développer des modes d’engagement de type reprise, et échapper ainsi à l’alternative « love it or leave it ». Il s’agit également, dans la conception des services, de clarifier de façon précise pour leurs utilisateurs les différentes zones calculées et d’expliciter leurs logiques.

Plus en amont, il s’agit d’enclencher un travail dès la conception des dispositifs algorithmiques, dans l’optique développée par Ann Cavoukian dans un autre domaine : elle avait proposé de faire de la protection de la vie privée une fonction inhérente aux systèmes et non pas un enjeu greffé après coup et difficile à intégrer aux pratiques à travers le concept de « privacy by design ». Appliqué à la question du guidage algorithmique, il s’agirait alors de définir des concepts tel que le « algorithm knowledge by design » ou encore le « freedom from guidance by design ».

En savoir plus :

[1] Rouvroy, A., & Berns, T. (2013). Gouvernementalité algorithmique et perspectives d’émancipation. Réseaux, (1), 163-196.

[2] Pariser, E. (2011). The filter bubble: What the Internet is hiding from you. Penguin UK.