Énergie : la blockchain accélère les microgrids

Les caractéristiques de la blockchain pourraient en faire un levier de modernisation du système énergétique.

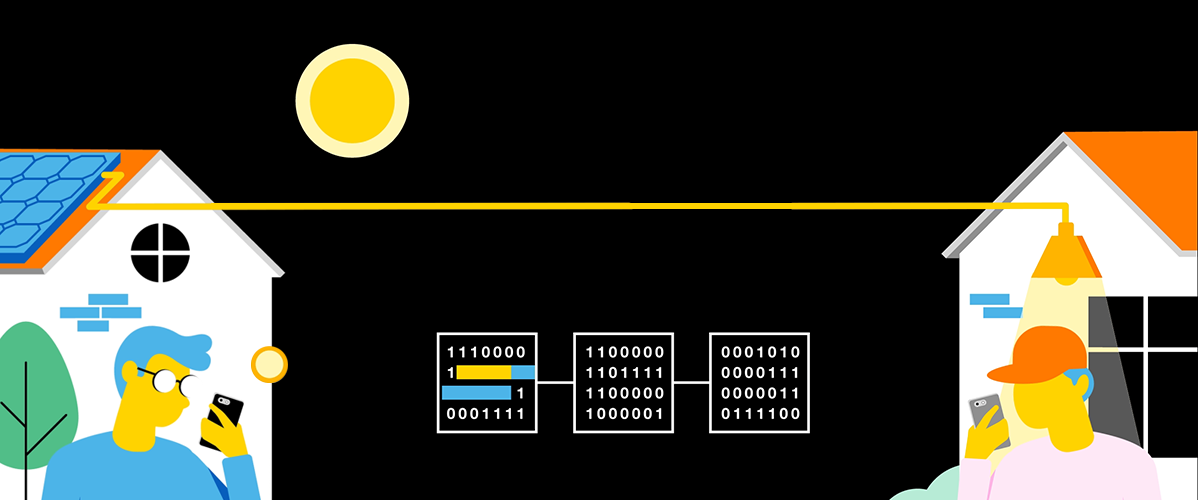

La blockchain permet d’enregistrer et de stocker de manière distribuée, sécurisée et transparente tous les flux d’énergie et de transactions. Elle peut être utilisée pour suivre en temps réel sa propre consommation énergétique ou connaître le portefeuille d’actifs de tous les participants. Elle facilite également la certification et la vérification de l’énergie, ainsi que la facturation et la rémunération des “prosommateurs” grâce à la mise en place de “smart contracts”.

Ces éléments rendent la blockchain particulièrement adaptée à la création de systèmes décentralisés, comme les microgrids. Ces réseaux de petite taille permettent la production, la consommation et le partage d’énergie entre voisins et peuvent fonctionner de manière autonome, sans être raccordés au réseau de distribution.

En 2016, la société de conseil LO3 Energy et la start-up ConsenSys ont inauguré à New York le Brooklyn Microgrid, un projet de système électrique décentralisé communautaire dans les quartiers de Park Slope et Gowanus.

Ce microgrid, construit à partir de la plateforme Ethereum, permet aux locataires d’une poignée d’immeubles équipés de panneaux solaires de suivre leur production et d’échanger les surplus d’électricité entre eux. Depuis, des dizaines d’expérimentations de ce type ont vu le jour un peu partout.

Cybersécurité : vers des chiffrements post-quantiques

La construction d’un ordinateur quantique – qui pourrait arriver d’ici une vingtaine d’années – représente une menace pour la cybersécurité.

Aujourd’hui, la quasi-totalité des communications numériques sont protégées par trois cryptosystèmes : le chiffrement par clé publique, les signatures numériques et l’échange de clés.

Ces systèmes sont mis en œuvre par des algorithmes cryptographiques asymétriques, tels que le chiffrement RSA ou l’échange de clés Diffie-Hellman, qui reposent sur l’hypothèse de difficulté calculatoire, c’est-à-dire la difficulté de résoudre, pour des ordinateurs classiques, certains problèmes mathématiques.

Or, ces problèmes pourraient être résolus facilement avec un calculateur quantique suffisamment puissant.

L’avènement de cette technologie impose donc de remplacer les méthodes de chiffrement actuelles par des systèmes alternatifs dits “post-quantiques”, capables de résister aux menaces émanant d’un calculateur quantique en se basant sur de nouveaux problèmes mathématiques.

C’est ce à quoi s’emploie le NIST (National Institute of Standards and Technology, États-Unis), qui a lancé en 2017 un appel à projets mondial pour développer, standardiser et déployer de nouveaux cryptosystèmes post-quantiques.

Santé : le deep learning améliore le diagnostic médical

L’intelligence artificielle (IA) – et plus spécifiquement les modèles de deep learning (DL) – bouleverse le monde de l’imagerie médicale, qui joue un rôle essentiel dans le diagnostic médical.

En règle générale, un radiologue examine les images acquises et rédige un rapport résumant ses découvertes sur la base duquel le médecin référent pose un diagnostic et établit un plan de traitement.

Cependant, l’interprétation d’images médicales par un humain est limitée et peut être extrêmement chronophage. Aujourd’hui, les algorithmes de DL sont suffisamment puissants pour assister les professionnels de santé dans cette tâche. L’utilisation d’outils de détection ou de caractérisation de pathologies, de quantification de l’étendue de la maladie ou d’aide à la décision est amenée à se développer dans de nombreuses disciplines.

En 2018, la Food and Drug Administration (FDA) a autorisé la commercialisation du premier dispositif médical à utiliser l’IA pour détecter la rétinopathie diabétique (une grave complication du diabète qui peut causer une cécité) sans que l’image ait été préalablement interprétée par un clinicien. Appelé IDx-DR, le logiciel exploite un réseau de neurones convolutifs (CNN) pour analyser les images de l’œil prises avec une caméra rétinienne. Si un résultat positif est détecté, le patient est orienté vers un ophtalmologiste pour une évaluation plus approfondie.

La FDA a aussi autorisé l’usage commercial de MammoScreen, un logiciel d’interprétation des mammographies numériques basé lui aussi sur un CNN. Développé par la start-up française Therapixel, MammoScreen avait remporté la première place du Digital Mammography DREAM Challenge en 2017.

Industrie : le nouveau paradigme de la cobotique

La cobotique – la collaboration humain-robot – se développe progressivement dans l’industrie où elle partage les mêmes objectifs que la robotique “classique” (gain de productivité, ergonomie, sécurité), mais présente plusieurs avantages.

À la différence du robot industriel traditionnel, le cobot est conçu pour travailler aux côtés des humains sans cage de sécurité. Il peut être programmé plus facilement et rapidement, et avec plus de flexibilité pour effectuer une grande variété de tâches.

La cobotique entraîne également un changement de paradigme : si l’automatisation se traduit par un transfert de compétences de l’humain vers la machine, la cobotique, elle, suppose la mise en commun des compétences, le rôle de la machine étant d’assister – et non remplacer – l’opérateur humain en démultipliant par exemple ses capacités pour manipuler des pièces lourdes.

Fondé en 2005 par trois universitaires, le fabricant danois Universal Robots domine ce domaine encore émergent avec 50 % de parts de marché. Il affirme avoir commercialisé 35 000 bras robotiques depuis sa création.

La start-up deep tech américaine Covariant, elle, veut donner un cerveau aux cobots, en développant une couche d’IA pouvant être ajoutée à n’importe quel robot, dans n’importe quel environnement, lui permettant de s’adapter à de nouvelles tâches par un processus d’essais-erreurs en s’appuyant sur un apprentissage par renforcement profond.

Informatique : la révolution neuromorphique

Les progrès en matière d’IA et de DL ont inspiré le développement de nouvelles architectures matérielles adaptées à des applications spécifiques, comme la reconnaissance d’image ou le traitement de la parole. Si certaines d’entre elles, comme les GPU (Graphics Processing Unit), se sont révélées très performantes dans les tâches d’IA, un problème subsiste : le déplacement des données de la mémoire vers le processeur et inversement crée non seulement des latences (“goulot de von Neumann”), mais il consomme aussi d’énormes quantités d’énergie.

C’est là qu’interviennent les puces neuromorphiques, dont la conception est totalement différente. Elles imitent la structure et le fonctionnement du cerveau humain, qui utilise les neurones et les synapses dont il a besoin pour effectuer des calculs avec une efficacité énergétique maximale.

Comme le cerveau humain, elles sont moins puissantes que les processeurs traditionnels, et ne peuvent pas effectuer un grand nombre d’opérations simultanément. Mais, étant spécialisées dans leur tâche, elles peuvent exécuter des opérations de réseaux de neurones artificiels à une vitesse plus rapide et en consommant beaucoup moins d’énergie, le tout directement dans le système sur lequel elles sont embarquées (sans reposer le cloud, donc). Cela pourrait changer radicalement le paysage de l’informatique moderne.

Le processeur Loihi développé par Intel Labs comprend 130 000 neurones et 130 millions de synapses. Selon le fondeur, Loihi traite les informations jusqu’à mille fois plus rapidement et dix mille fois plus efficacement que les processeurs conventionnels.