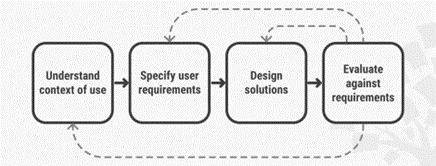

L’IA basée sur l’apprentissage, en particulier profond, soulève d’importantes difficultés de compréhension de leur fonctionnement, liée au fait qu’elle génère des modèles d’IA dits « ». Ces difficultés ont des incidences sur les usages des Systèmes d’IA (SIA). Par exemple, un médecin peut vouloir comprendre pourquoi un SIA diagnostique une maladie ou préconise un traitement, un conseiller client peut vouloir comprendre pourquoi un SIA lui recommande de faire une offre donnée à un client. Face à ce type de situations, des travaux visent précisément à générer et apporter des explications aux personnes concernées. C’est ce qui se réfère au champ de l’explicabilité, dont le but est de trouver les moyens permettant de rendre compte ou expliquer les résultats produits par les SIA [Explicabilité des systèmes d’intelligence artificielle : quels besoins et quelles limites ?]. Il existe aujourd’hui toute une panoplie de méthodes visant à générer des explications [Comment rendre l’IA explicable ?]. Mais comment concevoir les explications nécessaires aux utilisateurs finaux ? Développée dans les champs de l’ergonomie et l’interaction Humain-machine et utilisée depuis longtemps pour la conception de systèmes interactifs dans différents domaines, la démarche de la conception centrée utilisateur (figure 1) s’avère particulièrement pertinente et est mobilisée dans un nombre croissant de recherches sur l’explicabilité de l’IA dans différents domaines [1].

Les principaux enjeux de l’explicabilité sont de faire en sorte que les SIA soient intelligibles, adaptés aux utilisateurs, à leurs buts et à leurs activités.

Figure 1. La démarche de Conception Centrée Utilisateur [2]

L’analyse du contexte d’usage est fondamentale pour déterminer les destinataires potentiels d’explications (qui sont-ils ?) et leurs besoins en explications (dans le cadre de quelles activités auront-ils besoin d’explications ? Pour quoi faire ? A quel moment ? Pour quel SIA conviendrait-il de générer des explications ?). Pour des SIA destinés à être utilisés dans un contexte de travail, la compréhension des activités est fondamentale pour déterminer les explications idoines. Dans cette perspective, différentes méthodes de recueil de données peuvent être mobilisées (entretiens, observations, analyse documentaire). Cette phase est également cruciale pour élaborer les explications adaptées au profil de l’utilisateur. Par exemple, dans le contexte d’un SIA conçu pour recommander un produit à un client, une explication technique destinée à un data scientist ne sera pas adaptée à un conseiller clients. Pour ce dernier, il n’est pas utile par exemple, que les explications couvrent la totalité des variables ayant supposément influencé la recommandation faite par le SIA, la communication de deux ou trois facteurs clés peut être suffisante.

A partir de l’analyse du contexte, la deuxième étape consiste à spécifier précisément les explications nécessaires (ou potentiellement utiles) à fournir aux destinataires selon leur profil. Les explications peuvent être de différents types : elles peuvent être contrastives (pourquoi une prédiction a été faite plutôt qu’une autre), contrefactuelles (en faisant varier une variable pour voir son influence sur la prédiction), ou basée sur des exemples ou sur l’importance de la contribution des variables. Le choix du type d’explications doit être réalisé en fonction du contexte d’utilisation et des besoins utilisateurs. Cette étape consiste également à préciser comment ces explications seront fournies (Comment doivent-elles être présentées ? Avec quel degré de détail ? De quelle manière seront-elles accessibles ? Via quel type d’interface utilisateur ? etc.). Ceci peut se faire en construisant des scénarios d’utilisation qui illustrent l’utilisation potentielle des explications.

La troisième étape est celle de la conception proprement dite des explications et du support qui les rendra accessibles, c’est-à-dire l’interface utilisateur (format des explications, modalités d’interaction, etc.). Il existe tout un corpus de connaissances pour la conception d’IHM qui peut être mobilisé dans cette phase sur ces aspects IHM (Interface utilisateur et Interaction Humain-machine). A ce stade, il s’agit de produire une maquette ou un prototype du dispositif de présentation des explications. Il est en effet important de garder à l’esprit qu’outre les explications proprement dites, il s’agit de concevoir une interface utilisateur pour les présenter et qui impliquera de l’interaction avec l’utilisateur. L’objet de conception n’est donc pas seulement les explications mais aussi une interface utilisateur qui les médiatise.

La quatrième étape est celle de l’évaluation du résultat de la phase précédente, c’est-à-dire de la maquette ou du prototype du dispositif d’explications. Il existe plusieurs méthodes d’évaluation, la plus fondamentale étant la réalisation de tests utilisateurs, le plus souvent en laboratoire. Les tests consistent à confronter des utilisateurs potentiels à un système afin de l’évaluer relativement à des critères définis, comme l’ ou l’utilité. Pour ce qui est de l’explicabilité, selon les contextes d’usage, ces critères peuvent être :

- L’adéquation des explications à l’usage qui est prévu (la finalité de l’explicabilité) : par exemple, dans quelle mesure les explications permettent-elles au destinataire d’atteindre ses buts (par exemple, comprendre pourquoi un système diagnostique telle ou telle maladie, pourquoi un système propose telle ou telle recommandation d’offre commerciale à un client) ?

- L’adaptation de l’explicabilité aux destinataires : par exemple, dans quelle mesure les explications (leur contenu en particulier) sont-elles adaptées aux destinataires (par exemple, à leur expertise) ?

- L’intelligibilité des explications fournies : par exemple, dans quelle mesure sont-elles compréhensibles, interprétables par les destinataires visés ? Quel « coût cognitif » représente leur compréhension ?

- La confiance dans le système : par exemple, dans quelle mesure le destinataire considère-t-il les explications fournies comme étant fiables ou justes, quelles conséquences ont-elles sur la confiance de l’utilisateur dans le système ?

- La compréhension du fonctionnement du système : par exemple, dans quelle mesure les explications favorisent-elles une compréhension plus globale du système ? Une telle compréhension est-elle utile voire nécessaire ?

Les tests utilisateurs peuvent être complétés par des questionnaires spécifiques. Par exemple, le System Causability Scale [3]. Dans cette approche, la « causabilité » qui vise à déterminer dans quelle mesure l’explication d’une sortie d’un système d’IA à un utilisateur permet d’atteindre un niveau spécifié de compréhension causale avec efficacité, efficience et satisfaction dans un contexte d’utilisation spécifié. Il existe d’autres échelles dites d’utilisabilité plus larges qui peuvent également être mobilisées [4].

S’ils sont fondamentaux pour l’évaluation, les tests utilisateurs réalisés hors situation d’usage réel (par exemple, en laboratoire) ne sont cependant pas suffisants. Il est également important de réaliser des évaluations en conditions réelles sur des temps longs. Par exemple, il peut être intéressant d’étudier les conséquences de l’apport d’explications sur la manière dont la relation des utilisateurs au système évolue en termes de confiance.

Il est par ailleurs fondamental d’impliquer les destinataires des explications à chacune des étapes de la conception centrée utilisateur. Cette implication prend différentes formes : rencontrer les destinataires potentiels pour comprendre leurs activités et définir avec eux leurs besoins en explication, leur montrer des productions (maquette/prototype), les solliciter pour les tests utilisateurs. Il est également important de comprendre que l’explicabilité n’est qu’un aspect de l’interaction avec un SIA. Elle n’a de sens que pour un SIA qui est (potentiellement) pertinent en termes d’usage et dont le fonctionnement est fiable.

Enfin, d’un point de vue technique, il convient de faire preuve de prudence vis-à-vis de ce qu’il est possible d’obtenir comme explications. Elles peuvent en effet être trompeuses ou incomplètes. Il importe donc de s’assurer de la fiabilité des explications et de bien déterminer les limites de celles-ci précisément en termes d’explication du fonctionnement d’un SIA, en particulier pour les modèles boîtes noires. Le choix du type de technique d’explicabilité s’avère donc crucial.

Conclusion

La Conception Centrée Utilisateur ou, plus largement, Humain est une démarche qui a pris une grande importance dans les recherches sur l’explicabilité et, de façon plus générale, l’Intelligence Artificielle.

Les principaux enjeux de l’explicabilité sont de faire en sorte que les SIA :

- soient intelligibles, adaptés aux utilisateurs, à leurs buts et à leurs activités,

- présentent le meilleur degré d’utilisabilité possible, sans être délétères ni en termes d’effets sur l’activité ni en termes d’incidences sur les utilisateurs ou toute personne pouvant être indirectement impactée par l’utilisation de ces systèmes.

Sources :

[1] https://arxiv.org/abs/2002.01092

[3] https://arxiv.org/abs/1912.09024

[4] https://www.nngroup.com/articles/measuring-perceived-usability/

Un modèle d’IA est un programme ayant été entraîné sur un ensemble de données pour réaliser des tâches, par exemple pour classifier des images ou des sons, fournir des estimations ou produire des contenus. Le modèle correspond au programme obtenu après entrainement. Un modèle est qualifié de boite noire lorsque son fonctionnement est opaque, difficile à comprendre.

Degré selon lequel un système peut être utilisé, par des utilisateurs identifiés, pour atteindre des buts définis avec efficacité, efficience et satisfaction, dans un contexte d’utilisation spécifié.