Méthodes permettant à une machine d'évoluer par un processus systématique et d'adapter ses analyses et ses comportements en se fondant sur l'analyse de données empiriques provenant d'une base de données ou de capteurs. Il est utilisé dans la détection de fraudes, l’aide au diagnostic, la robotique, etc.

Ensemble de techniques d'apprentissage automatique basé sur des réseaux de neurones artificiels composés de milliers d'unités de calculs et organisés en couches. Il est utilisé pour la reconnaissance d’images, la traduction automatique, le traitement du langage naturel, etc.

Programmes capables d’effectuer des tâches comme commander vocalement des billets de train, chercher une séance de cinéma, etc. On les trouve dans les smartphones (Siri d’Apple, S Voice de Samsung), les ordinateurs (Cortana de Microsoft), les enceintes connectées (Alexa d’Amazon, Google Home et bientôt Djingo d’Orange).

La singularité marque l’apparition d’une super intelligence artificielle qui s’auto-améliore jusqu’à dépasser l’intelligence humaine, ce qui pourrait signifier la fin de l’humanité. Une possibilité remise en cause par de nombreux scientifiques.

Mouvement prônant l'usage des sciences et des techniques pour améliorer les caractéristiques physiques et mentales des êtres humains (symbole H+ pour Humanity+). Le promoteur le plus connu de cette idéologie est Raymond Kurzweill, directeur de l’ingénierie et de la recherche chez Google.

Un chatbot ou agent conversationnel est un programme informatique capable de dialoguer en mode texte ou vocal avec des utilisateurs, souvent au sein d‘une application de messagerie. L’IA leur permet de s’améliorer au fur et à mesure de leur utilisation.

Ce test mis au point en 1950 par le mathématicien Alan Turing consiste à mettre un humain en confrontation verbale à l'aveugle avec un ordinateur et un autre humain.

L’IA dite faible désigne des algorithmes spécialisés et dédiés à une tâche spécifique : assistant personnel, voiture autonome, traducteur automatique, reconnaissance d’images, etc. Toutes les IA actuelles sont faibles.

L’IA dite forte est capable de s’autoalimenter et d’évoluer, et de reproduire les comportements humains jusqu’à l’acquisition d’une conscience propre, ou singularité (voir ce mot).

La voiture (ou camion ou bateau ou train) autonome est un véhicule capable de se déplacer sans l’intervention d’un conducteur humain grâce à une IA couplée à des systèmes de détection et de reconnaissance de formes (caméras, radars, lidars, sonars).

La cobotique, ou robotique collaborative, consiste à construire des robots qui aident l’opérateur humain dans des tâches ou des situations particulières (milieu industriel, milieu subaquatique ou hostile à l'homme).

C’est un processus décrit par l’économiste autrichien Jospeh Schumpeter qui voit se produire de façon simultanée la disparition de secteurs d'activité économique conjointement à la création de nouvelles activités économiques, le moteur de ce phénomène étant l’innovation technologique.

L’uncanny valley (ou vallée dérangeante) est une théorie du roboticien japonais Masahiro Mori selon laquelle plus un robot androïde est similaire à un être humain, plus ses imperfections nous paraissent monstrueuses.

L'analyse (ou logique) prédictive englobe une variété de techniques issues des statistiques, d'extraction de connaissances à partir de données et de la théorie des jeux qui analysent des faits présents et passés pour faire des hypothèses prédictives sur des événements futurs.

La génomique est une discipline de la biologie moderne. Elle étudie le fonctionnement d'un organisme, d'un organe, d'un cancer, etc. à l'échelle du génome, au lieu de se limiter à l'échelle d'un seul gène.

Dossier : l'Intelligence

Artificielle,

entre espoirs

et dangers

pour l'Homme

Progrès ou cauchemar ? Certains s’inquiètent de l’arrivée de robots intelligents destructeurs d’emplois, voire d’une IA consciente qui remplacerait l’humanité. D’autres y voient au contraire un nouveau champ de progrès pour l’Homme. Décryptage, entre fantasme et réalité.

Les progrès rapides de l’intelligence artificielle (IA) annoncent une nouvelle ère, celle des machines capables d’apprendre par elles–mêmes

( ) et de mimer les réseaux de neurones du cerveau humain pour un apprentissage profond ( ). Certes, aujourd’hui, l’IA est encore limitée. Les algorithmes d’IA sont très performants pour certains types de tâches bien précises, mais sont loin d’égaler les capacités cognitives très diversifiées d’un petit enfant. Et les type Djingo d’Orange ou Alexa d’Amazon ne peuvent pas encore tenir une vraie conversation, ou comprendre des subtilités fines de la langue naturelle comme peut le faire une être humain. Le dialogue reste très pragmatique et orienté vers un but précis. Mais dans un futur plus ou moins proche, nous pourrions assister à la naissance de la machine consciente ou .

Demain, Matrix ? Selon Raymond Kurzweil, pape du qui travaille chez Google, cette IA dotée de son propre libre arbitre dépassera l’homme et pourra fabriquer des machines encore plus intelligentes. Une perspective effrayante qui rappelle le film « Matrix » ou le Skynet de la saga « Terminator ».

Néanmoins, la plupart des scientifiques restent sceptiques face à ces prévisions apocalyptiques, même si certaines figures respectées de la sphère technologique (Stephen Hawking, Elon Musk, Bill Gates) ont exprimé leur inquiétude.

D’autres, au contraire, mettent en avant les nombreux services que vont rendre l’IA dans la santé (prédiction des cancers, génétique), le transport (voiture autonome, drones), environnements Informatiques pour l’Apprentissage Humains (EIAH), le spatial (robots sur Mars ou d’autres planètes), la banque (Il s’agit de robot-advisor.), les services clients ( ) ou le marketing (assistants personnels).

Entre fascination et répulsion, l’intelligence artificielle ne laisse personne indifférent.

Les autorités scientifiques, les chercheurs et les chefs d’entreprise se saisissent de cette question, à l’instar d’Orange qui voit cette révolution riche de promesses mais qui doit bénéficier au plus grand nombre.

Une brève histoire de l’IA

Au commencement étaient les ordinateurs. Puis Alan Turing invente le test qui porte son nom. En 1956, le séminaire du Darmouth College marque les débuts de la recherche en intelligence artificielle. Voici les principales étapes d’une marche en avant qui n’est pas achevée.

1943

La naissance des ordinateurs

Les premiers ordinateurs voient le jour. Construits avec des technologies qui précédaient les circuits intégrés (tubes à vide, relais électromécaniques), ils sont peu performants.

1950

Le test de Turing

Le mathématicien britannique Alan Turing publie son article "Computing Machinery and Intelligence" et met au point son test à l’aveugle pour déterminer qui est l’humain ou l’ordinateur.

1950

La première machine capable d’apprendre

Claude Shannon développe Theseus, une souris électromécanique capable d’apprendre à trouver la sortie d’un labyrinthe. Avant même l’apparition du terme "intelligence artificielle", il s’agissait de la première démonstration effective d’une machine capable d’apprendre.

1956

Le séminaire du Dartmouth College

Le séminaire du Dartmouth College, aux Etats-Unis, invente le terme d'Intelligence Artificielle (IA) et aboutit à la création de concepts qui marquent les débuts de la recherche en IA.

1958

Le "list processing"

John McCarthy, co-organisateur du séminaire du Dartmouth College, créé le langage informatique LISP (mot forgé à partir de l’anglais "list processing") qui permet de faciliter la programmation d’IA.

1959

Le "General Problem Solver"

Herbert Simon et Allen Newell inventent le General Problem Solver, une stratégie de résolution de problèmes largement utilisée dans le domaine de l'intelligence artificielle.

1965

Le programme Eliza

Eliza est un programme informatique écrit par Joseph Weizenbaum, capable de dialoguer en anglais en incarnant le rôle d’une psychologue.

1974

Le système MYCIN

MYCIN est un système expert utilisant l’IA pour identifier des bactéries causant des infections sévères et recommander des antibiotiques en adaptant le dosage au poids des patients.

1996

La victoire de Deep Blue

Le champion d’échecs Garry Kasparov est battu par le superordinateur Deep Blue d’IBM. Un événement qui démontre que l’IA est plus performante que l’homme dans certains domaines précis.

2005

Le robot Stanley

En 2005, Stanley, un robot construit à l’université Stanford, remporte le "DARPA Grand Challenge" en conduisant de manière autonome pendant 131 miles sur une piste de désert sans avoir fait de reconnaissance préalable.

2011

Le programme Watson

Le programme d’IA Watson d’IBM surclasse les meilleurs joueurs du jeu télévisé américain de questions réponses Jeopardy !

2017

Les chatbots

Les agents conversationnels, ou chatbots, sont devenus omniprésents dans les services clients des marques. Ces programmes informatiques sont capables de simuler une conversation avec un ou plusieurs humains par échange vocal ou textuel.

2018

Réseaux à capsules

Les CapsNet, ou réseaux à capsules, ont été développés par Geoffrey Hinton, chercheur anglo-canadien spécialiste des réseaux de neurones artificiels. Ce routage dynamique entre capsules permet d’améliorer les performances des algorithmes de reconnaissance visuelle.

Vous avez dit IA ?

L’intelligence artificielle tient le haut du pavé depuis quelques mois.

Mais que recouvre exactement cette expression ?

Où en est-on de ses progrès ?

C’était la vedette de la deuxième édition du salon Viva Technology, en juin 2017 à Paris : l’intelligence artificielle. Pas surprenant car, comme l’a noté Stéphane Richard, le PDG d’Orange, lors d’un « keynote », « l’intelligence artificielle est entrée dans une nouvelle dimension, grâce aux progrès du deep learning (apprentissage profond) qui lui ont permis de devenir une technologie beaucoup plus fiable ». Et d’illustrer son propos par deux chiffres : 75 %, c’était en 2011 le taux de reconnaissance d’objets dans une image ; on est aujourd’hui à 97 %, « même si la lumière est pauvre ou l’image floue ». Comme Stéphane Richard l’a souligné, « cette tâche est réalisée par l’IA avec un résultat bien meilleur et une rapidité supérieure à ce que peut effectuer n’importe quel opérateur humain ». Pour le patron d’Orange, « nous sommes à un moment décisif de l’histoire en termes de rythme d’innovation et de potentiel disruptif dans tous les secteurs ».

« Nous sommes à un moment décisif de l’histoire en termes de rythme d’innovation et de potentiel disruptif dans tous les secteurs »

Stéphane Richard, PDG d'Orange

Mais qu’est-ce donc que cette IA qui fait les gros titres et suscite autant d’interrogations que d’espoirs ou d’inquiétudes ? Nicolas Demassieux, directeur de la recherche d’Orange, plante le décor : « l’IA cherche à reproduire les capacités cognitives de l’être humain avec des algorithmes et des ordinateurs ». Selon Jean-Gabriel Ganascia, enseignant à l’université Pierre et Marie-Curie et chercheur au CNRS, qui intervenait lors du dernier festival Futur en Seine, en juin 2017, « le terme a été introduit en 1956 par deux jeunes mathématiciens qui ont eu l’idée d’étudier l’intelligence avec les ordinateurs, apparus dix ans auparavant. Leur but : décomposer l’intelligence en fonctions élémentaires et simuler chaque fonction avec un ordinateur. Par exemple : le raisonnement, la reconnaissance des objets sur des images, le langage naturel, etc ».

Deep learning et machine learning.

Ces deux jeunes chercheurs sont John McCarthy du Dartmouth College et Marvin Minsky de Harvard. Avec Nathaniel Rochester d’IBM et Claude Shannon de Bell Telephone Laboratories, ils organisent cette année-là un séminaire au Dartmouth College, université privée du New-Hampshire (États-Unis). C’est le début des recherches en intelligence artificielle. « Nous tenterons de découvrir comment une machine pourrait utiliser le langage, créer des abstractions et des concepts, s’améliorer elle-même, résoudre des problèmes qui sont aujourd’hui l’apanage de l’intelligence humaine », écrivait à l’époque John McCarthy.

Avant ce séminaire fondateur, le mathématicien anglais Alan Turing avait mis au point son célèbre décrit dans une publication fondatrice1 . Il s’agissait de faire converser un humain avec d’autres personnes et un ordinateur. Si la personne n’était pas capable de différencier les hommes de la machine, celle-ci avait réussi le test.

L’apparition récente des techniques d’apprentissage profond et l’apprentissage automatique font bondir les performances des algorithmes

Mais durant plusieurs décennies, les recherches stagnent sans découvertes majeures. Jusqu’à l’accélération récente des techniques d’apprentissage automatique, ou « machine learning », vers des techniques d’apprentissage profond, « deep learning », qui a fait bondir les performances des algorithmes et leur a permis de s’attaquer à des tâches bien plus complexes.

Le machine learning permet à une machine d’adapter ses comportements en se fondant sur l’analyse des données à sa disposition. Un robot peut ainsi apprendre à marcher en commençant par des mouvements aléatoires, puis en sélectionnant les mouvements lui permettant d’avancer.

Le deep learning est la branche du machine learning qui utilise comme modèles mathématiques les réseaux de neurones formels, eux-mêmes construits sur la représentation mathématique et informatique d’un neurone biologique, née en 1943.

« Depuis cinq ans, on observe une accélération indubitable des performances de l’IA. Par exemple, la reconnaissance de formes ou d’objets dans les images. Sur cette tâche précise, on peut affirmer que l’IA est meilleure que l’homme », décrit Nicolas Demassieux, qui travaille sur l’intelligence artificielle depuis les années 1980. « Le français Yann Le Cun, responsable du programme IA de Facebook, a démontré en 2010 que, sur d’immenses quantités d’images, il obtenait de meilleures performances avec l’IA qu’avec les autres techniques », ajoute Jean-Gabriel Ganascia. Même efficacité de l’intelligence artificielle pour la détection d’un cancer de la peau à partir d’une coupe histologique (tranche d’un organe suffisamment fine pour pouvoir être observée au microscope), qu’a réussi récemment le programme Watson d’IBM.

Le domaine médical est un des secteurs clefs de l’IA.

IA faible, IA forte.

Mais si les progrès de l’IA sont réels, celle-ci est toujours qualifiée de , en opposition à l’IA et consciente d’elle-même que prédisent les transhumanistes. Vous applaudissez le superordinateur Deep Blue d’IBM qui a battu le champion d’échecs Garry Kasparov dès 1997 ? Vous saluez le programme informatique AlphaGo de Google DeepMind qui a vaincu le champion du monde de jeu de go l’année dernière ? Désolé, mais ce sont des IA faibles ! De même que les chatbots, ces logiciels de conversation automatique qu’on trouve de plus en plus dans les services de relation client, comme Watson pour Orange Bank. Ou encore des assistants personnels présents dans nos smartphones ou couplés à des enceintes connectées, comme Siri d’Apple, Cortana de Microsoft, Alexa d’Amazon et Djingo d’Orange. « Un jour, nous pourrons dialoguer avec ces assistants de manière naturelle, mais ce n’est pas encore le cas », constate Luc Julia, « père » de Siri d’Apple et désormais vice-président innovation de Samsung.

Faibles, certes, « ces IA sont très efficaces pour remplir une tâche spécialisée », précise Nicolas Demassieux. Le patron de la recherche d’Orange ajoute : « L’intelligence humaine, elle, peut faire énormément de choses : raisonner, communiquer, manipuler des concepts, etc. Une IA qui reconnaît un chat dans une image ne maîtrise pas le concept de chat. L’IA faible actuelle est encore très très loin de ce que peut réaliser un humain ».

La manière dont « pense » l’IA est l’un des problèmes que ne savent pas encore résoudre les chercheurs. C’est ce qu’on appelle le phénomène de la boîte noire.

Pour l’instant, les systèmes d’intelligence artificielle fonctionnent en étant abreuvés de masses de données par des opérateurs humains. « Mais il nous manque encore un moyen de faire réfléchir la machine », explique Luc Julia. La manière dont « pense » l’IA est d’ailleurs un des problèmes que ne savent pas encore résoudre les chercheurs. C’est ce qu’on appelle le phénomène de la boîte noire : l’IA répond parfaitement à une tâche une fois entraînée, mais ne sait pas expliquer comment elle est arrivée à ce résultat. « L’expérience de l’IA n’est pas transmissible à l’humain et elle ne sait pas décrire son raisonnement », note Nicolas Demassieux.

La singularité ? Une supercherie.

L’IA actuelle est donc pour l’instant un ensemble de techniques qui s’améliorent peu à peu, mais encore très éloignées de l’androïde conscient et immortel des films de science-fiction. Jean-Gabriel Ganascia, auteur du Mythe de la Singularité 2 , pense que l’arrivée prochaine – Raymond Kurzweil évoque 2030 – d’une IA omnisciente et dangereuse est « une supercherie ».

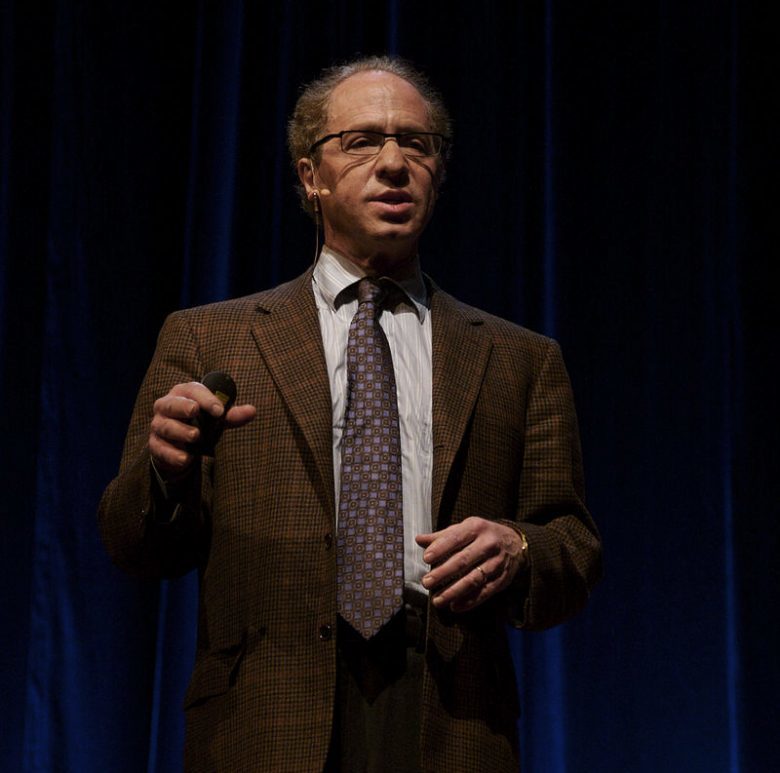

Ray Kurzweil au « Stanford Singularity Summit »

« La singularité se base sur deux arguments, explique-t-il. Un : la loi de Moore, définie en 1964 par le fondateur d’Intel, qui établit que la puissance des processeurs double tous les 18 mois. Or, la technologie du silicium qui compose ces puces a des limites physiques. Deuxième argument : le machine learning permet dans certains cas aux IA de s’auto enseigner . Là encore, cet apprentissage a des limites. Quand on apprend, il faut à un moment introduire des notions totalement nouvelles comme l’ont fait Galilée ou Einstein. On ne sait pas comment une machine peut d’elle même établir ces nouveaux paradigmes. »

Cette technologie perfectible a pourtant commencé à bouleverser nos modes de vie, et va continuer à le faire dans le futur, avec l’arrivée programmée des , des robots chirurgiens, des algorithmes avocats ou des majordomes virtuels. A Viva Technology, Stéphane Richard a rappelé que « l’intelligence artificielle offre un potentiel certain de croissance, à la fois pour l’économie comme pour l’humanité. Les innovations dérivées de l’IA vont devenir le centre névralgique des entreprises et de la société en général, et tous les acteurs doivent s’y préparer intellectuellement, politiquement, socialement ».

Computing machinery and intelligence, 1950.

Ed. du Seuil, 144 pages, février 2017.

Computing machinery and intelligence, 1950.

Ed. du Seuil, 144 pages, février 2017.

12 changements de l’IA dans nos vies

Smartphones, automobiles, maison, commerce, relation client, santé et même justice, l’intelligence artificielle est une réalité dans bien des aspects de la vie quotidienne. Avec souvent des bénéfices concrets tangibles. Revue de détail.

Des IA made in France ?

Aujourd’hui, les intelligences artificielles sont américaines. Et demain, peut-on envisager des IA made in France ?

Les moyens colossaux en recherche et développement déployés depuis plusieurs années par les GAFAM5 et IBM assurent pour l’instant une avance considérable aux sociétés américaines, principalement dans la Silicon Valley.

La Chine, de son côté, a décidé d’investir massivement dans l’IA et annonce un budget de 13,5 milliards d’euros pour les trois prochaines années. Les géants chinois de l’Internet et du e-commerce Baidu, Tencent et Alibaba ne comptent pas laisser les GAFAM dominer ce marché prometteur, estimé à près de 60 milliards de dollars d’ici à 2025 par une étude récente du cabinet Tractica. Les enjeux sont importants, qu’il s’agisse de la vitalité des écosystèmes, de potentialités économiques et d’emplois ou de cybersécurité. Coincée entre ces deux puissances économiques et technologiques, la France aimerait trouver sa place pour bénéficier elle aussi des avancées de l’IA, que certains présentent comme « l’électricité du XXI siècle ».

Les atouts de la France

Notre pays a des atouts, avec des chercheurs qui font autorité, comme Yann le Cun, recruté par Facebook, ou Luc Julia, père de l’interface vocale Siri d’Apple et actuellement vice-président innovation de Samsung. D’autre part, les mathématiciens et ingénieurs français sont réputés dans le monde entier.

Autre atout : un écosystème de soixante-huit centres de recherche. Par exemple, une équipe de l’INRIA6 à Nancy travaille sur le projet Orpailleur. À Lille, l’équipe Magnet planche sur le machine learning dans les réseaux d’information. Au CNRS, le pôle Robotique et Intelligence Artificielle (LAAS-CNRS) étudie « les fonctions de perception, de décision, de mouvement, d’action, de communication et d’interaction entre le robot et son environnement ».

« Même si notre industrie sur le sujet de l’IA est encore très loin des énormes entreprises américaines, notre recherche, elle, se porte bien »

Cédric Villani

Le 21 mars 2017, à la Cité des Sciences et de l’Industrie à l’occasion de la présentation du rapport plan France IA lancé par le gouvernement quelques semaines plus tôt, en janvier, le mathématicien Cédric Villani a souligné que « même si notre industrie sur le sujet de l’IA est encore très loin des énormes entreprises américaines, notre recherche, elle, se porte bien ». France IA est une démarche qui à pour but la mobilisation de toute la communauté française de l’intelligence artificielle avec comme objectif principal « l’élaboration d’une stratégie nationale destinée à confirmer la place de la France au premier plan de l’IA ».

© Marie-Lan Nguyen / Wikimedia Commons / CC-BY 3.0

Dix groupes de travail

Dix groupes de travail sur dix thèmes clés (recherche, formation, véhicule autonome, relation client, etc.) ont établi un diagnostic de la situation française et mené une analyse des enjeux, puis émis des recommandations dont la mise en œuvre doit contribuer à « placer la France en leader de l’IA ».

Une stratégie nationale sur l’IA

Lors de Futur en Seine en juin 2017, Frédérique Vidal, la nouvelle ministre de l’Enseignement supérieur, de la recherche et de l’innovation, a déclaré vouloir « mobiliser plus de cinq mille chercheurs, les meilleurs spécialistes de chaque discipline, pour passer des concepts aux POC 7

puis à la mise de produits sur le marché ».

Le 8 septembre dernier, le Premier ministre Edouard Philippe a demandé à Mounir Mahjoubi, secrétaire d’Etat chargé du Numérique, d’engager un travail de prospective sur les enjeux liés aux nouvelles frontières technologiques, afin que la France se dote d’ici la fin de l’année 2017 d’une stratégie ambitieuse en matière d’intelligence artificielle.

Dans ce cadre, le Premier ministre a lancé la mission « stratégie nationale sur l’intelligence artificielle » et remis une lettre de mission à Cédric Villani, nouvellement élu député de l’Essonne, pour poser les fondements de cette réflexion. Sa mission : étudier les actions nécessaires pour permettre à la France et à l’Europe d’être à la pointe de l’économie fondée sur l’intelligence artificielle.

Les pouvoirs publics peuvent s’appuyer sur Bpifrance, la banque publique d’investissement, qui a élaboré un plan stratégique sur l’IA. « Ce n’est pas qu’un sujet de start-up, mais aussi de PME et de grands groupes, qui doivent ouvrir leurs données, qui sont le moteur de l’intelligence artificielle », a expliqué Paul-François Fournier, directeur innovation de Bpifrance.

Mais ce polytechnicien, ancien cadre dirigeant chez Orange, a aussi réaffirmé l’urgence à soutenir financièrement les jeunes pousses de l’IA sous peine de les voir partir à l’étranger : « Google a racheté 70 start-up en 18 mois, la totalité des entreprises du SBF 120 seulement 40 ! »

La capacité des acteurs publics et privés à investir dans la recherche fondamentale, à soutenir l’écosystème des start-up et à développer des solutions opérationnelles made in France déterminera la place de notre pays dans un monde où l’intelligence artificielle va jouer un rôle déterminant dans tous les secteurs de la société.

Google, Apple, Facebook, Amazon, Microsoft

Institut national de recherche en informatique et en automatique

Proofs of concept, ou démonstrations de faisabilité

Google, Apple, Facebook, Amazon, Microsoft

Institut national de recherche en informatique et en automatique

Proofs of concept, ou démonstrations de faisabilité

L’IA chez Orange

Nicolas Demassieux, directeur de la recherche d’Orange, est confiant dans la capacité de l’Hexagone à occuper et tenir un rôle de tout premier plan dans la bataille de l’intelligence artificielle car « la France a un très bon niveau de formation. Et le tissu des start-up est en train d’exploser ». « Chez Orange, ajoute-t-il, nous travaillons sur l’IA depuis longtemps dans nos centres de Rennes et Lannion. Nous avons annoncé l’assistant personnel Djingo, nous travaillons avec Watson d’IBM pour Orange Bank, mais aussi en interne sur une IA d’optimisation de notre réseau. »

Vers une nouvelle collaboration Homme-machine ?

Transports, banques, médias, santé : l’arrivée des intelligences immatérielles (algorithmes) et matérielles (robots) n’annonce-t-elle pas moins des licenciements massifs ou la fin du travail qu’une nouvelle forme d’hybridation entre l’homme et la machine ?

L’intelligence artificielle pourrait détruire des millions d’emplois, remplaçant les chauffeurs par des véhicules automatiques ou les avocats par des algorithmes. C’est ce qu’avancent régulièrement des études plus ou moins alarmistes. En 2014, le cabinet Roland Berger a ainsi publié une étude selon laquelle la robotisation menacerait 42 % des emplois et pourrait en détruire 3 millions en France d’ici à 2025.

Selon diverses prévisions, quasiment toutes les catégories socioprofessionnelles, tous les métiers seraient menacés : ouvriers, chauffeurs, employés de banque, caissières, chirurgiens, journalistes, avocats, comptables, etc. En mai 2017, les universités d’Oxford et Yale ont publié un calendrier des années où l’IA va surpasser l’humain, et sera donc susceptible de le remplacer : 2024 pour les traducteurs, 2027 pour les chauffeurs de camions, 2031 dans le commerce de détail, 2049 pour les écrivains, 2053 pour les chirurgiens. Et en 2062, les IA seront en mesure de réaliser toutes les tâches humaines plus efficacement que nous. Diable !

« L’IA n’est qu’une forme particulière d’automatisation de certaines tâches plutôt qu’un remplacement des emplois. »

Nicolas Demassieux

« Une vieille histoire »

Certains spécialistes sont nettement moins pessimistes. Nicolas Demassieux est de ceux-là. « L’automatisation, c’est une vieille histoire, rappelle le directeur de la recherche d’Orange. Ça a commencé avec les machines à tisser qui ont remplacé les tisserands, d’où la révolte des Canuts à Lyon. Ça a continué avec les ordinateurs qui ont mis au chômage les employés aux écritures dans les banques. L’IA n’est qu’une forme particulière d’automatisation de certaines tâches plutôt qu’un remplacement des emplois. Le vrai problème, c’est la rapidité de changement de ces tâches, liée à la numérisation. »

Jean-Gabriel Ganascia, enseignant et chercheur, est lui aussi sceptique sur ce remplacement de l’homme par la machine et relativise la pertinence des études. Il s’appuie sur la catégorisation de la philosophe Hannah Arendt qui distingue le travail (labor), l’activité qui permet à l’homme de subsister, de l’œuvre (work), la réalisation matérielle de l’artisan ou de l’artiste et l’action, au sens d’action politique11 .

« Le travail laborieux et des activités intellectuelles elles aussi répétitives seront certainement remplacés, a-t-il expliqué lors du festival Futur en Seine en juin 2017. Mais dans le domaine de l’œuvre, il faut des talents que ne possèdent pas les robots. Et de nouveaux métiers vont apparaître grâce à des formations hybrides, qui intègrent le numérique, et qui doivent se dérouler tout au long de la vie. » Ce professeur d’informatique se dit optimiste… « à condition d’affronter les transformations majeures que va provoquer l’intelligence artificielle ».

Les moins qualifiés sont les plus menacés

Chercheur en ergonomie dans le département SENSE des Orange Labs, Mustafa Zouinar travaille sur l’interaction homme-machine. Il rappelle que certaines études, comme celle de McKinsey, montrent que 5 % seulement des activités humaines peuvent être automatisées à 100 % : « ce sont les professions à bas niveau de qualification dans un environnement stable qui risquent d’être le plus touchées, comme une chaîne de montage en usine ».

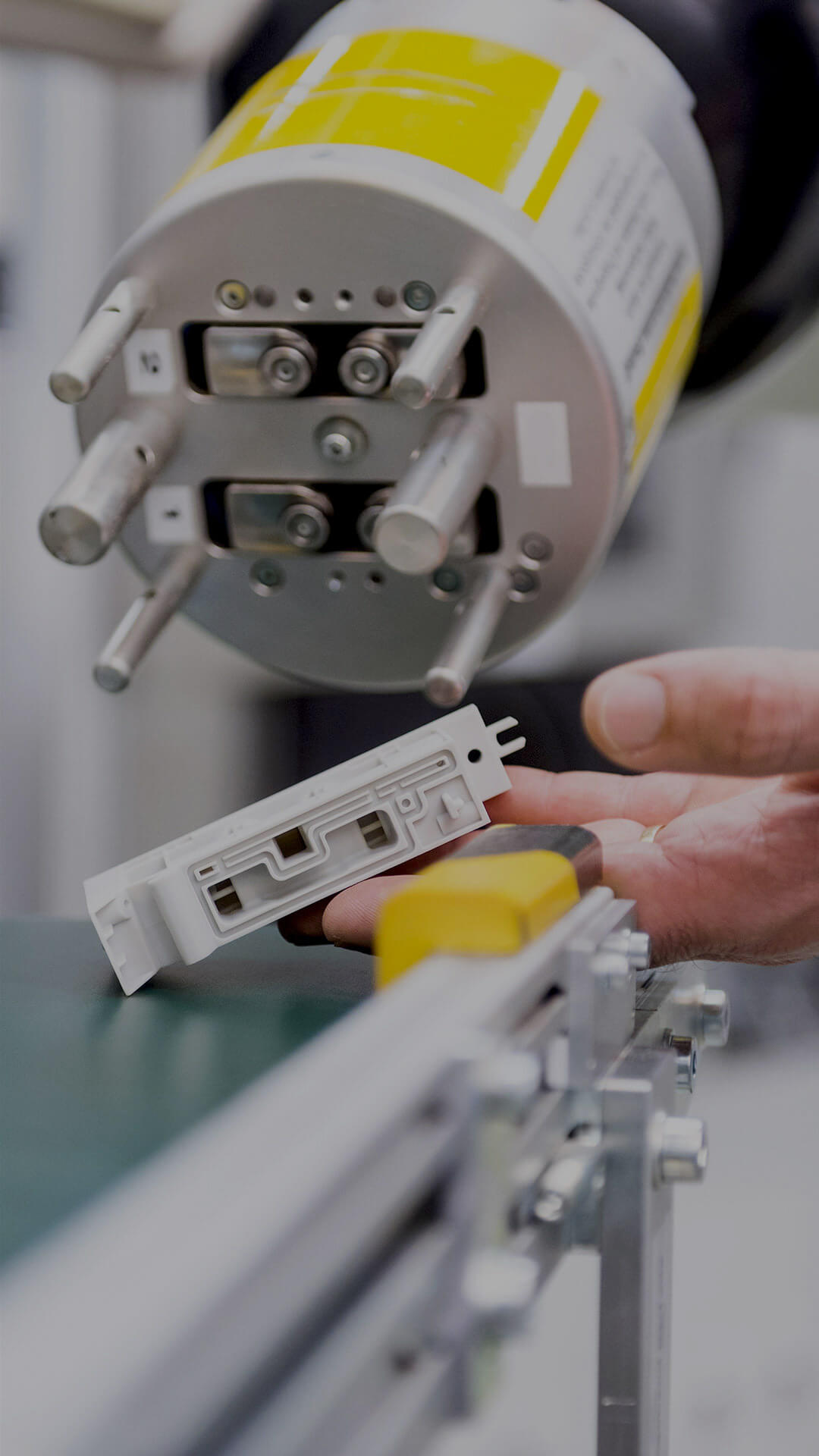

Selon lui, on se dirige plutôt vers une forme d’hybridation, où l’opérateur humain et la machine collaborent pour effectuer une tâche. « Pour la voiture autonome, par exemple, le conducteur pourra reprendre le contrôle à des moments particuliers, illustre-t-il. Comme c’est le cas, déjà, dans les avions avec le pilotage automatique. » Une collaboration qui va durer sans doute encore longtemps d’après les experts de la robotique car les machines n’ont pas les capacités adaptatives de l’être humain. Le terme , ou robot collaboratif, incarne cette tendance.

Le rapport entre innovation technologique et niveau du chômage est un thème très controversé depuis les années 1980.

Le rapport entre innovation technologique et niveau du chômage est un thème très controversé depuis les années 1980. « Un économiste comme Alfred Sauvy a montré que le sujet est beaucoup plus complexe qu’on ne le croit, poursuit Mustafa Zouinar. Dans l’industrie automobile, par exemple, la robotisation a certes détruit des emplois mais elle a également fait baisser le prix des voitures, ce qui redonne du pouvoir d’achat aux consommateurs qui achètent plus de biens de consommation et donc créent des emplois dans d’autres secteurs économiques. C’est la logique de la de Schumpeter. »

Un exemple de cobot

« Uncanny valley »

Un autre aspect à prendre en compte dans cette révolution mondiale est que toutes les sociétés n’appréhendent pas l’arrivée de robots munis d’IA de la même façon. Si les Français et les Européens souffrent du syndrome de l’ (plus un robot est proche d’un être humain, plus il nous apparaît monstrueux) les Japonais, eux, sont beaucoup moins réticents.

« Je reviens du Japon, dont le taux de natalité est très bas et qui va manquer de main d’œuvre, témoigne Jean-Gabriel Ganascia dans La Tribune à l’occasion de Futur en Seine. Leur vision est très différente de la nôtre. Ils se disent : avec les robots, nous allons continuer d’avoir une industrie compétitive. Les Français et les Européens, eux, ont une vision négative, et pensent par exemple à instaurer une taxe sur les robots. »

« Dans les années 1970 et 1980, le Japon, dont les ressources naturelles sont limitées, a énormément investi dans l’industrie informatique et la technologie, qui apparaissent comme une réponse à ses problèmes, dont le vieillissement de la population », confirme Mustafa Zouinar.

L’IA tueuse d’emplois n’est pas une fatalité mais il faut que la société accompagne cette quatrième révolution industrielle.

Ainsi donc, l’IA tueuse d’emplois n’est pas une fatalité mais il faut que la société accompagne cette quatrième révolution industrielle d’un effort considérable en formation et d’un coaching des individus vers les nouveaux métiers qui ne manqueront pas d’apparaître dans le sillage de ces algorithmes.

« Nous sommes engagés dans une transformation profonde des activités humaines, dont celle du travail, résume Mustafa Zouinar. Mais les progrès de l’IA ne sont pas aussi rapides que prévus. Dans les années 1950, Herbert Simon, économiste considéré comme un des pères de l’intelligence artificielle, disait que dans trente ans, on n’aurait plus besoin de traducteurs humains. Soixante ans plus tard, nous n’y sommes toujours pas, même si les progrès sont réels. On est donc encore très loin d’une destruction massive des emplois. »

The Human Condition, University of Chicago Press, 1958.

The Human Condition, University of Chicago Press, 1958.

Quelques visages de l'IA

Ils sont chercheurs, ingénieurs ou « start-upeurs » et font avancer la recherche en intelligence artificielle. Sélection.

Yann Le Cun

Ce diplômé de l'École supérieure d'ingénieurs en électrotechnique et électronique (ESIEE) travaille depuis les années 1980 sur l’apprentissage automatique (machine learning) et l’apprentissage profond (deep learning). Il rejoint en 1988 les laboratoires AT & T pour lesquels il développe des méthodes d'apprentissage supervisé. En 2013, il est invité par Mark Zuckerberg à rejoindre Facebook pour créer et diriger le laboratoire d'intelligence artificielle FAIR (Facebook Artificial Intelligence Research) à New-York et depuis 2015 à Paris.

En savoir plus

Nathalie Aussenac-Gilles

Directrice de recherche CNRS à l'Institut de recherches en informatique de Toulouse (Irit), elle est notamment responsable de l’équipe « MELODI », pour MEthodes et ingénierie des Langues, des Ontologies et du DIscours. Son domaine de recherche est l’ingénierie des connaissances, avec en domaines connexes : l’intelligence artificielle (représentation des connaissances), le traitement automatique des langues, la gestion documentaire, la terminologie, le Web sémantique. Elle travaille en particulier sur la construction de modèle sémantique à partir de corpus de textes.

En savoir plus

Jérôme Pesenti

Diplômé en philosophie et docteur en mathématiques, il travaille sur l’IA depuis 18 ans. En 2000, il créé Vivismo qui développe une technologie d’analyse de texte ou text mining. IBM rachète Vivismo et le nomme responsable de la R&D et de l’équipe de 300 chercheurs qui met au point le programme Watson. En 2016, il devient PDG de BenevolentTech, qui analyse les publications scientifiques grâce au deep learning.

Suivez le sur Twitter

Peter Norvig

Docteur en science informatique, il est aussi directeur de la recherche et de la qualité de Google. Il est membre de l’Association for the Advancement of Artificial Intelligence et co-auteur avec Stuart Russell de « Artificial Intelligence: A Modern Approach ». Ce spécialiste de l’IA et du traitement automatique du langage naturel a été directeur de la division systèmes intelligents du NASA Ames Research Center.

En savoir plus

Alexandre Lebrun

Ce polytechnicien et ingénieur de TelecomParisTech fonde en 2002 VirtuOz (racheté par Nuance Communications), un leader dans les agents virtuels intelligents. Après avoir dirigé pendant 13 ans l’agence digitale coréenne Asiance, il crée en 2013 Wit.ai, plateforme d’applications en langage naturel, rachetée par Facebook en 2015, dont il intègre le laboratoire FAIR.

Suivez le sur Twitter

Cordelia Schmid

Directrice de recherche à l’Inria (Institut de recherche en informatique et en automatique), elle est une spécialiste reconnue en vision artificielle. Après avoir créé et dirigé l’équipe « LEAR », elle a pris la tête de l’équipe-projet « THOTH », toujours dans les locaux du centre de recherche INRIA Grenoble Rhône-Alpes, en janvier 2016. Ses recherches sont consacrées à la vision artificielle et plus particulièrement à l’interprétation automatique d’images et de vidéos numériques. Elle a reçu le Grand Prix Inria-Académie des sciences en 2016 pour son parcours dans le domaine de la vision par ordinateur depuis plus de vingt ans.

Joëlle Pineau

Cette Canadienne de 43 ans dirige depuis 2017 le laboratoire de recherche en IA de Facebook à Montréal. Professeure à l’université McGill où elle est aussi co-directrice du Laboratoire d’apprentissage et de raisonnement, elle est membre du comité de rédaction du « Journal of Artificial Intelligence Research » et du The Journal of Machine Learning Research. Un chapitre de sa thèse, « Point-based value iteration : An anytime algorithm for POMDPs », reste, quinze ans après sa publication l’un des articles les plus cités dans le domaine de l’IA.

En savoir plus

Geoffrey Everest Hinton

Cet Britannique naturalisé Canadien est diplômé en science informatique et cognitive. Chercheur reconnu dans la communauté du deep learning, Il a travaillé sur les réseaux de neurones artificiels. Il a été un des premiers à démontrer l’utilité de la rétrogradation de gradient (« backpropagation ») pour les réseaux de neurones multicouches.

En savoir plus

Andrew Ng

Ce docteur en informatique sino-américain est le directeur de recherche de Baidu sur le big data et l’IA. Diplômé de Carnegie Mellon University et du MIT, il travaille sur le deep learning et le machine learning. Il a dirigé le projet Google Brain, utilisé dans le système de reconnaissance vocale d’Android, la recherche de photos de Google+ et les recommandations vidéos de YouTube, avant de fonder le MOOC gratuit Coursera.

En savoir plus

Sebastian Thrun

Cet Allemand docteur en science informatique a fondé Google X et a travaillé sur le véhicule autonome Stanley. Il a participé à l’élaboration de Google Street View. Ses véhicules autonomes ont gagné deux fois le DARPA Grand Challenge en 2005 et 2007. Fast Company l’a nommé l’un « des cinq hommes les plus créatifs du monde ».

En savoir plus

Rand Hindi

Codeur depuis l’âge de dix ans, ce diplômé en bio-informatique de l’University College of London a été distingué comme « innovateur de moins de 35 ans » par la MIT Technology Review et « Under 30 Europe » par Forbes. Il a fondé en 2013 Snips, une plateforme d’assistant vocaux basée sur l’IA. Sa première réalisation, l'application Tranquilien pour la SNCF, permet de prévoir les rames dans lesquelles il y a le plus de chances de trouver des places assises.

Suivez le sur Twitter

Luc Julia

Diplômé de l’École nationale supérieure des télécommunications, il commence à travailler sur l’intelligence artificielle en 1994 à l’International/Artificial Intelligence Center de Menlo Park (Californie). Après avoir créé l’incubateur BravoBrava! LLC en 2000, il devient chief technologist de Hewlett-Packard puis directeur et co-auteur de l’assistant vocal Siri chez Apple. En 2012, il devient vice-président innovation de Samsung Electronics.

En savoir plusIA inanimée avez-vous donc une âme ?

Qui sera responsable quand la voiture autonome aura un accident ? Les robots auront-ils une personnalité juridique ? Les systèmes prédictifs sont-ils dangereux pour les libertés individuelles ? L’intelligence artificielle soulève des questions liées à l’éthique et la responsabilité.

La voiture autonome est prévue à l’horizon 2025. Mais avant même de pouvoir effectivement rouler sans aide humaine grâce à l’intelligence artificielle, elle ne manque pas de soulever de lourdes questions de responsabilité. Si personne ne tient le volant lors d’un accident, qui sera tenu pour responsable ? Le constructeur ? Le prestataire informatique qui aura fourni le logiciel ? Les deux ? Par ailleurs, si l’IA choisit de renverser un piéton qui traverse pour éviter un accident mortel aux occupants de la voiture, qui sera comptable de cette décision ?

« À vrai dire, ce n’est pas la voiture autonome qui choisira, mais des agents humains qui auront déterminé certains algorithmes et critères d’après lesquels elle déterminera son comportement en faveur d’une orientation ou d’une autre. Mais qui dispose de la légitimité pour déterminer ces critères ? Quels seraient-ils et comment les justifier ? », s’interrogent ainsi trois chercheurs du laboratoire ETHICS de l’Université Catholique de Lille (« Quelle éthique pour la voiture autonome », La Tribune).

Voilà quelques-uns des questionnements éthiques que l’IA soulève d’ores et déjà, et ne manquera pas de soulever au fur et mesure que ces algorithmes se perfectionneront et s’insèreront dans tous les aspects de nos vies quotidiennes. « Dans le cas de la voiture autonome, il n’y a pas de réponse unique. Plusieurs acteurs interviennent : l’utilisateur, le propriétaire du véhicule, le constructeur automobile, la personne qui a entraîné le programme, puisque l’IA apprend par l’expérience. Je pense qu’il faudra diligenter une enquête pour chaque cas particulier », estime Jean-Gabriel Ganascia, enseignant, auteur d’ouvrages sur l’IA et président du comité d’éthique du CNRS.

« Commençons par régler nos questionnements éthiques avant de les transférer dans les hypothétiques systèmes d’IA fortes »

Nicolas Demassieux

L’IA aurait-elle bon dos ?

Ces questionnements ne sont pas spécifiques à l’IA mais plus largement au numérique, souligne Nicolas Demassieux, directeur de la recherche chez Orange. « Aujourd’hui, il existe déjà ce genre de dilemmes sans que l’IA soit impliquée : si vous avez un bug dans un logiciel d’ABS et que celui-ci ne déclenche pas le freinage, qui est responsable, le fabricant ou l’éditeur du logiciel ? Le numérique engendre cette question de la responsabilité partout où il est employé. S’il y a relâchement de vapeurs toxiques par erreur dans une usine automatisée, ce n’est pas une question d’IA, mais d’automatisme mal programmé. Et pourtant, il y aura là aussi une recherche de responsabilité. »

« Concernant la voiture autonome, ajoute-t-il, sa performance sera meilleure que celles des humains en matière de conduite automobile : on sait que ces véhicules intelligents tueront moins que les conducteurs. Quand les IA seront assez développées et tendront vers des formes de décision qui leur seront propres, cela posera un problème éthique encore plus complexe. Il faudra que cette question soit d’abord résolue par les humains. Commençons par régler nos questionnements éthiques avant de les transférer dans les hypothétiques systèmes d’IA fortes. Et après tout, peut-être ces IA sophistiquées nous proposeront-elles des alternatives morales que nous n’avions pas imaginées ».

« On veut faire payer le robot. Or, c’est une fiction juridique : le robot n’a pas d’argent »

Jean-Gabriel Ganascia

Fiction juridique

Ces questions d’éthique et de responsabilité des machines intelligentes, les institutions commencent à s’en emparer. Le Parlement européen envisage ainsi de voter une résolution concernant la personnalité juridique des robots, suite au rapport de la députée luxembourgeoise Mady Delvaux. Pour Jean-Gabriel Ganascia, « c’est une mauvaise chose ». « On veut faire payer le robot. Or, c’est une fiction juridique : le robot n’a pas d’argent, pointe le chercheur. Il faudra donc créer un fonds d’assurances associé au robot. Qui va l’abonder ? En grande partie les fabricants de ces machines, ce qui va freiner l’innovation. Deuxième argument : cette résolution ne vaut que pour la responsabilité civile, et pas la responsabilité pénale. Payer en cas d’accident ferait l’économie d’une enquête. Or, si on veut mieux comprendre ces technologies, il faut absolument enquêter sur les causes de l’accident causé par le robot. »

Autre danger potentiel : les basés sur des IA, qui peuvent permettre de prendre des décisions à la place des hommes, ce qui conduit à une déresponsabilisation. Les assurances pourraient par exemple utiliser ces systèmes pour calculer le coût des primes. Associé aux progrès actuels de la , de tels algorithmes engendreraient des problèmes éthiques considérables. Le terrorisme de plus en plus présent dans nos sociétés pourrait aussi conduire les gouvernements à pousser la recherche vers des dispositifs à la Minority Report, pour tenter de détecter les crimes avant même qu’ils ne se produisent, ou arrêter quelqu’un qui serait en train de se radicaliser bien avant son hypothétique passage à l’acte. Le risque n’est donc pas tant que la machine nous remplace mais que notre résistance à endosser nos responsabilités nous pousse à laisser les IA prendre les décisions à notre place.

Sources iconographiques

1943 computer,The National Archives (United Kingdom). Theseus Maze by Claude Shannon, 1952 – MIT Museum.

Ray Kurzweil at Stanford Singularity Summit by Roland Dobbins. Prototype Watson IBM, by Clockready.

Cédric Villani, by Marie-Lan Nguyen.