"L’informatique affective est une discipline qui cherche à améliorer nos interactions avec des outils numériques. Elle s’appuie notamment sur la reconnaissance des émotions des utilisateurs."

Introduction

Inspiré du roman “The Positronic Man” d’Isaac Asimov, le film “l’homme bicentenaire” raconte l’histoire du robot Andrew, incarné par Robin Williams et doué d’un esprit hors du commun. Ce robot évolue au fil de nombreuses transformations et développe de plus en plus de capacités humaines. Dans cette œuvre, le premier souhait de transformation du robot, est d’acquérir un visage plus expressif pour réussir à transmettre aux humains les émotions qu’il ressent. Cette fiction illustre bien le rôle essentiel des émotions pour communiquer, que l’on soit un être biologique ou mécanique. Dans la réalité, même si nous sommes loin de pouvoir transformer nos ordinateurs et nos smartphones, comme Andrew, en machines douées d’émotions, nous pouvons nous interroger sur l’usage et l’intérêt qu’auraient ces dernières pour nos propres interactions.

En tant qu’opérateur Télécom, Orange cherche à proposer une expérience de communication digitale qui soit optimale. Cependant, si la communication numérique possède de nombreux avantages, elle présente l’inconvénient de nous couper d’une partie de nos capacités d’interactions, capacités qui sont nécessaires pour interagir, notamment par le moyen de nos émotions. Or, celles-ci sont essentielles pour assurer une bonne adaptation à l’autre, pour ajuster son discours ou message, que ce soit dans le cadre de communications personnelles, professionnelles ou pour un service client.

D’ailleurs, ces dernières années, les recherches sur le lien entre émotions et les nouvelles technologies ont connu un énorme essor, au point de devenir une discipline à part entière : l’informatique affective (ou affective computing en anglais). De par sa position dans les communications numériques, Orange a les moyens d’apporter sa contribution dans ce domaine où beaucoup d’incertitudes demeurent. D’autant plus qu’il existe aujourd’hui de nouvelles méthodes prometteuses pour reconnaître nos émotions au moyen de l’intelligence artificielle. Quelles sont ces méthodes ? Quels sont les défis à relever ? Qu’en est-il des limites ?

I – Cap sur la science des émotions.

Qu’est qu’une émotion ?

L’origine du mot émotion provient du terme latin “emovere”, le e signifiant “hors de” et “movere” “mouvement”. Cette étymologie nous éclaire sur le lien fort entre les émotions et le corps et sur leur nature à s’extérioriser [1], ainsi notre peau rougit lorsque nous avons honte et nos mains tremblent lorsque nous avons peur… Les émotions font partie de notre quotidien, nous en avons tous fait l’expérience. En revanche, elles sont difficiles à définir.

A ce jour, il n’existe pas d’unanimité sur une définition de l’émotion. Comme le goût et les couleurs ne se discutent pas, les émotions sont des expériences singulières, par nature, complexes à généraliser. Pourtant, l’émotion est essentielle pour comprendre le fonctionnement de l’Humain. A ce sujet, la recherche a été particulièrement prolifique au cours des deux derniers siècles et les chercheurs ont proposé un grand nombre de définitions et de théories pour tenter d’expliquer les émotions. Le concept rassemble de nombreuses disciplines comme la psychologie cognitive, la psychologie sociale, l’éthologie (étude du comportement animal) et plus récemment les neurosciences. Chacune de ces disciplines a apporté ses théories, ses modèles et ses découvertes empiriques sur le sujet.

Dans cette complexité, le choix d’un modèle théorique est déterminant pour structurer l’ensemble des travaux et des connaissances. Ainsi, l’approche multi composante est l’une des plus utilisées par les chercheurs. Il en résulte le principe suivant : l’émotion est un concept abstrait dont on ne devine l’existence qu’à partir d’un certain nombre d’indices, qui eux sont bien perceptibles et concrets [2]. Quels sont ces indices ?

Il en existe cinq catégories, ou composantes d’émotions, que nous proposons de présenter en prenant l’exemple suivant : “Un promeneur se balade tranquillement en forêt et croise le chemin d’un ours”.

- La réponse psychophysiologique : il s’agit des manifestations de notre organisme comme la fréquence cardiaque, la transpiration et la sécrétion de d’hormones comme l’adrénaline, la sérotonine ou la dopamine… En croisant un ours, le promeneur va réagir, on pourra alors observer que le corps du promeneur tremble ou transpire bien plus que d’habitude.

- L’expression motrice : ce composant comprend les réactions comportementales comme les expressions du visage, la modification de la voix ou des gestes… On peut facilement imaginer que les muscles du visage du promeneur vont se crisper pour exprimer de la peur.

- La préparation à l’action : il s’agit de la mobilisation des ressources pour réaliser une action appropriée à la situation. Dans le cas du promeneur, la situation provoquera une envie de s’enfuir ou de se cacher et les muscles de son corps se prépareront à effectuer cette action.

- Le sentiment subjectif : cela correspond à la prise en compte conscience des modifications de son organisme et de l’expérience que l’on est en train de vivre. Si l’on demandait au promeneur comment il se sent, il exprimerait probablement qu’il vit une situation négative et qu’il se sent mal.

- L’évaluation cognitive : il s’agit de la prise de connaissance du contexte actuel et de sa signification. Dans notre exemple de balade en forêt, le promeneur sait qu’un ours est un animal sauvage donc possiblement dangereux.

Les modifications de ces cinq éléments forment donc ce que l’on appelle une émotion…

A quoi servent les émotions ?

Selon Darwin, à l’origine de la théorie de l’évolution, les émotions ont une utilité adaptative : elles permettent de réagir en conséquence à la situation. Ainsi, l’objectif d’une émotion est de nous préparer à réaliser l’action la plus appropriée pour atteindre nos buts ou éviter les problèmes. Dans notre exemple précédent, toutes les manifestations de peur du promeneur lui servent à initier au mieux l’action de fuir ou de se cacher. L’augmentation de son taux d’adrénaline, de son pouls, la contraction de ses muscles sont autant d’éléments qui vont contribuer à la réussite de l’action du promeneur. Bien sûr, ces composantes se manifesteront différemment en fonction de l’expérience de chacun et du contexte. Ainsi, là où un promeneur désarmé voit un ours comme un danger, un chasseur y verra une opportunité. L’évaluation cognitive, le dernier composant de notre liste, est donc un élément essentiel pour définir l’émotion, ce qui montre le lien fort entre émotion et cognition.

L’étude des expressions faciales est particulièrement éclairante sur la théorie de l’évolution. En effet, les expressions des visages jouent un rôle essentiel pour un individu dans sa communication, sur son état interne courant et sur un danger potentiel. Il est certain par exemple que si l’on croise une personne avec un visage horrifié, nos sens vont s’activer et on va soi-même être attentif à la cause de cet effroi. Ainsi, pour des humains et par extension pour tous les animaux sociaux, les émotions ont notamment pour fonction d’augmenter les chances de survie.

Comment discerner les émotions entre elles ?

Les scientifiques n’ont pas manqué d’imagination pour proposer des catégories d’émotions. Chacune des composantes citées précédemment constitue un élément qui nous permet de distinguer des émotions. Ainsi, les expressions faciales offrent une piste intéressante. Selon le chercheur Ekman [3], qui a contribué à la science des émotions à partir des études sur les visages, il est possible de discerner sept émotions à partir des expressions faciales : la joie, la peur, la colère, la surprise, le dégoût, la tristesse et la neutralité. Ces émotions seraient présentes dans toutes les cultures. Elles seraient donc innées pour les humains.

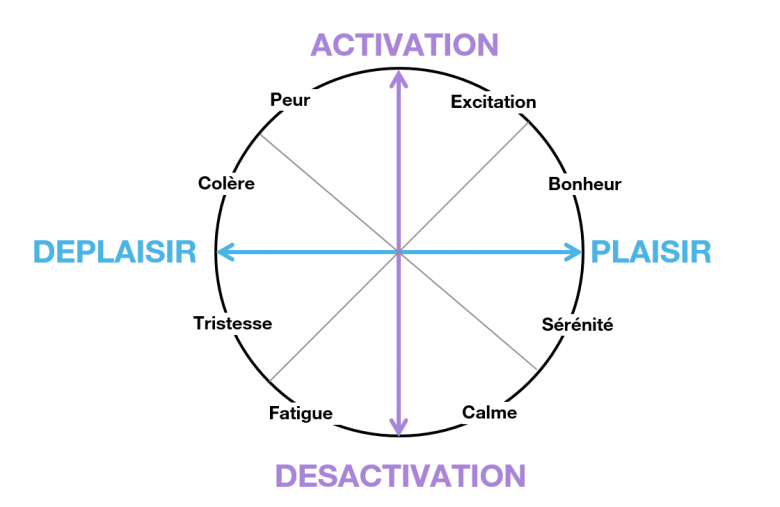

Cependant, les expressions faciales ne sont qu’une résultante partielle des émotions. Ainsi, certains chercheurs préfèrent distinguer les émotions par le prisme du sentiment subjectif qu’elles procurent. De nombreux scientifiques caractérisent notamment les émotions sur un espace à plusieurs dimensions. Russel [4] par exemple propose un schéma bidimensionnel pour représenter un large panel d’émotions :

La valence qui correspond à la tonalité positive ou négative de l’émotion vécue. Par exemple, la joie est une émotion avec une valence positive et la tristesse une émotion avec une valence négative.

L’activation qui correspond à l’énergie que procure l’émotion dans notre organisme. La relaxation est une émotion qui mobilise une faible énergie. Elle a donc une activation faible. A l’inverse l’euphorie indique un fort éveil. Pourtant, les deux émotions ont une valence positive.

Figure 1- le Circumplex de Russel

Entre les visages d’Ekman et les dimensions de Russel, il existe une large variété de modèles plus ou moins complexes pour représenter les émotions. Comme il n’existe pas de modèles parfaits, ceux-ci doivent être choisis et adaptés en fonction du contexte.

II – L’informatique affective, à la croisée des chemins entre humains et machines.

Comment rendre les machines émotionnelles ?

La notion d’émotion clarifiée, la question de son lien avec les nouvelles technologies se pose. La science-fiction s’est souvent prêtée à rêver sur le futur des machines et des compétences humaines qu’elles pourraient acquérir. A l’image de l’homme bicentenaire, on s’imagine des robots doués d’affects, en mesure d’éprouver de l’empathie pour les humains ou d’exprimer leur propres sentiments. Sauf qu’actuellement, on a peine à imaginer comment les émotions pourraient s’intégrer dans notre environnement et plus encore comment les utilisateurs pourraient en bénéficier. Comment une machine basée sur des principes éloignés de la biologie du vivant et qui ne ressemble en rien à un être humain pourrait ressentir et exprimer des émotions ?

Selon Roselin Picard [5], fondatrice du groupe de recherche en informatique affective du MIT, les émotions ont toute leur place au sein des interactions entre des machines et des utilisateurs. Elles seraient même un des chaînons manquants pour que l’informatique devienne vraiment intelligente et s’adapte aux humains. En effet, les émotions et leur compréhension nous servent à nous adapter. Dès lors, pourquoi n’en serait-il pas de même pour les machines ?

L’informatique affective est une discipline qui vise à intégrer les émotions dans nos usages des nouvelles technologies. Il s’agit d’étudier et de développer des moyens pour reconnaître, interpréter et modéliser des émotions humaines lors de l’usage et des interactions avec les technologies. L’approche est fortement multidisciplinaire, impliquant à la fois la psychologie, les sciences cognitives, la physiologie et les sciences informatiques.

Cette multidisciplinarité reflète la multi dimensionnalité des processus émotionnels. En effet, les moyens pour détecter des émotions sont multiples et se sont développés ces dernières années avec l’essor de données disponibles sur les utilisateurs. De plus, les avancées actuelles en Intelligence Artificielle permettent d’automatiser le traitement de grandes quantités de données ce qui facilite les avancées dans ce domaine. Dans sa revue des différentes méthodes de détection d’émotions, Poria [6] estime que 90% des recherches sur la détection d’émotion s’intéressent à ces trois grands axes :

- Le visuel, avec la reconnaissance des émotions par les expressions faciales, les gestes.

- L’audio, avec l’analyse des intonations de la voix.

- Le texte, avec l’étude des mots employés dans un texte pour en extraire les émotions exprimées.

Aucune de ces approches n’est parfaite, l’idéal étant de combiner ces différentes sources de données pour augmenter les chances de reconnaître la bonne émotion. Cependant, détecter avec certitude l’émotion d’une personne reste un obstacle. Les techniques actuelles n’offrent qu’une vue partielle à partir des éléments de nature différente qu’il est possible de recueillir. Tout comme il est compliqué de savoir avec exactitude ce que ressentent nos proches, les machines ne peuvent inférer un état émotionnel qu’à partir de signes extérieurs. La modestie est donc de mise par rapport aux possibilités de décodage automatique des émotions. Les perspectives de recherches sont vastes et comportent encore de nombreux verrous méthodologiques et techniques à surmonter. Il n’est évidemment pas possible de lire dans les pensées des utilisateurs pour en extraire leurs émotions et d’ailleurs cela est-il souhaitable ?

Quels enjeux pour Orange ?

Dans l’écosystème d’Orange, qui est un monde de communications médiées par des technologies numériques, la question de l’intégration de l’informatique affective s’impose d’elle-même. Et la période de crise liée au Covid 19 n’a fait que renforcer cette réalité. De fait, communiquer par téléphone, par chat ou par mail nous coupe d’une part importante de nos moyens de communication et d’expression de nos émotions. A l’heure où le télétravail se démocratise et où les contacts personnels et professionnels se réalisent de plus en plus à distance, se faire comprendre est devenu un enjeu majeur et requiert des efforts supplémentaires. Lors d’une communication à distance, maintenir un bon niveau de compréhension suppose de surmonter les pertes d’information directe, disponibles lors d’une communication en présence. Cette adaptation induit une charge mentale supplémentaire et de la fatigue, qui peut aller jusqu’à de la frustration entre les interlocuteurs. Les émotions jouent un rôle central pour s’adapter à l’autre et elles s’expriment en grande partie par des informations qui ne sont pas verbales. Il y a donc nécessité à réintégrer cette dimension de sensibilité et d’empathie à nos moyens de communications afin qu’ils puissent réduire la distance numérique entre les humains (ce que permettent partiellement les “émojis”).

Le domaine du service client est particulièrement intéressant pour ces recherches. En effet, la communication y est de plus en plus médiée par les outils numériques asynchrones de chat ou de mail. Les attentes des clients sont très fortes et ils aspirent à une expérience la plus satisfaisante possible, à se sentir rassurés et entendus par les conseillers. Ainsi pour aider les conseillers à répondre au mieux aux attentes des clients, l’introduction des émotions dans les outils semble être une piste intéressante. Et dans un contexte de SAV automatisé, la question se pose aussi pour les chatbots, afin de mieux les adapter aux interactions avec les clients. Enfin, le traitement automatique des volumes importants d’expressions clients gagnerait à inclure la qualification de leurs émotions pour mieux comprendre leurs intentions.

Dans ce cadre, on peut noter la collaboration du groupe Orange dans le domaine de la détection des émotions de la voix avec la startup Empath [7], qui propose de distinguer quatre émotions : la joie, le calme, la colère et la douleur à partir des propriétés de la voix.

III – Vers de nouveaux horizons avec les interactions homme machine.

Le smartphone, la nouvelle terre promise.

Bien que la plupart des approches explorées par la science se concentrent sur le visuel, l’audio ou le texte, développer d’autres moyens de recueil des données émotionnelles constitue une perspective prometteuse. En effet, la captation des images, ou de la voix, lors des interactions clients / conseillers pose des problèmes d’éthiques et d’acceptabilité. De plus, si l’on se base uniquement sur un texte, les risques d’erreurs sont très élevés, avec la difficulté de distinguer efficacement une expression directe d’une expression figurée (ironie, humour…) sans avoir de contexte.

Au sein d’Orange Labs, nous réalisons des études pour recueillir des émotions à partir du comportement utilisateur, en utilisant des données issues de smartphones, qui offrent des perspectives de recueil intéressantes. En effet, non seulement leur usage est très répandu mais ils sont aussi munis d’un large éventail de capteurs permettant d’enregistrer les réactions des utilisateurs. Lors d’une interaction sur une application de chat, il est possible d’enregistrer la vitesse de frappe au clavier, ainsi que les capteurs inertiels du smartphone. Ces derniers capturent les mouvements que l’utilisateur effectue sur l’appareil. Ils sont d’ailleurs utilisés dans les applications de fitness pour déterminer quelle activité physique l’utilisateur pratique : marche, course, vélo… L’expression motrice étant l’un des cinq éléments constitutifs des émotions, nous posons donc l’hypothèse qu’il sera possible de la détecter à travers les mouvements issus des interactions avec un smartphone.

L’étude des émotions en laboratoire.

L’approche étant nouvelle, il est d’abord nécessaire de créer un jeu de données d’interaction avec un smartphone (accéléromètre, gyroscope, frappe au clavier) associées à des émotions. Cette étape indispensable doit être réalisée en laboratoire avec un protocole expérimental utilisant l’induction d’émotions. Créer des émotions en laboratoire est une tâche particulièrement complexe. Elle nécessite l’utilisation de vidéos, images ou jeux calibrés pour provoquer des réactions mesurables positives, neutres ou négatives chez les participants.

Les expériences mises en place ont pour objectif de combiner trois des cinq éléments cités au début de cet article : l’expression motrice, le sentiment subjectif et les données psychophysiologiques. L’expression motrice est la variable que nous cherchons à mesurer à partir de l’interaction des utilisateurs sur smartphone. De plus, le sentiment subjectif et les données psychophysiologiques permettent de vérifier ou d’ajuster les émotions qui sont suscitées grâce au protocole expérimental. En effet, d’un individu à l’autre les réactions à une vidéo de petit chat mignon ou d’accident de skateboard ne sont pas les mêmes. Il est donc important d’évaluer le ressenti des utilisateurs à la fois sur la base de questionnaires appropriés, mais aussi en mesurant leurs réactions physiologiques avec des outils spécifiques.

Dans l’optique de créer ce jeu de données, nous avons développé sur Android une application dédiée, qui a trois fonctions : provoquer des émotions, questionner sur les émotions ressenties et enregistrer les réactions à partir des capteurs (les capteurs inertiels cités précédemment et la frappe au clavier). L’application prend la forme d’un chatbot qui tient le rôle d’expérimentateur et interagit avec l’utilisateur en lui proposant de réaliser des tâches simples et engageantes. En parallèle, nous enregistrons les réactions physiologiques à l’aide de matériel dédié.

L’intelligence artificielle au service de la recherche.

Le protocole mis en place a permis de recueillir des données de nature différenciée afin d’inférer des émotions. Comment traiter des données aussi diversifiées pour en faire une analyse cohérente ? Ce champ de recherche étant novateur, il n’existe pas encore de méthodes dédiées pour traiter de telles données. Cependant, comme évoqué précédemment, les données recueillies sont similaires à celles utilisées pour la reconnaissance des activités physiques, dans des applications de fitness. Nous nous sommes donc inspirés des travaux dans ce domaine. Ici l’apport, des méthodes d’intelligence artificielle, comme l’apprentissage automatique (ou “machine learning” en anglais), n’est plus à démontrer car elles permettent d’analyser automatiquement des données complexes. En effet, à partir de données mises en forme en amont, les modèles d’apprentissage automatique sont en mesure de trouver, par exemple, ce qui différencie la marche de la course. Nous appliquons la même méthode, en labélisant des émotions plutôt que des activités physiques.

La question qui se pose ensuite est la fiabilité des modèles. Ils doivent donc être validés sur des corpus de données différents provenant d’un même échantillon. L’objectif est de déterminer le taux de bonne classification des modèles. Les résultats d’une première expérience ont été présentés lors de la conférence internationale IHIET 2020 (International Conference on Human Interaction and Emerging Technology) [8]. Les enseignements de cette première expérience mettent en évidence des tendances différenciables dans les signaux en fonction de l’émotion induite. En revanche, il reste nécessaire d’envisager de nouvelles méthodes pour l’induction d’émotion afin d’augmenter ces effets.

Conclusion : les trois grands défis de l’informatique affective.

La détection automatique d’émotions constitue pour la recherche scientifique un triple défi. D’abord un défi théorique, avec une importante réflexion pour déterminer les modèles d’émotion les plus appropriés, en fonction du contexte. Ensuite, un défi méthodologique est à relever pour la création de protocoles expérimentaux, permettant le recueil de données suffisamment pertinentes pour fournir une base solide, à la fois en laboratoire ou en situation réelle. Enfin, il reste un défi technique porté par l’émergence de l’intelligence artificielle et l’application pertinente de ses modèles pour traiter les données.

Plusieurs projets de recherche tentent de relever ces trois défis à Orange, en explorant diverses sources de données : expression faciale, paramètres de la voix, déclaration subjective et interactions sur smartphone. Nos travaux ouvrent des perspectives importantes en termes de méthodologie pour explorer ce nouveau domaine. Ainsi, de nouvelles expérimentations sont en cours, qui permettront de valider des protocoles innovants pour la détection des émotions. Il sera par la suite important d’en augmenter la fiabilité et de les adapter aux contextes de la Relation Client pour améliorer la qualité des interactions.

Bibliographie

[1] K. Mahboub, Modélisation des processus émotionnel dans la prise de décision, 2011.

[2] D. Sander et K. R. Scherer, Traité de psychologie des émotions, Dunod, 2014.

[3] P. Ekman, “An argument for basic emotions,” Cognition & emotion 3-4, pp. 169–200, 1992.

[4] J. A. Russell, “A circumplex model of affect.,” Journal of personality and social psychology 39, p. 1161, 1980 .

[5] R. Picard, Affective computing, Perceptual Computing Section, Media Laboratory, Massachusetts Institute of Technology, 1995.

[6] S. Poria, E. Cambria et R. &. H. A. Bajpai, “A review of affective computing: From unimodal analysis to multimodal fusion,” Information Fusion, Elsevier, n° 137, pp. 98-125, 2017.

[7] [En ligne]. Available: https://startup.orange.com/fr/start_up/empath-2/..

[8] N. Simonazzi, J.-M. Salotti et C. &. S. D. Dubois, “Emotion Detection Based on Smartphone Using User Memory Tasks and Videos,” International Conference on Human Interaction and Emerging Technologies, pp. 244-249, 2020.