Résumé

Depuis une vingtaine d’année de nombreuses recherches sont menées chez Orange sur le thème du son 3D. Ce dernier permet de déployer la scène sonore en dehors de l’écran du smartphone, tout autour de l’utilisateur, favorisant ainsi potentiellement son immersion. Mais la plupart des téléphones ne possède qu’une seule enceinte privant ainsi de la possibilité de spatialiser un son, même à minima. On privilégie alors plutôt le casque audio qui permet le déploiement d’une technologie de son 3D qui lui est propre : le rendu binaural simulant une impression de spatialisation du son.

Une expérience menée par les équipes de la recherche d’Orange a démontré que pour construire une scène audiovisuelle avec du binaural, il est a priori inutile de tenir compte de l’environnement réel qui entoure le sujet, et de la distance qui le sépare de son téléphone. Ainsi, le concepteur d’applications n’a pas besoin de considérer l’espace réel qui sépare l’utilisateur du téléphone, mais de simplement le placer dans la scène virtuelle, à la place de la caméra. L’utilisation du binaural sur smartphone semble donc être adaptée à un déploiement grand public, et pourrait constituer une voie d’exploration à l’amélioration de l’expérience utilisateur en contexte mobile.

Article complet

Le binaural, une révolution sonore dans nos smartphones ?

Le son 3D offre une opportunité de déployer la scène sonore en dehors de l’écran, tout autour de l’utilisateur, favorisant ainsi potentiellement son immersion. Mais ce déploiement ne va pas sans poser des questions sur la perception d’une telle scène.

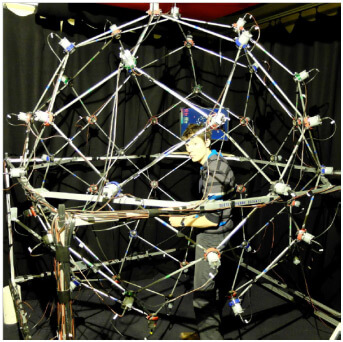

Depuis une vingtaine d’année de nombreuses recherches sont menées à Orange sur le thème du son 3D. Avec l’arrivée des smartphones en 2007, et la diversification des contenus consommés sur ce support qui n’a cessé de croître (films, musiques, jeux vidéo, visioconférence, etc.), l’amélioration de la qualité de restitution audiovisuelle a été un sujet central. Si les résolutions d’écran ont évolué pour s’approcher toujours plus de celles des écrans immobiles (TV, écrans d’ordinateur, etc.), l’espace visuel reste pourtant confiné à une dimension réduite, dépassant rarement les 16 cm de diagonale. Le son 3D est un terme général pour désigner tous les systèmes et technologies de rendu sonore permettant de positionner des sources en plusieurs endroits de l’espace. La stéréophonie (abrégée couramment en stéréo) constitue en cela le système de son 3D le plus connu, puisqu’en s’appuyant sur deux enceintes, c’est-à-dire deux canaux sonores, une source sonore peut-être placée sur l’une ou l’autre enceinte, avec même la possibilité de provoquer l’illusion perceptive qu’elle se trouve à mi-chemin des deux enceintes. D’autres systèmes ont vu le jour et se sont largement répandues ces dernières décennies, comme par exemple le rendu 5.1. Nécessitant cinq enceintes, une frontale, deux latérales avant et deux latérales arrière, plus une enceinte à l’avant dédié aux basses fréquences (dite caisson de basses), cette installation permet de positionner une source tout autour de l’utilisateur sur un plan horizontal. Et ainsi de suite, en multipliant les enceintes autour de l’utilisateur, au-dessus, en dessous, etc., on multiplie les positions possibles pour une source sonore donnée, jusqu’à atteindre la sphère d’enceintes entourant complètement l’utilisateur (comme par exemple le système SphereBedev, image ci-dessous, une installation développée par le laboratoire d’acoustique du CNAM, à Paris, avec 50 enceintes).

Le SphereBedev, une installation sonore au Cnam de Paris avec 50 enceintes.

Sur smartphone, le problème est légèrement différent. La plupart des téléphones ne possède qu’une seule enceinte (quelques rares modèles comportent deux enceintes, mais très proches l’une de l’autre), privant ainsi de la possibilité de spatialiser un son, même à minima. De plus, la multiplicité des contextes d’utilisation (en particulier lorsqu’ils impliquent un mouvement de l’utilisateur) rend le raccordement à un groupe d’enceintes externes fastidieux. On privilégie alors plutôt le casque audio, accessoire adéquat dans tous les contextes, en intérieur ou extérieur, en transport, en déplacement physique ou immobile, etc. Non seulement il permet de restreindre la zone d’écoute à l’utilisateur seul (évitant de déranger les personnes alentour), mais il permet en plus le déploiement d’une technologie de son 3D qui lui est propre : le rendu binaural.

Le binaural, tout comme la stéréophonie, est une technique de rendu sonore qui a besoin de deux canaux : un pour l’oreille droite et un pour l’oreille gauche. Il s’appuie sur les propriétés morphologiques d’un individu pour lui simuler une impression de spatialisation du son [1]. En premier lieu, le binaural, toujours comme la stéréo d’ailleurs, joue sur deux indices de localisation : la différence de temps interaurale (ou ITD pour Interaural Time Difference), et la différence de niveau interaurale (ou ILD pour Interaural Level Difference). Ces deux indices traduisent le fait qu’une source sonore placée en un endroit donné de l’espace n’arrive pas en même temps aux deux oreilles, ni au même niveau sonore. En changeant la position de la source, l’ITD et l’ILD varient. Mais le binaural joue en plus sur une autre propriété particulière de l’écoute humaine. L’oreille étant un organe fait de cavités et de bosses, une source sonore qui lui parvient provoque un jeu de résonance tout à fait particulier, qui va aider l’auditeur à identifier sa provenance. Ces résonances se traduisent en termes de signal par une modification du profil fréquentiel de la source : le son est émis, il arrive à l’oreille, et subit un filtrage qui dépend de la direction par laquelle il arrive. À chaque direction de l’espace sont donc associés un ITD, un ILD et un filtre. Le binaural consiste à exploiter ces informations pour donner à l’oreille, via le casque, l’impression qu’un son provient d’ailleurs.

Il existe deux façons de créer un son binaural [2]. La première consiste à enregistrer naturellement une scène sonore en binaural, et à la restituer telle quelle au casque. On insère dans le creux des oreilles des micros de petite taille qui capture le son enrichi de tous les indices de localisation, ITD, ILD et filtrage. On peut aussi enregistrer le son à l’aide d’une tête artificielle dans laquelle est embarqué un système d’enregistrement sophistiqué (voir l’image ci-dessous). Notons bien ici qu’un enregistrement de scène sonore par une tête artificielle ou par un individu donné est fait sur mesure pour celui l’a capturé. Tout autre écoutant, réceptionnant en quelque sorte les sons avec d’autres oreilles que les siennes, localisera potentiellement moins bien les sources. Cette dégradation dépendra notamment de sa morphologie et de la provenance des sources.

Tête artificielle KU 100 de la marque Neumann.

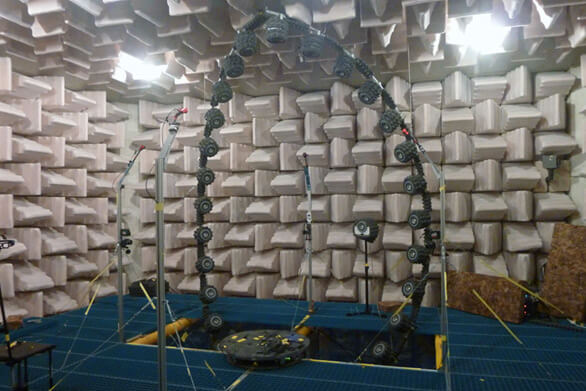

L’autre solution consiste à créer un effet binaural de toute pièce à partir d’un son monophonique, en lui appliquant artificiellement les indices de localisation correspondant à un individu et à une direction de l’espace. Cette technique s’appelle la synthèse binaurale. L’avantage est qu’elle permet de construire une scène sonore spatialisée factice, en particulier des scènes de jeux vidéo ou de films, quand le binaural naturel ne peut capturer que des scènes sonores réelles. L’inconvénient réside en revanche dans le fait que les indices de localisation doivent être mesurés au préalable pour chaque direction de l’espace de chaque individu. Ce procédé de mesure nécessite une préparation et une installation matérielle conséquentes, et doit être exécutée en chambre anéchoïque, inaccessible au grand public (voir l’image ci-dessous). Toutefois, une fois son profil binaural mesuré, un individu peut le réutiliser pour n’importe quelle production sonore.

Salle anéchoïque d’Orange Labs à Lannion avec le système d’enregistrement du profil binaural.

Lorsqu’on construit une scène audiovisuelle avec du son binaural, la question de la cohérence spatiale entre son et image est de première importance. Sur mobile en particulier, puisque nous envisageons la scène sonore spatialisée comme une extension du visuel à l’écran. La problématique est alors d’ordre perceptif, et se pose en ces termes : peut-on séparer spatialement une source sonore de son correspondant visuel sans briser le lien sémantique qui les unit ?

La manière dont un simple objet audiovisuel est perçu par un être humain n’est pas encore complètement connue. De nombreux effets propres à l’association d’un son et d’une image ont déjà été mis en évidence par la recherche. L’un d’entre eux s’appelle l’effet ventriloque, et affecte précisément notre perception spatiale : lorsque deux sources, l’une visuelle et l’autre sonore, sont situées à deux endroits différents mais proches dans l’espace, nous les percevons comme étant localisées au même endroit [3]. En général celui du visuel. Il y a donc une force d’attraction spatiale de l’image sur le son. L’effet ventriloque doit son nom à cette pratique qui nous donne l’illusion qu’une voix provient de la bouche d’une marionnette alors qu’elle est émise par son marionnettiste.

Dans le cas de l’utilisation du binaural avec un écran mobile, la portée de cet effet ventriloque est très importante, car elle nous donne une indication quantitative sur la possibilité de déployer un son hors de l’écran, sans perdre son association sémantique avec le visuel.

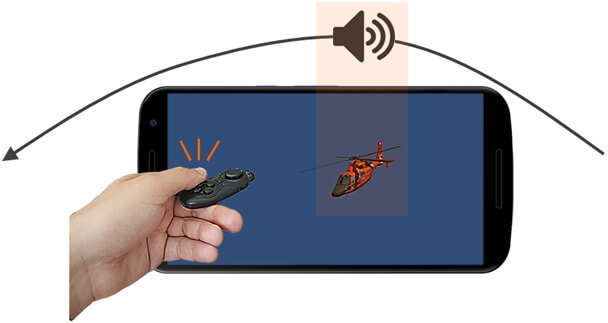

En termes techniques, pour mesurer l’effet ventriloque, nous mesurons la fenêtre d’intégration spatiale audiovisuelle. Il s’agit, pour une position donnée du visuel, de l’ensemble des positions du son pour lesquelles le son et l’image sont perçus comme coïncidents. Une expérience menée à Orange s’est attachée à mesurer cette fenêtre d’intégration dans les conditions particulières du binaural associé à un visuel sur mobile [4]. Le protocole expérimental consiste à demander à un sujet de regarder un visuel immobile sur l’écran du téléphone, et d’écouter en même temps un son binaural qui se déplace sur une trajectoire circulaire horizontale passant par l’écran du téléphone. Le sujet doit presser un bouton au moment où il perçoit un alignement spatial entre le son et l’image (voir la figure ci-dessous). On lui demande de fournir cet alignement pour deux types de trajectoires sonores : une allant de la périphérie de son champ de vision vers son centre, et une allant du centre vers la périphérie. Les deux points d’alignement trouvés forment ainsi les deux bornes de la fenêtre d’intégration, dont on fait l’hypothèse qu’elle encadrera le visuel (on suppose que le sujet détectera un alignement toujours un peu avant que le son ne croise l’image) [5].

Illustration du protocole expérimental : le sujet appuie quand il perçoit que le son et l’image sont alignés.

Le protocole se décline avec deux types de stimuli audiovisuels : un sémantiquement cohérent (visuel d’hélicoptère avec un son de rotor), et un sémantiquement neutre (halo lumineux avec un bruit blanc). Nous souhaitons ainsi connaitre l’influence de la sémantique sur la fenêtre d’intégration.

Un autre paramètre s’ajoute à cette expérience : le niveau d’élévation de la trajectoire sonore. Dans l’utilisation quotidienne d’un smartphone, nous pouvons faire l’hypothèse raisonnable que l’utilisateur tient le téléphone en face de lui. En revanche, il est impossible de connaitre à l’avance le niveau d’élévation du téléphone (à quel niveau l’utilisateur tient-il son téléphone dans les mains ?), qui peut varier au cours même d’un même visionnage. Ainsi donc, il est crucial de mesurer l’influence d’un changement d’élévation de la trajectoire sonore sur la fenêtre d’intégration. Nous introduisons donc deux nouvelles trajectoires localisées au-dessus de la tête de l’utilisateur, en plus des deux qui passent au niveau du téléphone.

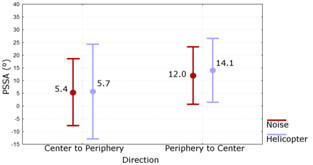

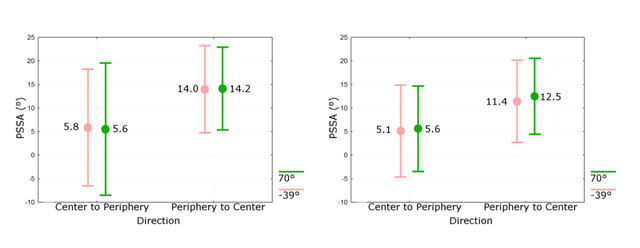

Les résultats de cette expérience indiquent plusieurs choses. Dans les trois graphiques ci-dessous, la position du point d’alignement est exprimée en ordonnée par un angle en degrés azimuts, le 0° étant la position centrale face à l’utilisateur, et 90° étant la position latérale face à son oreille droite. Tout d’abord, on observe que l’alignement diffère significativement selon le type de trajectoire (centre vers périphérie ou périphérie vers centre), indication que le sujet perçoit bien une zone à l’intérieur de laquelle le son et l’image coïncident, ce qui confirme de l’existence d’une fenêtre d’intégration. Deuxièmement, cette fenêtre est identique dans tous les cas. La différence sémantique et l’élévation n’ont pas d’influence sur la fenêtre. D’une part l’effet ventriloque n’est donc pas influencé par le type de stimuli, et d’autre part surtout, l’effet ventriloque semble suffisamment fort en élévation pour masquer les potentiels décalages spatiaux entre son et image, quelle que soit la hauteur à laquelle l’utilisateur tient son smartphone.

Point d’alignement détecté entre son et image, exprimé en degrés azimuts, pour chaque trajectoire et chaque type de stimuli.

Point d’alignement détecté entre son et image, exprimé en degrés azimuts, pour chaque élévation, stimuli d’hélicoptère à gauche, stimuli de bruits blancs et halo lumineux à droite.

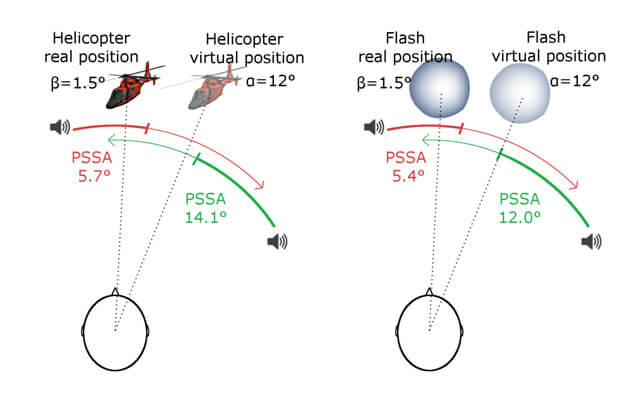

Enfin, dernier résultat important, contrairement à l’hypothèse émise, la fenêtre d’intégration n’est pas centrée sur le visuel. Comme indiqué dans la figure ci-dessous, la fenêtre est systématiquement décalée vers la périphérie. Cependant, elle encadre la position du visuel dans la scène virtuelle.

Les fenêtres d’intégration pour les deux stimuli ne sont pas centrées sur la position réelle du visuel, mais sur sa position dans la scène virtuelle.

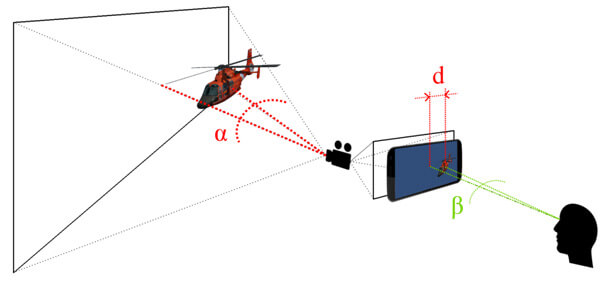

La scène virtuelle est la scène dans laquelle ont été positionnés tous les objets visuels qui vont être capturés par une caméra, avant d’être mis « à plat » et retransmis à l’écran. On imagine aisément par exemple une scène de film, avec son décor, ses objets, ses personnages qui s’y déplacent. Tout est enregistré par une caméra pour être diffusé ensuite à l’écran. Dans la figure ci-dessous, la partie gauche représente la scène virtuelle dans laquelle le visuel est positionné. Ici c’est un hélicoptère, décalé par rapport à la caméra d’un angle horizontal alpha. La caméra enregistre l’image, avec les propriétés optiques qui sont les siennes, qui déforment la scène pour l’aplatir. Ces changements résultent en la transformation de l’angle alpha en distance d qui sépare l’hélicoptère du centre de l’écran. Enfin, le sujet à droite observe l’hélicoptère retransmis comme étant décalé d’un angle horizontal beta par rapport au centre de son visage.

Processus de transmission de la scène virtuelle, de sa capture par la caméra jusqu’à sa réception par le spectateur.

Pour revenir au décalage de la fenêtre d’intégration, nous l’interprétons de la manière suivante : le sujet ne considère pas la position de l’hélicoptère avec l’angle beta, qui est pourtant l’angle avec lequel il observe physiquement le visuel, mais avec l’angle alpha. En d’autres termes, le sujet se projette à l’intérieur de la scène virtuelle, comme s’il était placé à la position de la caméra. Ce résultat est très intéressant, car il constitue une marque directe de l’immersion du sujet. Il indiquerait finalement que pour construire une scène audiovisuelle avec du binaural, il est a priori inutile de tenir compte de l’environnement réel qui entoure le sujet, et de la distance qui le sépare de son téléphone.

Pour nous résumer, on peut exprimer tous ces résultats en adoptant le point de vue du concepteur d’applications. L’expérience révèle qu’il n’a pas besoin de considérer l’espace réel qui sépare l’utilisateur du téléphone, mais de simplement le placer dans la scène virtuelle, à la place de la caméra. Et quand bien même souhaiterait-il tenir compte de cette espace réel, la largesse de l’effet ventriloque en élévation lui permet de s’affranchir des potentiels mouvements verticaux de l’écran.

En conclusion, l’utilisation de la technologie binaurale sur smartphone, malgré les difficultés qu’elle présente de prime abord en termes de perception, semble être adaptée à un déploiement grand public. Une technologie nouvelle, mais qui utilise un support matériel simple et peu coûteux, un casque ou une paire d’écouteurs, déjà largement répandu sur le marché. Nous l’avons évoqué plus haut, elle est la candidate parfaite à l’amélioration de l’expérience sur mobile, au-delà du visuel, et loin devant d’autres solutions de sonorisation externes, ajout de haut-parleurs directement sur l’appareil (contrainte de taille), ou système d’enceintes indépendantes (contrainte de mobilité, mais on pourra toutefois envisager cette solution dans des contextes statiques spécifiques). Enfin, toutes les questions sur le binaural ne sont pas résolues. Si elle est perceptivement viable, qu’en est-il de l’apport effectif de cette technologie lorsqu’elle est introduite dans les multiples contextes quotidiens d’utilisation d’un smartphone ? Enrichit-t-elle réellement l’expérience utilisateur ? L’auteur de cet article étudie précisément cette problématique dans le cadre de sa thèse, dont les résultats ne tarderont pas à être publiés.

En savoir plus :

[1] Un classique indispensable sur la perception spatiale du son chez l’être humain : Blauert, J. (1997). Spatial hearing: the psychophysics of human sound localization. MIT press.

[2] Du même auteur, livre très complet sur la technologie binaurale : Blauert, J. (Ed.). (2013). The technology of binaural listening. Springer Science & Business Media.

[3] Un exemple d’expérience qui met en évidence l’effet ventriloque : Bertelson, P., & Radeau, M. (1981). Cross-modal bias and perceptual fusion with auditory-visual spatial discordance. Perception & psychophysics, 29(6), 578-584.

[4] Notre publication sur l’expérience : Moreira, J., Gros, L., Nicol, R., & Viaud-Delmon, I. (2018, October). Spatial Auditory-Visual Integration: The Case of Binaural Sound on a Smartphone. In Audio Engineering Society Convention 145. Audio Engineering Society.

[5] Ce protocole de mesure est utilisé pour la première fois ici : Lewald, J., Ehrenstein, W. H., & Guski, R. (2001). Spatio-temporal constraints for auditory–visual integration. Behavioural brain research, 121(1-2), 69-79.