Introduction

Depuis une dizaine d’années, la recherche en « intelligence artificielle » (IA) connaît des avancées importantes[2]. Nourries par les grandes bases de données du web ainsi que par une puissance de calcul accrue, les méthodes d’apprentissage machine ont notamment permis des progrès spectaculaires dans les domaines de la reconnaissance d’images, la traduction automatique ou le traitement du langage naturel. Dans de nombreux secteurs, l’usage d’algorithmes transforme les activités sociales et l’organisation du travail. Les systèmes à base d’IA pénètrent aussi le quotidien avec la commercialisation d’assistants vocaux ou de robots sociaux. La diffusion accrue de ces technologies notamment dans des domaines sensibles (administration, justice, santé, sécurité, interactions sociales) suscite autant d’espoirs que d’inquiétudes et contribue à l’émergence de la problématique de « l’éthique de l’IA ». Ce domaine s’est tout d’abord configuré autour de la critique des algorithmes vus comme des « boîtes noires » (Crawford 2021; Pasquale 2016) dans le but d’augmenter leur « explicabilité » et la « transparence » concernant leurs objectifs. Plus récemment, les réflexions portent aussi sur le choix des données utilisées pour l’entraînement des algorithmes, la justice et l’équité par la correction des biais, la non-malfaisance, la responsabilité et la privacy (Jobin et al. 2019).

La « dernière vague de l’IA » marque la montée en puissance des acteurs privés (grandes entreprises du numérique) sur les questions d’éthique et de régulation face à laquelle chercheurs et politiques cherchent à se positionner.

Cette montée en puissance du sujet s’accompagne de nombreux discours – récits médiatiques, commentaires, analyses, recommandations, mises en garde, rapports d’experts et chartes éthiques – qui foisonnent dans l’espace public et participent à la mise en sens de l’IA. Cette médiatisation conduit même à l’adoption de régulations publiques, comme en témoigne le récent projet de réglementation sur l’intelligence artificielle proposée par l’Union Européenne.

Dans ce texte, nous nous intéressons aux processus de publicisation de l’IA et à la circulation des discours entre les arènes scientifique, médiatique et politique. Comment l’IA émerge-t-elle comme objet d’attention dans l’espace public français ? Comment cet objet structure-t-il des nouvelles arènes publiques, des réseaux d’acteurs, et des modes de financement de la recherche ? Quels principaux arguments en faveur ou opposés au développement et à l’usage de systèmes d’IA structurent-ils les débats ? Articulant des méthodes quantitatives et qualitatives, nous avons étudié divers lieux de production des controverses : presse, rapports publics, laboratoires scientifiques ou encore organisations privées (voir encadré méthodologique). Des outils quantitatifs d’analyse textuelle et de réseau ont permis de traiter systématiquement le grand nombre d’acteurs et d’articles aux tonalités et thématiques variées, pour faire émerger la structure des débats dans l’espace public. De manière complémentaire, les entretiens avec les acteurs des controverses éclairent les résultats de l’analyse quantitative et permettent de comprendre comment les journalistes et les scientifiques ont perçu et contribué à la publicisation de l’IA.

L’arène médiatique : un discours de rupture

Notre étude de l’arène médiatique s’appuie sur la constitution d’un très large corpus d’articles (35 237), issus des principaux titres de la presse quotidienne nationale et régionale, ainsi que de quelques magazines hebdomadaires, entre 2000 et 2019. Ce corpus offre ainsi un aperçu inédit de près de vingt ans de traitement médiatique de l’IA en France.

Le premier résultat vient de l’augmentation exponentielle du nombre de publications annuelles au cours de cette période : alors qu’on compte 700 articles publiés pour l’année 2000, ce chiffre est multiplié par 10 en 2018 avec 7 288 articles, un pic en partie dû à la remise du rapport Villani « Donner un sens à l’intelligence artificielle »[3]. La présence croissante des débats sur l’intelligence artificielle dans la presse généraliste est l’un des signes les plus immédiats de leur diffusion au-delà des sphères spécialisées. Les médias jouent en effet un rôle central dans la publicisation des questions et des troubles qui agitent les différents acteurs de l’IA – fabricants, chercheurs et utilisateurs. Ils contribuent par ailleurs à formaliser un cadre de réception de ces technologies et à inscrire des questions nouvelles à l’agenda des politiques publiques.

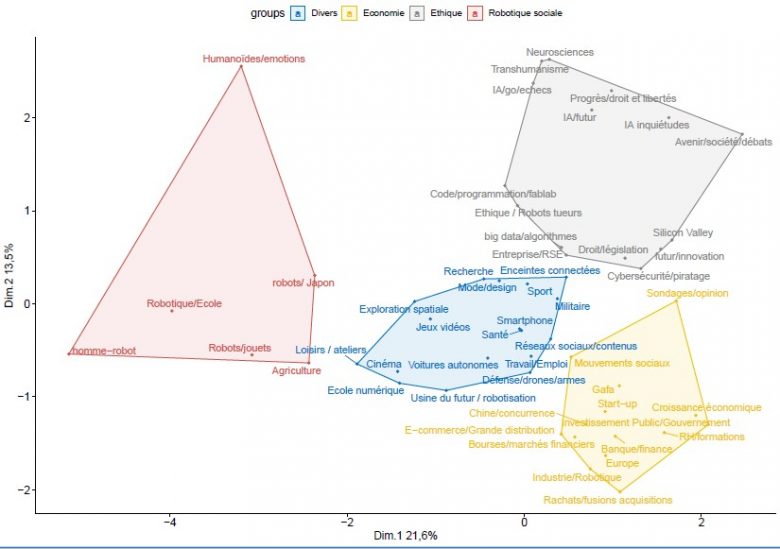

Une étude thématique plus fine du corpus permet de montrer que les manières de parler de l’IA ont changé. La réalisation d’un modèle thématique pour qualifier les grands enjeux abordés dans la presse fait ressortir quatre pôles de débats (voir Figure 1).

Le premier, largement surreprésenté dans la presse régionale, interroge surtout les interactions humain-machine et le déploiement de la robotique sociale, à l’école ou à l’hôpital. Il est proche d’un second ensemble thématique, relativement central, qui décline les différentes implications sectorielles de l’IA, notamment dans les industries. Adoptant une vision plus macro, un autre pôle thématique regroupe les enjeux économiques liés à l’IA, notamment en termes de croissance ou d’indépendance commerciale vis-à-vis des géants comme la Chine et les Etats-Unis. Enfin, un dernier pôle consacré aux enjeux éthiques de l’IA, de la protection de la vie privée à la discrimination algorithmique, recense les inquiétudes liées aux développements présents, mais surtout futurs, de ces technologies. Or, c’est justement cette thématique éthique qui va prendre de l’importance à partir du milieu de la décennie 2010, et s’imposer comme une manière dominante de formaliser les questions liées à l’intelligence artificielle.

Figure 1 – les quatre pôles du débat

Finalement, ce qui domine dans la presse, ce sont avant tout les discours de rupture, puisant volontiers dans les références populaires de la science-fiction pour insister sur les transformations majeures que porteraient les innovations dans le domaine de l’intelligence artificielle. Les entretiens complémentaires avec les journalistes montrent à quel point ces discours s’inscrivent dans des stratégies et des contraintes propres à l’arène médiatique, dont les acteurs doivent sans cesse trouver le moyen d’intéresser leur lecteur – mais surtout leur rédaction – à ces enjeux techniques souvent complexes. Ce faisant, les journaux se font parfois aussi le relais d’un discours marketing de l’IA développé par les GAFAM, visant à susciter une certaine fascination et un engouement pour ces technologies, de plus en plus déployées dans des objets du quotidien, du smartphone à l’enceinte connectée.

L’arène scientifique : un discours de continuité

A cette mise en scène médiatique d’une rupture technologique spectaculaire, les scientifiques interviewés opposent tout d’abord un discours de la continuité qui met en question la notion même de l’IA considérée trop vague et polysémique. Leurs récits décrivent un développement progressif et cumulatif d’une famille de technologies qui vont être rassemblées plus tard sous le label « IA ». Il s’agit d’une histoire complexe, au long cours, faite d’avancements graduels et diffus de l’informatique et des domaines voisins et non de découvertes spectaculaires. Cette histoire mêle les approches de l’IA symbolique (fondée sur la simulation de la manipulation de symboles par le raisonnement humain) et de l’IA connexionniste (fondée sur la reproduction du fonctionnement des réseaux de neurones) plus qu’elle ne les oppose. Pour les chercheurs en IA interrogés, l’opposition entre ces deux approches a été érigée par certains commentateurs – notamment issus du monde industriel – en moteur du progrès scientifique, consacrant la victoire récente de la seconde. Mais en réalité, la montée en puissance de l’IA connexionniste est surtout nourrie par la convergence d’évolutions technologiques favorables (augmentation de la puissance de calcul des ordinateurs, disponibilité de grandes bases de données d’apprentissage du web).

Les discours médiatiques de la rupture technologique derrière la « vague de l’IA » sont alors fortement critiqués par les scientifiques du domaine. Pour eux, il s’agit d’un artifice. L’effervescence médiatique et politique autour de l’IA ne correspond pas à des découvertes scientifiques mais à une mise en scène médiatique qui obéit à une « logique de buzz » :

« Dans l’arène journalistique, il y a un fonctionnement à base de buzz. Il y a cinq ans, le buzz, c’était les imprimantes 3D. […] Et alors pour eux, c’était le truc qui allait transformer le monde, et puis ça a été un peu rendu obsolète par la vague du buzz de bitcoins ou blockchain, et puis ça a été rendu obsolète par la vague IA. Et puis je ne sais pas quelle sera la suivante. Je ne pense pas que cela reflète une réalité scientifique, une réalité intellectuelle c’est très lié au fonctionnement politico-médiatique. » (entretien informaticien)

Un deuxième résultat fort du volet qualitatif met en évidence le fait que l’arène médiatique et l’arène scientifique écrivent des chronologies concurrentes aussi bien de l’IA que des questions de son encadrement éthique.

L’évènement scientifique qui lance l’IA connexionniste pour la communauté scientifique est la mise au point en 2012 d’un système de traitement de l’image basé sur l’apprentissage et les réseaux de neurones qui a de meilleures performances que les systèmes classiques. Présenté lors de la Conférence européenne annuelle en « Computer Vision », ce système présenté par l’équipe de Geoffroy Hinton (Université de Toronto), bat tous les autres algorithmes de reconnaissance d’image :

« Donc on a commencé à en parler, mais c’était scientifique, et c’était surtout la communauté vision, à l’époque qui s’en est emparé. » (entretien roboticien)

Pourtant, ce n’est qu’en 2016 que l’IA entre dans l’espace public. Ce moment ne correspond pas à des découvertes scientifiques concomitantes mais à la médiatisation de certaines prouesses technologiques, notamment la transmission en direct sur Youtube de la victoire en 2016 du système Alpha Go, développé par Google Deep Mind, contre Lee Sedol, champion du monde du jeu de Go :

« Donc AlphaGo qui gagne contre le champion du monde du jeu de Go, et c’est une intelligence artificielle, et là, les médias s’enflamment complètement parce que c’est très symbolique. […] Là, les téléphones des journalistes ont chauffé pour téléphoner aux experts en intelligence artificielle en leur demandant qu’est-ce qui se passe. […] . Donc je pense que c’est vraiment un élément déclencheur. Avant, c’était des choses plus ou moins qui intéressaient les uns ou les autres ou pas du tout, mais là, ça intéressait les grands médias. » (entretien roboticien)

« Il me semble que le buzz IA a commencé avec la victoire d’AlphaGo sur Lee Sedol, qui a été sans doute surmédiatisée si on compare à la victoire Deep Blue sur Kasparov. » (entretien informaticien)

Pour les experts, les processus de médiatisation qui portent l’IA dans l’espace public sont fortement soutenus par les entreprises numériques cherchant à valoriser leurs données et à promouvoir leurs services :

« Toutes ces entreprises qui étaient des entreprises du numérique sont devenues, enfin elles sont restées ce qu’elles sont, mais elles ont été étiquetées intelligence artificielle. » (entretien roboticien)

La dissonance chronologique entre les arènes médiatique et scientifique marque également le traitement des questions éthiques. Alors que le sujet « l’éthique de l’IA » ne s’impose dans la presse française qu’en 2015 (cf. supra), c’est une préoccupation forte des chercheurs en robotique dès les années 2000 liée notamment aux avancées dans les domaines des armes autonomes et de l’interaction humain-machine :

« C’est la maturité du domaine qui fait qu’il y a des choses qui ne sont plus des sujets de recherche, mais des applications possibles, même si elles ne sont pas forcément très développées. Et donc on s’interroge sur l’impact sur la société, sur les humains. Avant, on travaillait, on avait des robots dans des labos, éventuellement, on pensait envoyer un robot sur mars. » (entretien roboticien)

Dans ce contexte, bien avant la « vague IA » portée par les discours promotionnels et le foisonnement des chartes éthiques qui a suivi, un tout premier colloque international sur la « roboéthique » est organisé à l’école de robotique de San Remo, en Italie en 2004. En France, les chercheurs en robotique travaillent dès 2012 sur l’éthique de la recherche en robotique au sein de la Commission de réflexion sur l’éthique de la Recherche en sciences et technologies du Numérique d’Allistene (cf. CERNA 2014).

L’émergence d’une réflexion éthique sur l’IA dans l’arène scientifique est donc bien antérieure à la médiatisation des progrès réalisés par les techniques d’apprentissage machine et notamment les réseaux neuronaux, dix ans plus tard. L’« éthique » de l’IA apparaît comme un vecteur de circulation des controverses entre arènes scientifique, médiatique, économique et politique.

L’arène politique : un discours éthique

Comparativement aux médias et aux experts, le monde politique s’est emparé relativement tard des controverses de l’intelligence artificielle. A partir de 2017 néanmoins, on compte plusieurs rapports émanant des institutions publiques (Parlement, CNIL, Premier Ministre, Union européenne) dédiés à l’évaluation des potentiels mais aussi des risques liés au développement de ces nouvelles technologies. Le plus emblématique est bien le rapport Villani « Donner un sens à l’intelligence artificielle » dont la rédaction s’appuie sur pas moins de 407 contributions expertes. Publié en mars 2018, il préfigure dans un même mouvement l’adoption d’un vaste plan d’investissement pour le développement de l’intelligence artificielle en France et l’engagement du gouvernement pour la prise en compte des enjeux éthiques de l’IA. Ce dernier est symbolisé par le lancement du réseau Tech for Good, qui réunit entrepreneurs et politiques autour d’une technologie engagée et responsable.

L’appropriation des controverses de l’IA dans l’arène politique se cristallise alors autour des enjeux éthiques, comme une manière de formaliser divers troubles qui émergent dans l’espace public. Ce faisant, les rapports publics mobilisent et font évoluer une réflexion éthique qui s’est développée dès le début des années 2000 dans l’arène scientifique, pour en faire un instrument de politique publique. Cette circulation doit beaucoup à l’implication de chercheurs de premier plan, qu’ils soient issus de laboratoires publics ou privés, dans la rédaction de ces rapports publics, tels Cédric Villani, déjà cité, mais aussi Nozha Boujeema (INRIA) ou encore Raja Chatila (ISIR-CNRS). En lieu et place d’une règlementation contraignante de l’IA, les rapports défendent, avec l’approche éthique, une régulation plus souple qui ne porterait pas atteinte à l’innovation technologique. Il s’agit d’en appeler à la responsabilité des acteurs économiques et scientifiques pour garantir la fiabilité des systèmes d’IA et leur respect des droits et libertés citoyennes, par l’adoption de chartes communes ou de nouveaux outils d’évaluation interne. Ce discours éthique passe ainsi par la diffusion de principes comme la « transparence » ou la « loyauté » des algorithmes, nouveaux impératifs du développement des systèmes d’intelligence artificielle. Ces principes se révèlent pourtant difficiles à évaluer en pratique. Une étude plus fine des interactions suscitées au sein de l’entreprise par la grille d’évaluation pour une IA de confiance proposée par l’Union Européenne montre la difficulté des personnels, qu’ils soient juristes ou ingénieurs, à traduire et à adapter leurs pratiques à ces nouvelles contraintes souvent abstraites.

Plus généralement, la politisation des questions éthiques en fait un objet de luttes entre scientifiques, pouvoirs publics et fabricants d’IA. En effet, si ces derniers ont largement participé à l’inflation des discours éthiques dans l’espace public, ils craignent désormais la mise en place de nouvelles régulations contraignantes pour le développement industriel de l’intelligence artificielle. Le conflit porte alors tout autant sur les acteurs les plus légitimes à définir les normes éthiques que sur les manières dont elles doivent être mises en application (droit souple, solutions techniques ou nouvelles régulations). Car l’émergence de l’IA comme objet d’attention publique et la consécration de l’« éthique de l’IA » comme catégorie d’action publique s’accompagnent à la fois d’une reconfiguration des carrières scientifiques (avec de nouvelles circulations public/privé) et d’un déplacement des financements publics au profit de projets articulant intérêts économiques, politiques et scientifiques.

Conclusion

L’articulation de méthodes quantitatives et qualitatives dans cette étude offre un regard inédit sur un espace de débats foisonnant, restituant sa temporalité et sa pluralité qui contribuent à l’incertitude et au sentiment de perplexité suscité par les développements récents de l’IA pour le grand public. Il en ressort que si l’essor de l’IA dans l’espace médiatique doit beaucoup aux avancées réelles dans le domaine de l’apprentissage machine, l’inflation des discours, elle, est surtout le résultat de la mobilisation d’acteurs dans l’espace public. Ce sont notamment les fabricants d’IA eux-mêmes qui, dans le contexte d’une compétition accrue, ont favorisé la diffusion d’un discours ambigu de rupture technologique, à la fois enthousiaste et inquiet, sur les potentialités des nouveaux systèmes. Traduite dans le langage médiatique, cette communication des grandes entreprises numériques contribue à la circulation de controverses sur l’IA, des arènes scientifiques à l’espace public médiatique.

La montée des controverses sur l’intelligence artificielle a finalement favorisé l’émergence de l’« éthique de l’IA » comme un nouveau « problème public ». En effet, le développement de l’IA est présenté comme porteur de nombreux risques auxquels la formulation de principes éthiques et leur mise en œuvre dans les collectifs de travail doivent répondre.

La constitution de l’éthique de l’IA comme enjeu public est le fruit de mobilisations multiples, d’abord au sein de l’arène scientifique elle-même, puis progressivement à sa périphérie avec l’émergence de centres de recherche au statut hybride, réunissant chercheurs publics et privés autour de la production de recommandations éthiques. Pour autant, le processus d’émergence de ce problème public est loin d’être abouti et les programmes d’actions sont encore incertains car les discours éthiques opposent les différents acteurs aussi bien sur la réalité des dangers que sur les manières d’y répondre.

Les enseignements de cette étude pour Orange sont multiples : saisir la manière dont on parle d’IA c’est comprendre les attentes et craintes qu’elle suscite, mais surtout la manière dont ces inquiétudes et enthousiasmes sont construits par l’intervention de multiples acteurs dans le temps. L’analyse des discours en présence dans l’espace public révèle la construction sociale du sens de l’IA. Elle montre des oppositions fortes entre acteurs et visions des technologies qui invitent à abandonner une approche monolithique aussi bien de l’intelligence artificielle que de son encadrement éthique.

[1] Un témoignage de cette dynamique est l’appel signé par plus de mille experts – et l’engouement médiatique qui l’accompagne – alertant sur les « risques majeurs pour l’humanité » que l’IA pourrait porter et réclamant une pause de six mois dans le développement de systèmes supérieurs à Chat GPT-4 (« Pause Giant AI Experiments: An Open Letter », https://futureoflife.org/open-letter/pause-giant-ai-experiments (consulté le 07/07/2023)).

[2] Pour une version détaillée de cette recherche voir : BELLON Anne, VELKOVSKA Julia, « L’intelligence artificielle dans l’espace public : du domaine scientifique au problème public. Enquête sur un processus de publicisation controversé », Réseaux, 2023/4 (N° 240), https://www.cairn.info/revue-reseaux-2023-4-page-31.htm

[3] Tout porte à croire que cette croissance s’est légèrement ralentie et qu’on assiste à une réduction de cette « bulle médiatique » sur l’IA : on compte encore 7635 articles publiés en 2019, mais 4 618 en 2020 (année du Covid) et 5137 en 2021.

Méthodologie :

- Volet quantitatif: analyse de la presse française sur 20 ans (2000- 2020), (n=35 237). Analyse quantitative textuelle et des réseaux

- Volet qualitatif: 17 entretiens avec les acteurs des controverses autour de l’IA : 11 scientifiques (robotique, informatique, sciences cognitives, philosophie), 4 journalistes, 1 cadre entreprise numérique, 1 cadre haute fonction publique (2019-20)

- Volet documentaire: 13 rapports publics émanant d’organisations scientifiques (CERNA, IEEE) ou politico-administrative (OCDE, CNIL, UE) en France et dans le monde (2006-2019).

En savoir plus :

- AI Act – https://artificialintelligenceact.eu/fr/

- Beaudouin V. et Velkovska J. (dir.) (2023) « ‘Ethique de l’IA’ : enquêtes de terrain », Réseaux n° 240

- Bellon, A. & Velkovska, J. (2023). « L’intelligence artificielle dans l’espace public : du domaine scientifique au problème public: Enquête sur un processus de publicisation controversé ». Réseaux n°240.

- Beaudouin, V. & Velkovska, J. (2023). « Enquêter sur l’« éthique de l’IA »». Réseaux n° 240.

- Bellon A. (2020). « L’intelligence artificielle en débat. De la bulle discursive au problème public ». Rapport de recherche, Orange Labs

- Collectif CERNA. (2014). Ethique de la recherche en robotique. http://cerna-ethics-allistene.org/digitalAssets/38/38704_Avis_robotique_livret.pdf

- Crawford, K. (2021). Atlas of AI. Power, politics and the planetary costs of Artificial Intelligence. New Haven and London: Yale University Press.

- Jobin A., Ienca M., et Vayena E. (2019) « The global landscape of AI ethics guidelines », Nature Machine Intelligence, vol. 1, no9, 389‑399.

- Pasquale, Frank. (2016). Black box society : the secret algorithms that control money and information. Harvard University Press.

- Schiff D., Biddle J., Borenstein J., et Laas K. (2020) « What’s Next for AI Ethics, Policy, and Governance? A Global Overview», 2020, p. 153‑158.