“Il y a 58 millions d’électeurs de Donald Trump et je n’en ai vu aucun.”

“Il y a 58 millions d’électeurs de Donald Trump et je n’en ai vu aucun”. Ce 8 novembre 2016, la victoire du candidat républicain étonne le journaliste Matthew Hugues, comme la majorité des analystes politiques. Depuis un livre remarqué du militant d’Internet Eli Pariser en 2011 (“The Filter Bubble”), le phénomène à l’origine de l’incompréhension de Matthew Hugues est connu sous le nom de “bulle de filtres”.

Les contenus que nous voyons en ligne, sur les moteurs de recherche, sur les fils d’actualité des réseaux sociaux ou encore sur les services de musique ou de vidéo à la demande sont en effet sélectionnés par des algorithmes. Ceux-ci discriminent sur la base de nos goûts et idées ou de ceux de nos “amis”. Pour Eli Pariser, ce biais de sélection nous enferme dans une bulle, car il masque la pluralité des opinions et donc la réalité du monde. Pire : il se double d’un biais de confirmation, car le fait de ne lire que des arguments semblables aux nôtres nous conforte dans nos positions ‒ au risque de nuire à notre ouverture d’esprit.

Mathématique et marketing

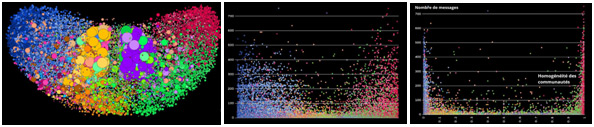

En 2018, une étude du MIT a permis, en trois visuels, de matérialiser ces “bulles de filtres” et de rendre compte du phénomène de polarisation des opinions.

Sur le premier visuel, la taille des cercles représente l’importance des communautés politiques : sans surprise, les opinions médianes rassemblent le plus grand nombre d’internautes. Mais sur le deuxième, on voit que les opinions extrêmes partagent beaucoup plus de contenus que le centre, plutôt silencieux. Quant au troisième, il montre l’homogénéité des communautés : plus on s’éloigne du centre, plus les communautés sont composées d’individus qui pensent exactement la même chose. Ces “chambres d’écho” favorisées par les algorithmes sont un terreau pour la propagation des “fake news” ‒ qui sont 70 % plus partagées que les informations des médias classiques, selon le MIT.

Le fonctionnement des “bulles de filtres” est très mathématique et marketing : le Newsfeed Ranking Algorithm mis en place par Facebook en 2011, par exemple, trie les informations visibles en attribuant une note à chaque contenu, à l’aide de 100 000 paramètres destinés à mesurer la popularité dans le réseau des amis proches et l’adéquation avec le profil de l’utilisateur. Aux États-Unis, le réseau social range ses utilisateurs parmi 98 catégories politiques afin d’offrir un ciblage très fin aux annonceurs. Plus d’un million de scénarios publicitaires peuvent ensuite être générés sur la base des données d’interaction entre les consommateurs et la marque. Du côté des moteurs de recherche, les internautes sont profilés grâce aux cookies qu’ils laissent au cours de leur navigation. Ainsi, deux utilisateurs effectuant la même recherche n’obtiennent pas tout à fait les mêmes résultats, car, selon les informations de leur profil, les liens sont ordonnés différemment.

Les filtres ne sont pas l’apanage des algorithmes

Quelles sont les conséquences de ces traitements algorithmiques sur l’accès à l’information, la pluralité des opinions et leur confrontation au sein de la société ? Les détracteurs d’Eli Pariser estiment l’impact des “bulles de filtres” exagéré, notamment car Internet n’est pas encore la principale source d’information des individus. Selon une étude menée par des économistes des universités Brown et Stanford, les Américains citent toujours majoritairement la télévision comme première source d’information.

L’étude ne permet pas de constater une polarisation beaucoup plus importante des opinions sur plusieurs années (1996-2012). Par ailleurs, les réseaux sociaux peuvent avoir un impact positif sur la vie démocratique, comme l’ont illustré les Printemps arabes. Autre exemple : en 2017, un post sur Facebook a conduit 2,6 millions de personnes à manifester dans les rues de Washington en faveur du respect des femmes.

Surtout, les filtres ne sont pas ‒ loin de là ‒ l’apanage des algorithmes : la question est avant tout celle de la formation des opinions dans le contexte social. Depuis les années 1950 à 1970, les psychologues décrivent l’homophilie (le fait de se conformer aux opinions de ses proches, même sans connaissance de leur véracité) et, “a contrario”, la tendance à éviter toute dissonance cognitive (tension interne qui surgit de la confrontation d’idées contradictoires). Le sociologue Dominique Cardon décrit cette idée : “La bulle, c’est nous qui la créons. Par un mécanisme typique de reproduction sociale. Le vrai filtre, c’est le choix de nos amis, plus que l’algorithme de Facebook”.

Un enjeu démocratique

Pour dépasser ces biais, il faut sortir de sa “zone de confort” intellectuelle et s’entourer d’amis aux opinions variées ‒ mais aussi lire et commenter leurs contenus sur les réseaux sociaux. Sur les moteurs de recherche, la suppression régulière des cookies ou simplement la navigation privée offrira des résultats radicalement différents à qui souhaite s’informer de façon plus neutre.

Et ensuite ? Pour rester bien informé sur Internet, la connaissance du fonctionnement des algorithmes devient un enjeu démocratique, qui passe par l’éducation du citoyen. Une tâche à laquelle les médias ont été les premiers à s’atteler, en créant des unités de “fact-checking” (vérification des faits) pour lutter contre les “fake news”.

Facebook a noué des partenariats avec ces vigies de l’info dans de nombreux pays et explore d’autres pistes, comme la proposition de contenus connexes alternatifs et de contre-information en dessous des articles d’opinion partagés, ou encore des systèmes de signalement des contenus de désinformation par les utilisateurs et des outils de détection des “fermes à spams” et d’exclusion des comptes concernés. Le réseau social a lancé le 25 octobre 2019 aux États-Unis Facebook News, un service réservé à une information “de qualité” et qui promet de percer les “bulles de filtres” grâce à une sélection d’articles provenant de divers partis politiques.

Twitter, de son côté, envisage d’ajouter dans le flux d’actualité des messages d’internautes que l’utilisateur ne suit pas, et avec qui il n’est pas d’accord pour corriger l’effet des “bulles de filtres”. Google a lui mis en place un label signalant les articles vérifiés dans son moteur de recherche et d’actualités. Il s’est aussi lancé avec Facebook et une coalition de médias dans le projet First Draft, qui vise à combattre les fausses informations.

La fin des filtres et des “fake news” ?

Des universités et des ONG innovent aussi en faveur de la pluralité de l’information. Par exemple, une extension de navigateur informe l’internaute lorsqu’il arrive sur un site de “fake news”. L’agrégateur de médias sociaux Gobo permet, lui, aux utilisateurs de “prendre le pouvoir” en leur proposant des filtres qu’ils peuvent paramétrer. Le Centre des médias civiques, le Media Lab et le Laboratoire d’études comparatives des médias du MIT mettent à disposition de tous le prototype.

Les efforts conjugués des différentes parties prenantes suffiront-ils à ne faire des “bulles de filtres” et des “fake news” qu’un souvenir ? Eli Pariser, optimiste, dresse un parallèle avec les habitudes alimentaires. Dans un entretien au “Monde” en 2018, il déclare : “Pendant très longtemps, les restaurants de fast-food se sont développés à une vitesse incroyable. Mais à un moment, les consommateurs ont compris que manger des hamburgers tous les jours créait des problèmes de santé, et ils ont cherché d’autres options. Nous voyons aujourd’hui toute une gamme de fast-foods qui proposent de la nourriture plus saine.”