● Training, inférence, résilience : Orange adapte ses réseaux aux exigences de l’IA, en collaborant avec l’écosystème des datacenters et des constructeurs et en déployant des solutions hybrides.

● Face à l’obsolescence rapide des GPU, l’opérateur parie sur des infrastructures modulaires et des protocoles comme le propose Mplify pour rester compétitif dans un marché en pleine mutation.

● Jamy Rousseau, Senior Strategic Marketing Manager for AI chez Orange Wholesale, fait le point.

Aujourd’hui, l’essor de l’IA et l’émergence des neocloud providers transforment les besoins en connectivité. Comment Orange s’adapte-t-il à ces nouveaux défis ?

Orange est un acteur clé dans la connectivité entre datacenters. En matière d’IA, nous répondons aux besoins croissants des hyperscalers (Amazon, Microsoft, Google, etc.), des neocloud providers (Coreweave, Nscale, Nebius, etc.) et des acteurs chinois comme Alibaba ou BytePlus, la filiale de ByteDance (TikTok), qui investissent massivement en Europe et en Afrique. Notre cœur de métier est le backbone international : transporter des données entre datacenters, avec une attention particulière sur la montée en débit et en matière de résilience des réseaux.

Notre cœur de métier est le backbone international : transporter des données entre datacenters, avec une attention particulière sur la montée en débit, la performance (latence) et en matière de résilience des réseaux

Quels sont les principaux défis techniques liés à l’IA ?

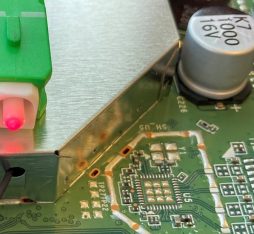

Pour le training, les besoins en bande passante sont colossaux, souvent compris entre 400 Gbps et 800 Gbps. Dans la pratique, les modèles d’IA nécessitent d’agréger des données dispersées dans plusieurs clusters. Nous travaillons avec des constructeurs comme Nokia, Ciena, ZTE ou Huawei pour déployer des capacités adaptées, notamment via la technologie WDM (Wavelength-Division Multiplexing). L’enjeu est de réduire les coûts et les latences, car chaque transfert de données entre datacenters a un impact direct sur l’efficacité des GPU lors de la phase d’entraînement des LLM.

Quelles innovations sont en cours pour l’inférence ?

L’inférence pose des défis différents. Nous collaborons avec Orange Innovation et OINIS pour anticiper les architectures futures, notamment via la possibilité d’utiliser un profil de service pour l’AI, comme proposé par Mplify, qui vise à standardiser la transmission de gros paquets de données (Jumbo Frames). Le challenge est de garantir une latence minimale ainsi qu’une disponibilité élevée. Par exemple, une requête principale qui est divisée en plusieurs sous-requêtes vers des agents AI ne doit pas être ralentie par le temps de traitement le plus long. En somme, si une requête principale est scindée en 10 parties, et que l’une prend 10 secondes, la réponse globale sera retardée d’autant. Notre mission est donc de fluidifier ces échanges.

Certains modèles chinois, open source et très performants, sont également plus frugaux (DeepSeek, Moonshot Kimi K2). Ils ont l’avantage de montrer que l’on peut concilier performance et sobriété.

Comment Orange se distingue-t-il face à la concurrence, notamment sur les marchés émergents comme l’Afrique ?

Sur le continent africain, nous misons sur des partenariats avec des constructeurs chinois et européens. L’objectif est de fournir des solutions adaptées aux contraintes locales, comme l’accès à une électricité abordable. En Afrique, le marché évolue vers la décentralisation. Grâce aux infrastructures Edge, l’inférence peut désormais se faire au plus près des besoins, ou depuis Marseille, qui centralise déjà les flux IP vers l’Afrique du Nord et de l’Ouest. Ce afin de réduire les coûts et la latence.

Comment anticipez-vous l’évolution des datacenters d’ici 2030 ?

D’ici à 2030, ce sont plus de 600 datacenters qui seront construits en Europe. L’enjeu majeur est d’avoir accès à une électricité bon marché et durable. Orange déploie des fibres avec des chemins de résilience pour relier ces infrastructures, et anticipe une croissance exponentielle de l’inférence. Aujourd’hui, 50% des workflows sur GPU sont déjà dédiés à l’inférence. On sait que cette proportion va augmenter. Les acteurs comme Mistral ou CoreWeave savent que les GPU dédiés au training deviennent rapidement obsolètes, et il est donc important pour ces Neoclouds de trouver une utilisation pour de l’inférence peu onéreuse avec des générations de GPU déclassées.

Quels sont les risques pour les opérateurs qui ne s’adaptent pas ?

Le risque est de ne pas suivre la cadence des innovations matérielles. Un GPU acheté aujourd’hui peut perdre 80% de sa valeur en 18 mois, avec l’arrivée de nouvelles générations qui sont 4 à 5 fois plus puissantes. Il faut donc investir dans des infrastructures capables d’évoluer rapidement. Orange, classé 10e mondial en visibilité réseau IP Transit selon Kentik, mise sur des solutions hybrides : Dark Fiber et WDM pour le training, ainsi que des produits comme l’Ethernet ou l’IP Transit pour l’inférence.

Sources :

AI infrastructure: A new growth avenue for telco operators (McKinsey) (en anglais)

Jamy Rousseau

Jamy Rousseau