- Décisions et connaissance

- Expériences dans la maison et l’entreprise

- IA

- Robotique

- Société numérique soutenable

En plus de permettre de se situer au cœur des enjeux éthiques de la robotique sociale, la santé mentale est l’un des rares domaines dans lequel cette technologie est effectivement déployée, les troubles du spectre autistique (TSA) et la maladie d’Alzheimer étant considérés comme les cas d’usages à la fois les plus répandus et les plus prometteurs [2], dans une même logique de recourir à la sociabilité artificielle pour lutter contre l’isolement des personnes.

Concernant les TSA, tout a commencé en Grande Bretagne à la fin des années 1990. La chercheuse en robotique sociale Kerstin Dauthenhan a fait l’hypothèse du robot comme “médiateur social”, capable d’augmenter les capacités d’engagement social des enfants [3]. Suite à ce projet fondateur, les recherches sur le recours aux robots sociaux pour accompagner les enfants avec un TSA se sont multipliées au niveau international [4], sans permettre une généralisation des résultats [5].

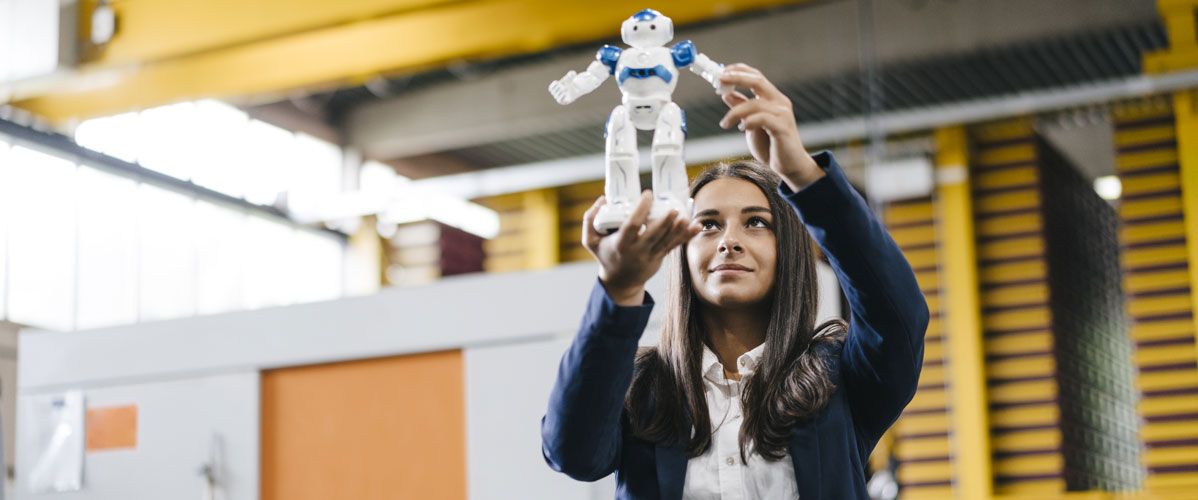

Actuellement, Nao est le robot faisant l’objet du plus grand nombre d’expérimentations en France. Il a été conçu en 2006 et commercialisé à partir de 2008 par une start-up française, Aldebaran Robotics, rachetée en 2015 par l’entreprise japonaise Softbank Robotics. Nao dispose de programmes de “ vie autonome” lui permettant d’interagir avec son environnement. Il est également programmable à l’aide de Chorégraphe, logiciel qui s’appuie sur le langage de codage Python.

Un membre du pôle innovation chez Softbank décrit ainsi la posture de Bruno Maisonnier à l’origine de la création de Nao : “Il a dit : je ne sais pas à quoi ça va servir, mais je fais une plateforme et les gens inventeront les usages avec. Et l’autisme, c’est le cas d’école où c’est arrivé ”. Des chercheurs du département de psychologie de Notre Dame dans l’Indiana ont inventé cet usage du robot et amené les concepteurs à élaborer en 2013 une suite logicielle dédiée, Ask Nao [Autism solution for kids], puis son interface tablette en 2015, Ask Nao Tablet, pour faciliter le guidage du robot qui se faisait jusqu’alors par la voix ou depuis l’ordinateur.

Cet article s’appuie sur une enquête concernant la conception de l’application Ask Nao et l’utilisation du robot Nao dans sept structures accueillant des enfants avec un TSA en France (hôpitaux de jour et instituts médico-éducatifs). Les professionnels de santé travaillent différemment avec Nao mais ils font tous l’hypothèse que ce robot peut attirer et motiver les enfants avec un TSA étant donné leur appétence pour les nouvelles technologies [6].

Nao : un compagnon décevant

Les équipes de recherche chez Softbank nourrissent l’ambition de produire des robots capables de reconnaître leurs interlocuteurs et de s’adapter à chacun. Un chercheur explique à propos de Pepper, autre robot humanoïde développé par l’entreprise : “Je pousse vraiment pour : qu’est-ce qui améliore le robot d’un point de vue interaction long terme avec l’humain ? […] Un des premiers blocages techniques, c’est que le robot puisse te reconnaître et, quand tu discutes avec le robot, que cette discussion aille générer quelque chose. Le lendemain, quand il te revoit, il se souvient de ce qui s’est dit, il y a un lien qui se crée.”

Quand ils rencontrent Nao, les professionnels de santé constatent plutôt un écart entre les aptitudes annoncées du robot, notamment par la communication de Softbank, et la réalité. Beaucoup dénoncent le “grand mensonge” ou encore la “ fumisterie” autour des capacités de Nao. Une pédopsychiatre découvre un compagnon très décevant : “Pour nous, ça été l’irruption du syndrome de la vérité, par rapport au fantasme Star Wars, ça été vraiment l’atterrissage brutal. En fait c’est extrêmement peu autonome, ça n’est pas du tout mûr ou mature tel que c’est présenté.”

Un enseignant spécialisé partage son rêve déçu de pouvoir construire une relation personnelle et durable avec Nao grâce à la mémorisation des interactions passées : “Si j’entre dans la classe comme je le fais chaque jour depuis huit ans, Nao il ne me dira jamais : ça boume T. ? Tu as l’air préoccupé. Non, il est là, bêtement. Il n’y a évidemment aucune improvisation. Nao, il ne crée rien du tout et il ne mémorise aucun détail ayant trait à la personne. ”

Les professionnels en centres de soin regrettent la faible autonomie du robot, sa bêtise interactionnelle. Tous présentent Nao comme n’étant pas abouti d’un point de vue technique, ce qui les amène à considérer que le robot ne relève pas du domaine de l’Intelligence Artificielle et à le qualifier plutôt de “marionnette”, de “voiture télécommandée” ou encore de “gros magnétophone”.

Il s’avère que les programmes de “vie autonome” peuvent difficilement être utilisés avec des enfants qui présentent un TSA. Nao est trop exigeant : il ne répond que si son interlocuteur se positionne bien en face de lui ; il comprend uniquement ce qui est prononcé correctement, etc. Le robot doit donc être programmé pour être utilisé dans les centres de soin. Dans un IME, un informaticien devenu “ chargé des projets innovants” estime que deux heures de programmation sont nécessaires pour faire une séance d’une quinzaine de minutes avec Nao.

Des débats publics hors de propos ?

Face à ces constats, plusieurs acteurs considèrent que certaines questions éthiques posées par les débats publics ne sont pas véritablement pertinentes au regard des compétences interactionnelles encore très limitées des robots sociaux.

Les rapports publiés par différentes institutions depuis cinq ans nous offrent un corpus homogène représentatif des discours sur “l’éthique de l’IA”. Ils ont en commun d’énoncer des recommandations à partir d’une réflexion plutôt prospective sans s’appuyer sur des enquêtes empiriques concernant l’état actuel des technologies.

Concernant les robots sociaux, ces rapports entendent alerter l’opinion, les communautés professionnelles et les pouvoirs publics sur deux types de risques : d’une part, un attachement inapproprié de l’humain à la machine susceptible de fragiliser le lien social ; d’autre part, une autonomisation démesurée de la machine assortie d’une perte de contrôle humain.

Ces discours peuvent sembler en décalage avec l’état actuel de la technologie. Un chercheur chez Softbank souligne par exemple l’écart entre la problématique de l’attachement et les limites de la reconnaissance faciale : “C’est vrai qu’on essaie de pas faire de bêtises, on essaie de ne pas être trop déconnecté de l’aspect social. Mais on a tellement de limites techniques à régler d’abord. Après on a fait des débats super intéressants avec plein de gens pendant des heures, mais de toute façon le robot ne reconnaît pas les humains.”

Des professionnels de santé partagent cet avis et tendent à déplacer certains enjeux éthiques, comme la question de l’empathie avec des êtres artificiels, vers ce qu’ils considèrent être de l’IA, champ dont ils excluent Nao. Une pédopsychiatre explique : “Pour l’instant, effectivement comme on le disait, c’est notre marionnette. […] si on est dans de l’intelligence artificielle avec un robot qui intervient, qui répond aux sentiments de l’enfant, qui réagit, etc., il faut qu’il y ait un questionnement éthique solide avant d’introduire des objets de ce type dans la prise en charge des jeunes.”

Retour à l’éthique ordinaire

Les limites techniques actuelles rendent-elles hors de propos les débats publics concernant l’éthique de la robotique sociale ? Est-ce à dire que la question de l’éthique ne doit pas encore être posée ? Qu’elle viendra en temps voulu, quand la technologie sera plus aboutie ?

Le constat des limitations actuelles de la robotique sociale invite plutôt à s’intéresser à l’éthique ordinaire, dans le déploiement concret de cette technologie. Comme le soulignent Danah Boyd et Madeleine Elish, “les réelles questions de l’éthique de l’IA sont ancrées dans le terre-à-terre plutôt que dans le spectaculaire” [7].

Qu’en est-il des préoccupations éthiques telles qu’elles émergent dans des expérimentations situées, dans le “ici et maintenant” de lieux de soin ? Dans quelle mesure l’enquête sociologique permet-elle de déplacer les termes de la controverse et d’identifier les “réelles questions” ?

On propose de focaliser l’attention sur la manière dont les enjeux qualifiés d’éthiques dans les rapports publics sont problématisés par ceux qui conçoivent et utilisent des robots sociaux. Il s’agit de s’intéresser à leur travail de moralisation, à la manière dont ils tentent de définir une juste place pour ces artefacts interactionnels.

La morale est ici entendue comme l’ensemble des règles qui régissent nos manières de vivre ensemble en société, et l’éthique comme une formalisation possible de la morale. On propose de s’intéresser à deux enjeux qui structurent fortement les débats : la relation susceptible de se nouer entre l’humain et le robot et la répartition souhaitable des tâches entre eux.

La confusion entre humain et non-humain

La fabrique de robots anthropomorphisés, dans lesquels sont transplantées des caractéristiques que nous attribuons spontanément aux humains, pose d’abord le problème de la confusion entre humain et robot. Dans les rapports publics, ce risque est considéré comme étant d’autant plus grand concernant les personnes vulnérables.

Cependant, la plupart des professionnels de santé estiment qu’il n’existe pas d’illusion possible sur l’absence d’autonomie de Nao. Dans un centre hospitalier, le cadre de santé et la pédopsychiatre tombent d’accord en mettant en avant l’intelligibilité du système de commande du robot (“les enfants ont très bien compris que c’était à partir de l’ordinateur”) et le manque de fluidité du mouvement (“il n’est ni assez fluide, ni assez humanoïde, pour qu’à un moment la confusion soit possible”).

Dans un autre endroit, un orthophoniste considère la confusion comme un stade initial qui “ne dure pas”, d’autant plus que le dispositif qu’il a conçu consiste à faire programmer Nao par les enfants, donc à leur mettre les ficelles entre les mains.

Néanmoins, les professionnels n’écartent pas de manière unanime le risque que les enfants assimilent le robot à l’humain. Une pédopsychiatre exprime davantage de doutes, et un certain malaise : “Parce que ce qui me gêne dans ce projet d’étude c’est l’idée que… Pas tous les enfants autistes, mais certains sont tellement dans leur monde, qu’entre l’humain et le robot, on sent qu’ils ne saisissent pas trop que le robot est… Qu’il n’est pas indépendant, qu’il ne parle pas tout seul. On sent que c’est compliqué des fois pour eux de percevoir ça. Et éthiquement, ça me questionne un peu.”

Quel que soit leur sentiment, tous les professionnels mettent en avant l’importance de ne pas cultiver la confusion, en élaborant des protocoles pour présenter le robot (le sortir et le ranger dans sa caisse devant les enfants) ou encore des normes langagières pour en parler (dire “il est rangé dans sa caisse” plutôt que “il fait dodo”). Ils expriment le souci d’éviter de prêter au robot un vécu émotionnel, voire sensoriel, similaire à celui d’un humain.

L’attachement

La volonté d’éviter la confusion entre humain et non-humain soulève un deuxième problème : celui de l’attachement. Les rapports publics présentent cet enjeu comme étant particulièrement critique chez les personnes fragiles, considérées comme plus susceptibles de succomber aux pièges anthropomorphiques.

Une psychomotricienne fait explicitement le lien entre la confusion et l’attachement en racontant le cas d’un enfant qui, après avoir fait beaucoup de “câlins” à Nao, s’est finalement “désintéressé” du robot quand il a compris que ce dernier était “piloté par la tablette”. Elle conclut : “Il ne voulait pas guider Nao, il voulait que Nao lui réponde : bonjour. Il voulait un partenaire.” L’absence de confusion pourrait ainsi régler le problème de l’attachement.

Pourtant, de manière intéressante, d’autres acteurs dissocient ces enjeux. Ils mettent en avant la possibilité qu’un enfant s’attache au robot sans pour autant l’assimiler à de l’humain. Une pédopsychiatre explique : “ D’abord, ils font quand même une très grande différence entre le robot et l’adulte qui est là, qui est le référent. Je veux dire, il n’y a pas de confusion. Je pense qu’il n’y a pas de question. Après, c’est un support de projection.”

Finalement, du point de vue des professionnels, le problème n’est pas tant d’empêcher l’attachement, ce sur quoi ils considèrent avoir peu de prise, mais plutôt d’éviter d’entretenir l’idée d’une réciprocité possible, notamment en prêtant au robot un fonctionnement affectif similaire à celui d’un humain. Un psychologue explique à propos de Pepper : “Il est vendu vraiment comme ayant un cœur, comme pouvant pleurer avec toi si tu es triste. Et ça, nous, on n’apprécie pas du tout. Ce n’est pas du tout éthique.”

La substitution

L’émergence d’une sociabilité artificielle pose également la question de la substitution possible des machines aux humains. Dans les rapports publics, cette possibilité est perçue comme étant d’autant plus problématique quand elle est envisagée dans le domaine des soins à la personne.

L’enquête de terrain montre que la notion de substitution recouvre en fait trois réalités différentes. Une première conception désigne ce qu’on peut appeler la substitution fonctionnelle : l’idée que certaines fonctions (comme l’éducation) pourraient être occupées par des robots, avec le risque à terme de la disparition de certains métiers (comme celui d’éducateur).

Cette crainte est anticipée par les concepteurs. Le chef du projet explique à propos d’Ask Nao : “On ne veut pas parler de thérapie entièrement par ordinateur. Ça n’intéresse pas, ce n’est pas vendeur, ça fait peur à tout le monde, ça néglige le rôle du thérapeute.” La peur de la substitution est également désamorcée par les professionnels qui n’établissent jamais le robot comme un dispositif auto-suffisant susceptible de fonctionner sans leur intervention. Un psychologue souligne : “Le robot, lui, il n’a rien de thérapeutique. C’est son usage qui va l’être.”

Une deuxième conception de la substitution désigne ce qu’on peut appeler la substitution économique : l’idée que l’investissement dans un robot (les ressources permettant de l’acquérir et de l’utiliser) relève d’une forme d’arbitrage qui présente le risque, d’autant plus dans un contexte de coupes budgétaires, d’induire un manque de moyens (par exemple de personnel) pour faire le “vrai boulot”, à savoir la thérapie et l’éducation.

Une troisième conception, plus radicale mais également moins répandue (de manière logique étant donné la désillusion vécue par les acteurs), désigne ce qu’on peut appeler la substitution ontologique : la possibilité que les robots remplacent les hommes non plus dans l’exercice d’une fonction donnée mais en tant qu’espèce, “l’idée que l’algorithme va devenir tellement intelligent qu’il va dépasser l’homme” selon les termes d’une chargée de projets à La Croix Rouge.

La prise de décision

L’essor de l’IA et de la robotisation soulève enfin la question de la prise de décision et de la responsabilité professionnelle : la capacité pour l’humain de “garder la main” (CNIL, 2017), de prendre la décision finale et de contrôler la machine.

En pratique, les acteurs font en sorte que la capacité décisionnelle du robot n’empiète pas sur le cœur de la compétence professionnelle, en l’occurrence la capacité à produire la dimension thérapeutique ou éducative d’une situation et la capacité à juger de l’action qui convient pour prendre soin d’un enfant.

Les professionnels de santé expriment la volonté de garder le contrôle sur l’évaluation des compétences de l’enfant, dont ils estiment qu’elle ne peut pas être déléguée au robot, que ce soit dans l’absolu ou dans l’état actuel de la technologie. À propos d’un programme pour travailler l’imitation avec Nao, ils invoquent les deux logiques : il revient au soignant de juger si l’enfant a eu le comportement attendu car le robot ne peut pas le faire correctement, mais également car “le jugement appartient au soignant”, seul capable d’estimer ce qui peut être attendu d’un enfant, selon le contexte et ses capacités.

Les chercheurs chez Softbank ont bien identifié l’importance de laisser la main aux professionnels sur l’évaluation. Ils se sont d’ailleurs appuyés sur ce constat pour concevoir l’interface tablette d’Ask Nao : “L’idée était de donner la main au thérapeute pour qu’il puisse dire que c’est pas mal. On lui a redonné un peu plus de contrôle.”

Ainsi, concernant Nao, la question n’est pas tant celle de la délégation de la responsabilité du praticien vers le robot, mais plutôt celle d’une responsabilité accrue des praticiens dans le maniement du robot comme outil thérapeutique, par l’évaluation des risques associés.

Conclusion : un acteur social pas comme les autres

Cette enquête permet donc, en se déplaçant de fonctionnalités fantasmées vers des situations d’usages concrètes, d’identifier les enjeux éthiques au cœur du déploiement effectif de la robotique sociale.

Elle éclaire la réticence à établir les robots comme des acteurs sociaux dotés d’une compétence morale leur permettant de sanctionner (positivement ou négativement) nos manières de nous comporter. En effet, les acteurs tendent à considérer que l’attrait du robot, quand il s’agit d’en faire un interlocuteur, se situe précisément dans une certaine incompétence sociale, dans son incapacité à s’ériger en juge de nos actions. Beaucoup d’entre eux mettent en avant le fait que Nao “ne juge pas”.

Les professionnels travaillent constamment, par leurs réflexions et en pratiques, à établir le robot comme un acteur social pas comme les autres et à élaborer la spécificité de sa place. Et l’on peut faire l’hypothèse que cette observation est généralisable aux autres “agents artificiels intelligents”, agents virtuels animés et agents conversationnels [8].

Cette enquête vient ainsi nourrir le positionnement d’Orange en lui permettant d’identifier certains points de vigilance et d’orienter au mieux ses choix technologiques pour être en phase avec les usages émergents des agents artificiels intelligents.

Rapports publics sur les enjeux éthiques de l’IA et de la robotique (liste non exhaustive)

Novembre 2014 : Avis de la CERNA (Commission de réflexion sur l’éthique de la recherche en sciences et technologies du numérique) – Éthique de la recherche en robotique

Décembre 2016 : Rapport de l’IEEE (Institute of Electrical and Electronics Engineers) – Ethically aligned design. A Vision for Prioritizing Human Wellbeing with Artificial Intelligence and Autonomous Systems

Janvier 2017 : Rapport Delvaux à la Commission européenne – Rapport contenant des recommandations concernant des règles de droit civil sur la robotique

Mars 2017 : Rapport de l’OPECST (Office parlementaire d’évaluation des choix scientifiques et technologiques) – Pour une intelligence artificielle maîtrisée, utile et démystifiée

Décembre 2017 : Rapport de la CNIL (Commission nationale de l’informatique et des libertés) – Comment permettre à l’homme de garder la main ? Les enjeux éthiques des algorithmes et de l’IA

Janvier 2018 : Livre Blanc du CNOM (Conseil national de l’Ordre des médecins) – Médecins et patients dans le monde des data, des algorithmes et de l’intelligence artificielle. Analyses et recommandations

Mars 2018 : Rapport Villani au gouvernement – Donner un sens à l’intelligence artificielle : pour une stratégie nationale et européenne

Novembre 2018 : Rapport du CCNE (Comité consultatif national d’éthique) avec le concours de la CERNA – Numérique et Santé : quels enjeux éthiques pour quelles régulations ?

Références

[1] Turkle, S., 2015 [2011], Seuls ensemble. De plus en plus de technologies. De moins en moins de relations humaines, L’Échappée, Paris.

[2] Costescu, C., Vanderborght, B., David, D., 2014, “The effects of robot-enhanced psychotherapy: A meta-analysis”, Review of General Psychology, vol. 18, n° 2, p. 127-136.

[3] Dauthenhan, K., 2007, “Encouraging social interaction skills in children with autism playing with robots. A case study evaluation of triadic interactions involving children with autism, other people (peers and adults) and a robotic toy”, Enfance, vol. 59, n° 1, p. 72-81.

[4] Cabibihan, J., Javed, H., Ang, M., Aljunied, S., 2013, “Why robots? A survey on the roles and benefits of social robots for the therapy of children with autism”, International Journal of Social Robotics, vol. 5, n° 4, p. 593-618.

[5] Baddoura, R., 2017, “Le robot social médiateur : un outil thérapeutique prometteur encore à explorer”, Le journal des psychologues, n° 350, p. 33-37.

[6] Grossard, C., Grynszpan, O., 2015, “Entraînement des compétences assistées par les technologies numériques dans l’autisme : une revue”, Enfance, vol. 1, n° 1, p. 67-85.

[7] Boyd, D., Elish, M., 2018, “Don’t believe every AI you see (Blog post)”, New America, https://www.newamerica.org/public-interest-technology/blog/dont-believe-every-ai-you-see/

[8] Borelle C., 2018, “Sortir du débat ontologique. Éléments pour une sociologie pragmatique des interactions entre humains et agents artificiels intelligents”, Réseaux, vol. 36, n° 212, p. 206-231.

Pour aller plus loin

- Borelle Céline, “La moralisation des robots sociaux par leurs utilisateurs”, Sociologie du travail, à paraître en 2020.

- Borelle Céline, À quoi les robots sociaux peuvent-ils servir ? Éléments sur la conception et les usages de robots sociaux dans le domaine de la santé mentale, Rapport interne, Orange labs, 2019.

- Borelle Céline, Velkovska Julia, Zouinar Moustafa, Personnalité, émotions et anthropomorphisme dans la conception et les usages des agents “intelligents”, Rapport interne, Orange labs, 2018.

• https://www.fondationorange.com/Autisme-et-numerique-quel-bilan-5-ans-apres?