Résumé

En 2009, un think tank piloté par Orange Business Services imaginait de futurs services dans le domaine du cloud alors naissant. Dix ans plus tard, alors que le cloud computing s’est hissé au rang de pilier de l’économie, les six axes de développement évoqués alors par Orange se sont pour l’essentiel confirmés. Côté grand public, le cloud personnel, dont fait partie désormais le cloud mobile, est désormais présent dans nos vies quotidiennes via la vidéo en streaming, les réseaux sociaux, les assistants personnels, les messageries ou le stockage de fichiers. Côté entreprises, au-delà du Software as a Service (Saas), le cloud vertical concerne la quasi-totalité des secteurs de l’économie. Le cloud open source, quant à lui, occupe aujourd’hui une position centrale dans toutes les couches du cloud. Le cloud total a pour sa part trouvé sa traduction à travers le Fog Computing offrant un continuum du cloud jusqu’aux objets. Pour l’heure, seul l’intercloud, forme interconnectée du cloud, n’a pas vu le jour même si le marché s’oriente dans cette direction avec le cloud hybride (interconnexion clouds publics et privés) et le multi-cloud (interconnexion de plusieurs clouds).

Article complet

“Il est très difficile de faire des prédictions, en particulier lorsqu’elles concernent l’avenir” Niels Bohr

2009 a été une année charnière pour le groupe Orange pour la construction de sa posture stratégique sur le cloud computing. Ce positionnement incluait une prévision des évolutions futures du cloud computing. Dix ans plus tard, nous proposons, avec cet article, de reconsidérer les 6 visions de l’avenir du cloud computing qui avaient été formulées en 2009. Nous voyons que 4 d’entre elles sont devenues réalité en 2019, notamment le cloud open source ainsi que le fog/edge computing, et que la “softwarisation” des réseaux – une thématique majeure aujourd’hui – avait été quelque peu sous-estimée.

Après des travaux de recherche précurseurs sur la virtualisation des serveurs, du stockage et du réseau menés dans les années précédentes, l’année 2009 pourrait bien être considérée comme “l’année zéro du cloud computing” chez Orange. Un “think tank” piloté par Orange Business Services regroupant des experts issus de différentes entités du groupe Orange comme la recherche et développement, avec notamment divers laboratoires internationaux, les systèmes d’information, le marketing stratégique, les services, ainsi que les opérations de réseau et de plates-formes, a été constitué de manière à aider Orange à construire une stratégie et des futurs services dans le domaine du cloud alors émergeant, dont l’importance stratégique avait été dûment identifiée. Les activités de ce think tank, qui a fonctionné pendant plusieurs mois, étaient organisées en différents chantiers chargés de procéder à des évaluations technologiques, des études de marché, d’élaborer des scénarios stratégiques, des offres potentielles, une stratégie de communication, une stratégie de partenariats et de traiter des impacts organisationels — pour n’en citer que quelques-uns.

L’un de ces chantiers, piloté par la recherche d’Orange (plus précisément et plus modestement par l’auteur de ce billet :-)) a travaillé sur l’élaboration d’une vision de l’avenir du cloud computing. Dix ans plus tard, alors que la technologie du cloud computing et le marché ont mûri et que le cloud computing s’est hissé au rang de pilier de l’économie (numérique) moderne dans de nombreux domaines, dont les télécommunications, il est intéressant (voire divertissant !) de “jeter un œil dans le rétroviseur” et de comparer les évolutions qui se sont réellement produites avec celles imaginées par Orange en 2009. C’est précisément l’objet de ce billet !

Retour sur la vision d’Orange en 2009 sur l’avenir du cloud computing

La description de la vision de cet avenir débutait par un préambule basé sur un communiqué de Gartner daté de juillet 2009 qui mérite d’être cité une nouvelle fois : “Les offres [de Cloud Computing] sont extrêmement embryonnaires et beaucoup n’en sont qu’au stade du développement. De nombreux fournisseurs que Gartner a interrogés n’ont pas fini d’élaborer leurs stratégies de mise sur leur marché, leurs grilles tarifaires ni, plus important encore, leurs contrats de niveaux de service”.

La vision elle-même, synthétisée dans un schéma, s’articulait autour de six axes. Ces six directions n’étaient pas forcément indépendantes les unes des autres ; certaines étaient davantage orientées vers la technologie, d’autres plus tournées vers les usages/le marché, d’autres encore se chevauchaient en partie – mais toutes étaient perçues comme donnant une vision exploitable des avenirs possibles du cloud computing dans le but d’en tirer une analyse stratégique.

Les clouds verticaux (“vertical cloud”) faisaient référence au cloud computing appliqués à des domaines d’applications spécifiques. Il s’agissait essentiellement d’offres de type Software-as-a-Service (SaaS) dans des domaines particuliers tels que le Cloud Gaming pour les jeux en ligne, où même dans le cas de jeux à un seul joueur ; il devenait possible de jouer à des jeux “streamés” depuis des serveurs dans le cloud, au lieu de devoir acheter ou télécharger ces jeux sur sa console. Parmi les autres domaines d’applications mentionnés figuraient, outre les logiciels d’entreprise (par ex. de type CRM), le cloud pour les services publics, le cloud pour les services de santé, le cloud pour des services en temps réel[1] (e.g. visioconférence), le Machine-to-Machine (M2M), etc. Parmi les premiers signes de cette tendance figuraient Flix Cloud, une offre d’encodage proposée par la start-up On2 (ultérieurement rachetée puis “tuée” par Google) qui était hébergée sur le cloud d’Amazon, Onlive qui proposait des jeux en ligne dans le cloud (l’entreprise a fermé son service de jeux en 2015 et propose dorénavant des applications de bureautique en streaming sur PC), et les premiers clouds de santé destinés au stockage et au partage sécurisés des dossiers médicaux. La probabilité des clouds verticaux était estimée comme “très élevée” et son calendrier de mise en œuvre débutant à partir de 2009.

Le cloud mobile (“mobile cloud”) concernait essentiellement l’accès au cloud à partir de terminaux tels que les smartphones (souvenez-vous que les tablettes n’en étaient alors qu’à leurs balbutiements !). Cette vision incluait également l’ “offloading” du stockage et/ou des calculs du terminal vers le cloud[2], ainsi que la gestion des déconnexions transitoires des terminaux. À ce moment-là, on tablait sur le fait que les terminaux mobiles allaient devenir le premier choix pour l’accès à Internet à l’avenir. Les services en ligne mobiles devaient supplanter le téléchargement des applications. Cette tendance aurait fait le jeu des téléphones de moyenne et d’entrée de gamme qui n’auraient pas eu la puissance de calcul, ni la capacité de traitement ou la batterie des smartphones. En effet, on pensait alors que les téléphones compatibles avec le cloud seraient l’antithèse des smartphones en termes de développement durable, avec des besoins moindres au niveau des batteries, une durée d’existence plus longue et une meilleure adaptation aux besoins des marchés émergents. De plus, les développeurs de logiciels mobiles développeraient moins de versions pour le cloud que pour la multitude de plates-formes de téléphones mobiles différents comme aujourd’hui. La probabilité du cloud mobile était estimée “très élevée” et le calendrier de mise en œuvre du remplacement des téléchargements d’applications par des applications disponibles sur le Web avait été estimé entre 2013 et 2018.

Le cloud ouvert (“open cloud”) faisait référence à la technologie cloud reposant sur des standards et des solutions “open source” tels que la virtualisation des serveurs (hyperviseurs) et les systèmes de gestion du cloud (“cloud management systems”). Le cloud ouvert ciblait la portabilité des applications et l’interopérabilité des infrastructures sur la base d’interfaces de programmation d’application (API) standardisées et d’intergiciels mis à disposition en open source. Le pari était le suivant : à long terme, l’open source viendrait concurrencer, voire dépasser les solutions propriétaires, tant du point de vue technologique qu’en termes de parts de marché – comme on l’avait auparavant observé dans des domaines liés au cloud computing tels que les systèmes d’exploitation (e.g. Linux est, de loin, le système d’exploitation le plus utilisé dans les centres de données). Trois tendances avaient été considérées comme alimentant cette vision d’un cloud ouvert : certaines des grandes plates-formes cloud (par ex. Amazon) reposaient déjà sur l’open source ; des projets open source tels que OpenNebula ou Eucalyptus avaient fait leur apparition ; enfin, un mouvement en faveur de la standardisation avait été initié en 2009 au sein des organismes en charge de normalisation, à l’instar du Distributed Management Task Force (DMTF) ou de l’OGF (Open Grid Forum). La probabilité du cloud vertical était estimée comme “élevée” car, si l’open source se développait, on avait pu observer également que de grands prestataires du cloud (par ex. Amazon, Google, SalesForce, Microsoft) et des fournisseurs de technologies (par ex. VMWare) s’étaient montrés réticents vis-à-vis de ces normes dont ils pensaient qu’elles pouvaient ralentir le développement et l’adoption de la technologie du cloud, et qu’ils pressentaient comme de possibles menaces pour leurs parts de marché. Le calendrier alors envisagé tablait sur 2011-2012 pour le lancement de solutions open source vouées à concurrencer les solutions propriétaires. La normalisation devait parvenir à maturité d’ici 2015.

L’intercloud imaginait l’Internet du futur comme un marché en ligne de ressources et de services sur lequel des intermédiaires (des “brokers”) — un type d’acteurs d’un genre radicalement nouveau après les fournisseurs de technologie cloud (par ex. VMware) et les prestataires de services cloud (par ex. Amazon) — aideraient les consommateurs à choisir leur(s) prestataire(s) cloud le(s) mieux adapté(s) à leurs besoins à partir d’un ensemble de paramètres de sélection tels que contrats de niveau de service, qualité de service, disponibilité, fiabilité, sécurité, coût, respect de l’environnement (consommation d’énergie, émissions de CO2), localisation des utilisateurs, couverture des fonctions du domaine de l’entreprise, etc [3]. Cette vision englobait également le débordement de cloud (“cloud bursting”) (à savoir un cloud, généralement privé, à même de faire un usage ponctuel des ressources d’un autre cloud, généralement public, en cas de surcharge) et des clouds hybrides (à savoir une architecture dans laquelle plusieurs clouds, généralement un cloud privé et un ou plusieurs clouds publics, sont utilisés conjointement pour différentes sections du système global ou en cas de surcharge) pensés comme des étapes intermédiaires avant de s’acheminer vers la vision complète de l’intercloud que l’on pourrait concevoir comme le stade ultime et pleinement mature du cloud computing du point de vue commercial. La probabilité de l’intercloud était estimée “élevée”. La gestion multi‐cloud a fait son apparition en 2009 et devait arriver à maturité en 2016. Des marchés en ligne complets proposant des services à valeur ajoutée devaient faire leur apparition à partir de 2014 et devaient gagner en maturité jusqu’en 2020.

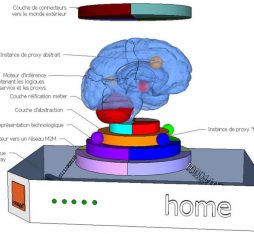

Le cloud total (“total cloud”) faisait le pari d’exploiter les ressources en bordure de réseau (“network edge”) afin de complémenter l’activité des centres de données. Ces ressources périphériques, soit des routeurs améliorés pour le stockage dans le réseau, soit des ressources côté consommateurs (appareils domestiques, terminaux mobiles, PC d’entreprise) pourraient apporter des capacités de stockage, une puissance de traitement et une bande passante qui viendraient en renfort de la capacité des centres de données. Cette vision englobait des clouds communautaires/collaboratifs, ou bien des clouds en bordure (“edge cloud”), qui seraient uniquement bâtis sur des ressources périphériques[4]. Les clouds en bordure exploiteraient les ressources des consommateurs, mais également les ressources du réseau présentes à l’intérieur du réseau d’accès et du réseau cœur. Cette vision supposait, par exemple, une convergence entre le cloud computing et les réseaux de distribtion de contenus (Content Delivery Networks (CDN) au sein de réseaux de distribution d’applications cloud (lesquels, techniquement parlant, auraient ressemblé à des “CDN virtualisés”) où données et contenus seraient non seulement stockés, mais aussi traités pour délivrer des applications aux utilisateurs. La probabilité du cloud total était jugée “moyenne” en raison de la crainte de difficultés au niveau technologique, réglementaire et de marché. Le calendrier de mise en œuvre reposait sur l’émergence de la fibre jusqu’au domicile (FTTH) et de la virtualisation des terminaux comme autant de catalyseurs technologiques clés, dont le décollage était attendu entre 2010 et 2015, et par ailleurs de la virtualisation complète des réseaux qui faisait son apparition dans les travaux de recherche[5]. Au final, le cloud total et son corollaire, le cloud en bordure, devaient arriver à maturité entre 2017 et 2020.

“Peu m’importe que mon architecture de cloud computing soit alimentée par une grille, un mainframe, l’ordinateur de mon voisin ou une armée de singes, à condition qu’elle soit rapide, pas chère et sûre” S. Johnston, septembre 2008

Le cloud personnel s’appuyait sur une vision du cloud computing centrée sur l’utilisateur dans laquelle tous ses contenus personnels et ses services seraient disponibles partout et tout le temps, c’est-à-dire sur et à partir de tous ses appareils personnels. Cette vision englobe les usages multiples d’un même terminal, à savoir l’accès à une multitude de services cloud à partir d’un seul et même terminal dans différents contextes, notamment personnel et professionnel – voire dans des contextes plus collectifs comme l’utilisation partagée de terminaux en service dans certains pays émergents (le “terminal du village”). Le cloud personnel recoupait davantage une vision des usages du cloud qu’une vision technologique. Sur le plan technologique justement, il était destiné à être construit sur un cloud mobile (omniprésence d’accès), en partie sur l’intercloud, et éventuellement sur le cloud total (omniprésence des ressources). Plusieurs tendances ont été considérées comme illustrant l’émergence du cloud personnel : services de sauvegarde en ligne pour PC qui faisaient alors leur apparition du type Dropbox, Mozy (depuis repris par Dell EMC) ; technologies de synchronisation telles que Apple MobileMe (remplacé par iCloud en 2011) ou Microsoft LiveMesh (qui sera remplacé par Microsoft SkyDrive) ; virtualisation du poste de travail (par ex. Citrix XenApp, Parallel VDI ou VMWare VDI) avec exécution de toutes les applications dans le cloud et où, fondamentalement, seule l’interface utilisateur se trouve sur le terminal. La probabilité du cloud était jugée “très élevée” et le calendrier de mise en œuvre pour des services à maturité était estimé entre 2014 et 2020.

Vérification des faits : quid en 2019 de la vision de 2009 sur l’avenir du cloud ?

Le cloud computing qui, en 2009, en était encore à ses balbutiements, pour ne pas dire un “buzzword”, a considérablement évolué depuis. La technologie a rapidement gagné en maturité. Le marché a connu et connaît encore une croissance explosive : “Le [seul] marché des services de cloud public à travers le monde devrait croître de 17,5 % en 2019 pour atteindre un total de 214,3 milliards USD, contre 182,4 milliards USD en 2018, selon Gartner, Inc.”. “Le marché mondial des services de cloud enregistrera 555 milliards USD de chiffre d’affaires d’ici 2020”. Ces chiffres sont à comparer au marché du cloud estimé à 24,65 milliards USD en 2010. D’autres statistiques indiquent que d’ici fin 2020, 67 % des infrastructures d’entreprise seront basées sur le cloud et que 83 % de la charge de travail reposera sur le cloud. Le cloud computing est devenu un marché florissant et une pierre angulaire de l’économie numérique ainsi que de nombreux secteurs de l’économie dite “traditionnelle”… c’est un fait admis, mais son développement a-t-il pris les orientations qu’Orange avait imaginées en 2009 ? C’est ce que nous allons examiner.

Côté marché grand public (B2C), le cloud personnel s’est si bien développé qu’il fait désormais véritablement partie de nos vies quotidiennes — même si on n’y fait pas explicitement référence par ce terme. Une grande parties des services Internet les plus connus que nous utilisons tous les jours sont rendus possibles, “en coulisses”, par le cloud computing : vidéo en streaming (Netflix), réseaux sociaux (Facebook, LinkedIn, Instagram), agents conversationnels (Apple Siri, Amazon Alexa, Google Assistant, Orange Djingo) ou, plus simplement, messagerie électronique et stockage de fichiers (Dropbox, Google Drive, Microsoft oneDrive, Apple iCloud, Le Cloud d’Orange[6]). Selon Eurostat, les services de messagerie électronique et le stockage de fichiers sont les principaux usages du cloud computing dans l’Union européenne. Facebook et LinkedIn sont également connus pour être très actifs dans la conception matérielle des infrastructures des centres de données (par ex. par le biais de l’Open Compute Project et d’Open19 Technology) — un signe manifeste que les centres de données et la gestion dans le cloud revêtent, à leurs yeux, une importance capitale. La plupart des services en ligne basés sur le cloud qui sont actuellement disponibles offrent aux utilisateurs une expérience d’abord mobile et, plus généralement, une expérience multi‑terminal, avec synchronisation des contenus entre plusieurs terminaux (smartphones, tablettes, PC, etc.) grâce au cloud. D’une certaine façon, le cloud mobile a été comme absorbé par le cloud personnel dont il est naturellement devenu une composante. Notre vision de 2009 accordait-elle peut-être une trop grande importance à distinguer le cloud mobile du cloud personnel ? Il faut alors se souvenir que les smartphones faisaient tout juste leur apparition, sans parler des tablettes, des consoles de jeu connectées, des montres (“smartwatches”) et autres objets connectés !

Côté marché entreprises (B2B), aucun doute possible : la vision du cloud vertical est devenue réalité. Au-delà des offres pures de type Software as a Service (Saas) qui délivrent des services génériques de gestion d’entreprise (par ex. gestion de la relation client, gestion des RH, facturation, etc.), un grand nombre, pour ne pas dire la totalité, des secteurs de l’économie sont en pleine mutation, et ce grâce à des services de cloud computing verticaux spécialisés — y compris ceux identifiés dans notre vision de 2009 (jeux, M2M/Internet des objets, santé, gouvernement). Selon IDC, “les trois secteurs qui prévoient [prévoyaient en 2018] de consacrer le budget de dépenses le plus important aux services de cloud computing étaient le secteur manufacturier (19,7 milliards USD), les services professionnels (18,1 milliards USD) et le secteur bancaire (16,7 milliards USD)”. Nous citerons ainsi l’exemple de Volkswagen et d’Amazon Web Services (AWS) qui, en avril 2019, ont annoncé leur signature d’un contrat pluriannuel portant sur le développement conjoint du “cloud industriel de Volkswagen qui réinventera ses processus de fabrication et de logistique”. Et le secteur public n’est pas en reste. Quantité de villes, régions et autres pays voient le cloud comme un levier central de leurs efforts d’optimisation et de modernisation. “Le gouvernement américain est probablement le plus important “client” du cloud. 48 % des agences fédérales et d’État aux États-Unis utilisent de nombreux services basés sur le cloud”, selon Number8. La quasi-totalité des plates-formes qui émergent dans l’Internet des objets (IoT) et les services Smart* (domotique/villes connectées/agriculture intelligente…) reposent aujourd’hui sur le cloud. Ce constat est vrai pour Amazon AWS IoT, Microsoft Azure IoT, Google IoT et Orange dont les plates-formes et services IoT Datavenue (par ex. Live Objects) fonctionnent sur les plates-formes d’Orange Cloud for Business.

Le cloud open source est une frappante incarnation de la vision du cloud ouvert de 2009. En effet, la technologie cloud open source a mûri et s’est développée — selon un processus, en quelque sorte, darwinien comme souvent — avant d’occuper une position centrale dans toutes les couches du cloud : matériel pour centres de données en open source avec l’Open Compute Project et Open19 Technology à l’initiative de Facebook et LinkedIn comme évoqué plus haut, virtualisation des serveurs avec les hyperviseurs KVM et Xen et, plus récemment, les systèmes de gestion de conteneurs Docker et Kubernetes, couche de gestion du cloud en mode IaaS avec l’omniprésence d’Openstack, de plates-formes PaaS comme Red Hat OpenShift ou CloudFoundry avec le soutien de Google, IBM, Microsoft, d’intergiciels (MySQL, PostgreSQL) et de langages de programmation. De nombreux clouds privés et clouds publics sont construits en open source. Comme cela avait déjà été indiqué en 2009, les technologies de cloud propriétaires, comme Amazon AWS ou Google Cloud, sont elles-mêmes basées sur un grand nombre de composantes en open source. Même VMWare et Microsoft, qui faisaient autrefois figure d’archétypes parmi les acteurs de technologies exclusivement propriétaires, apportent leur contribution à la technologie du cloud en open source (par ex. avec CloudFoundry et le projet Olympus respectivement) ! Après la première vague d’offres de cloud basées sur la technologie propriétaire de VMWare, Orange a adopté le cloud en open source avec le déploiement d’Openstack, premièrement dans son offre de cloud souverain Cloudwatt, puis dans son offre de cloud public Flexible Engine. Orange contribue également à la base du code d’Openstack (les premières contributions ont été initiées par la recherche d’Orange). Aujourd’hui, si certaines solutions open source telles qu’Openstack, Kubernetes ou OpenShift peuvent être considérées comme des standards “de fait”, les normes “de plein droit” concoctées par les organismes en charge de normalisation n’ont quasiment pas été adoptées à ce jour.

L’intercloud apparaissait comme le stade ultime d’un marché du cloud mature, dans lequel la plupart, voire la totalité, des infrastructures, plates-formes et services cloud seraient interconnectés et où de nouveaux acteurs joueraient le nouveau rôle d’intermédiaires du cloud — avec éventuellement une “ubérisation” du marché car ces intermédiaires n’auraient même pas besoin de détenir ou d’exploiter les ressources cloud… Nous observons que le marché du cloud computing n’a à ce jour pas atteint ce stade. Nous remarquerons toutefois en parallèle que le marché s’oriente en fait dans cette direction avec la montée en puissance actuelle du cloud hybride (interconnexion entre clouds publics et privés) et, plus généralement, du multi-cloud (interconnexion de plusieurs clouds d’une façon générale). En 2017, 451 Research a prédit que “69 % des entreprises disposeront d’un multi-cloud ou d’environnements informatiques en mode cloud hybride d’ici 2019”. Tackspace indique qu’un rapport sur l’état du cloud en 2019 montre que les entreprises adoptent de plus en plus une stratégie multi-cloud. 84 % des entreprises interrogées décrivent leur infrastructure informatique comme un “multi-cloud”. Orange Business Services précise “qu’en moyenne, les entreprises font appel à cinq fournisseurs de cloud différents, 81 % d’entre elles opèrent dans un environnement multi-cloud”. Cette tendance contribue clairement à façonner la stratégie de nombreux acteurs du cloud, dont Orange : “pour accompagner ces entreprises dans la gestion de cette diversité, Orange Business Services a décidé d’être agnostique dans son choix de technologies cloud. Cela place Orange dans un rôle d’intégrateur à même d’orchestrer et d’exploiter des applications diverses, critiques ou pas, dans un environnement multi-cloud de bout en bout, qu’il s’agisse de cloud public ou privé”. À long terme, la question se pose encore de savoir si la vision de l’intercloud de 2009 était simplement trop audacieuse et qu’elle ne se concrétisera jamais[7] ou si elle était juste prématurée. Ce qui est sûr, en revanche, aujourd’hui, c’est que nous observons des signaux de sa possible émergence.

Avec l’intercloud, le cloud total correspondait probablement à la vision la plus disruptive et représentait le pari le plus audacieux en 2009, à une époque où la vision communément partagée était, à l’inverse, celle d’une centralisation accrue du cloud computing dans des centres de données toujours plus démesurés ! Outre la synchronisation des terminaux cloud dans le cloud personnel et, plus récemment, l’émergence sur le marché des clouds hybrides et du multi-cloud, qui se rapportent davantage à une vision du cloud plus distribuée, il n’y avait que très peu de signes de l’émergence du cloud total avant l’avènement récent — mais massif (!) — du Fog Computing et du Edge Computing ces dernières années. Bien qu’étroitement liés, le fog computing et le edge computing ne sont pas la même chose. Si le edge computing se concentre uniquement sur les ressources en bordure du réseau (à l’exclusion du centre de données, par opposition au cloud computing d’une certaine manière), le fog computing s’intéresse davantage au “continuum du cloud jusqu’aux objets”, comme l’a spécifié l’Open Fog Consortium (donc, sur n’importe quelle ressource susceptible d’être exploitée dans le cloud, sur les terminaux finaux et les objets connectés eux-mêmes, mais également sur n’importe quel équipement intermédiaire, comme un smartphone, un PC, un portail ou un autre équipement de réseau). De ce point de vue, le fog computing est plus proche de la vision du cloud total de 2009. Peu importe la terminologie, la montée en puissance du fog computing et du edge computing est l’incarnation manifeste de la vision du cloud total qui redessine fortement l’écosystème du cloud. PR Newswire précise que “le marché mondial du edge computing devrait atteindre 6,72 milliards USD d’ici 2022, avec un taux de croissance annuelle cumulée considérable de 35,4 %”. Le fog/edge computing est essentiellement alimenté par l’Internet des objets et les Smart* Applications (domotique/bâtiments/villes/industries/agriculture/voiture intelligents…), qui présentent tous la caractéristique commune d’être des systèmes cyber-physiques, à savoir qu’ils ont la particularité d’être tous connectés à des objets physiques appartenant au monde réel. “Gartner prévoit que le nombre de terminaux IoT va grimper en flèche, pour atteindre un total de 50 milliards d’ici 2020, contre 20 milliards. Cette demande va également stimuler le besoin du edge computing”.

Le mot de la fin

Sur les 6 visions de l’avenir du cloud computing dessinées par Orange en 2009, on peut considérer que 4 sont, dix ans plus tard, devenues réalité (cloud vertical, cloud personnel, cloud mobile et cloud ouvert) avec, cependant certaines limitions. Le cloud mobile n’est pas devenu un phénomène à part entière. Il a davantage été absorbé à la faveur d’autres évolutions, notamment le cloud personnel (qui n’est pas connu sous ce terme). Le cloud open source est une réalité industrielle, mais la normalisation du cloud n’a pas pris son envol. Quant aux deux autres visions (cloud total et intercloud), elles sont en bonne voie — même si des questions demeurent quant au stade ultime qu’elles atteindront.

Dans l’ensemble, nos prédictions se sont révélées plutôt réalistes… mais sommes-nous passés à côté de quelque chose ? Plutôt, oui, et aussi drôle que cela puisse paraître pour un opérateur de services de télécommunications — même si nous avions, en 2009, des signes et quelques travaux de recherche sur la virtualisation des réseaux qui figuraient dans la définition de certaines de nos six visions — nous avons peut-être sous-estimé le poids de la “softwarisation” et de la “cloudification” des réseaux de télécommunication (“software defined network”, virtualisation des fonctions réseau (“Network Function Virtualization – NFV”), “telco cloud”), qui auraient bien mérité de faire l’objet d’une vision à part entière !

Une évolution massive de la technologie et du marché vers le fog et l’edge computing est en train de se produire, sous nos yeux. Certains la qualifient de “nouvelle révolution” du cloud computing alimentée par une autre “révolution”, celle de l’Internet des objets. Le “edge computing” s’est, par exemple, imposé de façon directe et manifeste dans le Hype Cycle for Emerging Technologies de Gartner en 2017, la courbe qui décrit l’évolution de l’intérêt pour une nouvelle technologie. Orange n’est pas en reste et mène actuellement une réflexion au niveau technologique, commercial et stratégique sur le fog computing et le edge computing, dans une démarche comparable à celle conduite par le Groupe en 2009 sur le cloud computing. La recherche d’Orange apporte sa pierre à l’édifice et fait progresser le edge computing en proposant et en expérimentant une vision de l’intelligence ambiante qui mêle intelligence artificielle, Internet des objets et connectivité ambiante grâce à l’informatique ambiante, une infrastructure cloud distribuée en périphérie extrême, tout autour de nous dans l’environnement physique, avec l’aide de “nano‑ordinateurs/capteurs/actuateurs” qui seraient dispersés dans notre environnement. Rendez-vous dans dix ans pour discuter de ce qu’il sera advenu de cette vision !

[1] Une démonstration intitulée “Les plates-formes conversationnelles vont vers le cloud !” a été présentée au salon de la recherche d’Orange en 2010.

[2] Une démonstration intitulée “MobiCloud : étendre de manière virtuelle les capacités des terminaux grâce au cloud” a été présentée au salon de la recherche d’Orange en 2011.

[3] Une démonstration intitulée “Un seul cloud ne suffit pas !” a été présentée au salon de la recherche d’Orange en 2010. Deux démonstrations intitulées “Gestion des applications dans le multi-cloud” et “HybroCloud : cloud bursting en temps réel” ont été présentées au salon de la recherche d’Orange en 2011.

[4] Deux démonstrations intitulées “Mon cloud de stockage personnel” et “Cloud total : les terminaux en bordure ont aussi leur place dans les clouds !” ont été présentées au salon de la recherche d’Orange en Research de 2009.

[5] Une démonstration intitulée “Disposez de vos propres tranches de réseau !” a été présentée au salon de la recherche d’Orange en de 2010.

[6] En service entre 2012 et 2019.

[7] La question concerne davantage l’évolution du marché que la technologie elle-même.

Références/liens externes :

Orange : « le Cloud Computing est dans notre ADN »

The Evolution of Cloud Computing – Where’s It Going Next?

Infrastructure Cloud – IaaS

The cloud’s future is vertical

Clouds verticaux : répondre aux besoins de l’industrie

A foggy future for mega data centers

“Fog Computing” et cloud géo-réparti

The future of cloud computing – an army of monkeys?

Cloud Computing Statistics 2019