La fin de l’Internet a été prédite de nombreuses fois. La plus célèbre de ces prédictions date de 1995, quand Bob Metcalfe, l’un des pères fondateurs de l’internet a prédit « a catastrophic collapse » (un effondrement catastrophique) de l’Internet avant la fin 1996. La petite histoire dit qu’il a dû littéralement « manger ses mots » lors de la conférence de World Wide Web 1996. Depuis, d’autres gros titres se font régulièrement sur la « fin de l’Internet », invoquant plusieurs types de raisons :

- La technologie a atteint ses limites : impossibilité technique et/ou économique de développer la capacité du réseau aussi vite que croît le trafic

- Le modèle n’est plus soutenable : la croissance exponentielle du trafic pourrait entraîner une consommation énergétique des infrastructures à laquelle la production future d’énergie ne pourrait pas faire face.

- Le niveau d’insécurité devient inacceptable : La perte de la bataille contre les virus, les malware, le phishing, les attaques en dénis de service… qui ferait que l’internet deviendrait simplement inutilisable. On peut aussi imaginer la propagation globale d’une panne technique, ou une attaque coordonnée visant à mettre à bas le fonctionnement de l’Internet

- L’Internet cesse d’être global et ouvert : Les enjeux de souveraineté face à la surveillance généralisée pourrait entrainer la fragmentation de l’Internet global en Internet à deux vitesses (ou plus), ou alors en Internet régionaux ou nationaux avec une très faible « libre circulation » des données entre zones locales.

Alors, face à une croissance « exponentielle » du trafic, l’Internet va-t-il connaître une « fin du monde » en 2023 ? C’est en tout cas la prédiction formulée par un article récent [1] du professeur anglais Andrew Ellis, spécialiste de transmissions optiques. Cet article a été abondamment repris par la presse comme c’est souvent le cas en matière de fin du monde. Le professeur Ellis cite en particulier un « capacity crunch » dû à une limite du débit de transmissions optiques sur une fibre, limite qui pourrait s’avérer infranchissable.

L’épine dorsale d’Internet : une affaire de câbles

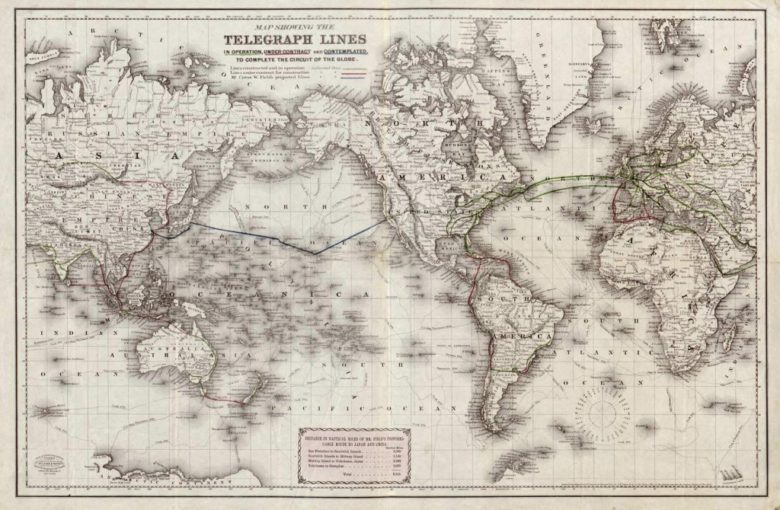

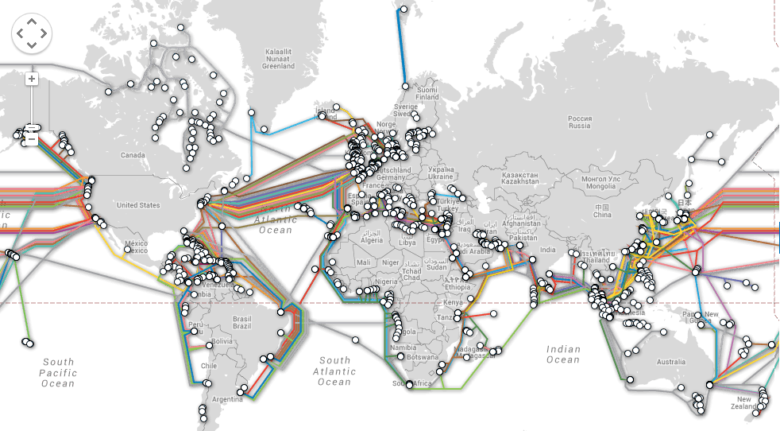

La quasi-totalité des réseaux de transport d’information à longue distance d’Internet sont constitués de fibres optiques. Les câbles sous-marins ou terrestres forment ainsi une véritable épine dorsale pour l’Internet (backbones). Ces fibres ont commencé à remplacer vers la fin des années 70 les câbles sous-marins coaxiaux et les faisceaux hertziens. Ces technologies ayant elles-mêmes déjà pris le relais des fils télégraphiques qui ont constitué le 1er « Internet global » (le télégraphe) en faisant le tour de la planète dès 1870 !

Le réseau de télégraphie vers 1870 : un véritable Internet Victorien [2] Source Original map from Library of Congress

Carte des câbles optiques sous-marin (Source Telegeography Submarine Cable Map)

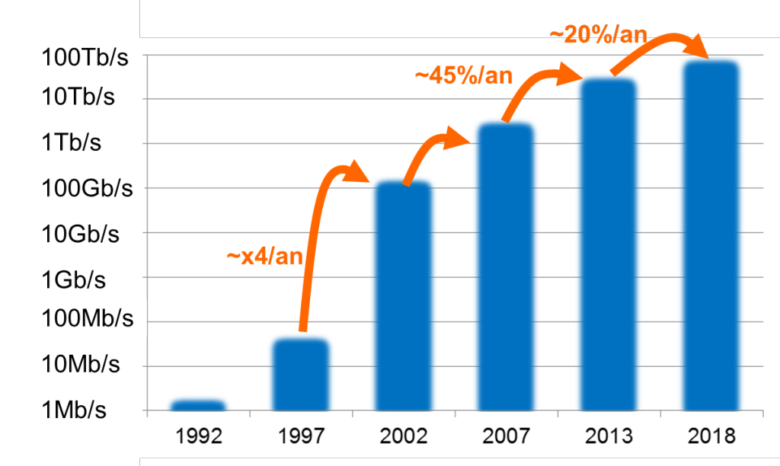

Depuis ses débuts, à la fin des années 1980, le trafic Internet a augmenté de façon rapide. En 1992, on estime que le trafic global était de l’ordre de 100Gbit par Jour. En 1997 il était de 100Gbit par heure et en 2002 de 100 Gbit par seconde. En 2014, 100Gbit sont échangés sur Internet chaque 400èmes de seconde ! Cette progression, de l’ordre de 20 millions entre 1992 et 2015 s’est faite ces dernières années au rythme de 35-50 % par an. Pour les années à venir, les prévisions sont de l’ordre de 20-25 % par an.

Evolution du trafic Internet mondial

Compilé d’après Cisco [3-5], Global IP Traffic Forecast and Methodology, 2006-2011 et Visual Networking Index: Forecast and Methodology, 2013–2018

Deux pistes sont explorées pour faire face à cette croissance :

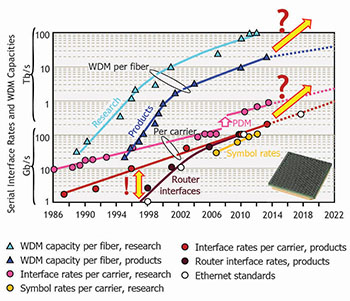

La première de ces pistes consiste à augmenter la capacité de transport sur une fibre, grâce à l’ingéniosité et aux efforts de chercheurs et d’ingénieurs qui ont sans cesse travaillé à en repousser les limites. Chaque longueur d’onde optique transportait 2,5 Gbit/s en 1990. A partir de 1990, le multiplexage en longueurs d’onde (WDM pour Wavelength Division Multiplexing) a permis de transporter plusieurs longueurs d’onde dans chaque fibre optique. Associé à l’utilisation de l’amplification optique, le WDM a permis une augmentation conséquente du débit dans les fibres optiques sur de très longues distances. Cette technologie a permis d’atteindre 10 Gbit/s par longueur d’onde en 1996 et aujourd’hui, de manière opérationnelle, 100 Gbit/s par longueur d’onde.

La seconde solution consiste tout simplement à multiplier le nombre de câbles, et donc de fibres : des consortiums d’investisseurs assurent le financement de la pose de nouveaux câbles sous-marins. Les opérateurs de télécommunication déploient des boucles terrestres reliant les grandes villes à l’échelle continentale.

Toute progression exponentielle, en tout cas quand elle s’opère en dehors des espaces abstraits des mathématiciens, rencontre un jour une limite. Pour Orange qui déploie des fibres sous-marines avec ses navires câbliers et qui opère un réseau mondial de 450 000 km de fibres (plus de 10 fois le tour de la terre), il est important de comprendre si nous allons rencontrer plus ou moins rapidement des limites fondamentales à la transmission optique.

Les limites de l’optique

Précisons pour commencer que le problème de «capacity crunch» ne porte pas sur «La Fibre», celle qui amène aujourd’hui Télévision, Internet et Téléphone à plus de 4 millions de clients raccordables en France. Cette fibre d’accès (FTTH, Fiber To The Home) pose des questions de coûts de déploiement, mais les débits transportés correspondent aux besoins d’un seul client (typiquement de 100 Mbit/s à 1 Gbit/s) qui bénéficie de la totalité des capacités d’une fibre pour son seul usage.

Le problème porte sur les réseaux de transport d’information au cœur de l’Internet, là où le trafic agrégé de millions de clients s’échange entre l’Europe et les USA, ou entre deux grandes villes de France.

Le lecteur passionné par le sujet pourra lire un article intéressant et accessible [6] qui donne des perspectives sur la question des limites du transport optique.

Evolution des performances du transport optique (Source Winzer 2015 [6]). Limites opérationnelles par longueur d’onde (cercles rouges) et par fibre (triangles bleu foncé).

On peut aussi, comme je l’ai fait moi-même, interroger les chercheurs d’Orange qui participent depuis des années à cette magnifique aventure de l’amélioration des performances du transport optique. Pour continuer cette amélioration, de nombreuses pistes sont identifiées « modulations d’ordre supérieur », amplificateurs Raman distribués, parallélisation sur N fibres, multiplexage par division spatiale, fibres « few-mode », réseaux optiques flexibles…

Les systèmes WDM actuellement déployés utilisent 80 longueurs d’ondes différentes au sein de chaque fibre. Dans l’architecture réseau actuelle, chaque longueur d’onde transporte 100Gbit/s à une distance suffisante (plusieurs centaines de km de portée). La capacité par fibre est donc de 8 Tbit/s (80×100 Gbit/s). Partant de cet existant, nos chercheurs envisagent deux horizons de temps.

Dans un premier temps, il s’agit de continuer d’améliorer les débits transportés, sans changer les fibres actuellement déployées, ni modifier de l’architecture actuelle des réseaux de transport. Cela passe par l’utilisation de technologies de communications numériques plus en plus avancées (QAM d’ordre supérieur, filtrage de Nyquist, traitement avancé du signal numérique, codes correcteurs d’erreur, amplification optique, …). La prochaine génération de systèmes WDM pourrait probablement transporter environ 20 Tbit/s par fibre, mais avec une portée de transmission réduite. La limite ultime est évaluée à 75 Tbit/s sur des distances conformes avec notre architecture réseau. Ces approches commencent à atteindre leurs limites car nous nous nous rapprochons effectivement de la limite de Shannon. Atteindre de telles capacités pourra se faire en introduisant de la flexibilité par exemple dans l’occupation du spectre optique (un nouvel arrangement flexible des grilles de longueurs d’onde qui sont aujourd’hui fixes et espacées de 50GHz). D’autres techniques sont aussi envisagées telles la transmission «multibande» pour apporter plus de flexibilité et d’efficacité dans la gestion de la bande passante optique. Une autre approche consiste à utiliser plusieurs systèmes WDM parallèles (par exemple 80X100 Gbit/s) sur plusieurs fibres disponibles dans un câble donné.

Quand les limites des fibres actuelles seront atteintes, il faudra bien entendu avoir des solutions pour continuer d’accompagner la croissance du trafic, avec des coûts raisonnables. Pour préparer ce passage de relais, les chercheurs travaillent dès à présent sur de nouveaux supports optiques et/ou une architecture réseau significativement modifiée. Les propositions sont multiples, mais elles s’appuient en général sur l’utilisation de fibres « multicoeurs » et/ou « few-mode ». Les fibres multicoeurs sont fabriquées pour créer plusieurs canaux optiques indépendants en parallèle. Les fibres few-mode permettent de faire cohabiter plusieurs flux optiques parallèles, au sein de la même fibre. Toutes ces techniques sont démontrées en recherche, mais les fibres à « quelques modes spatiaux » et les technologies associés (amplificateurs optiques, MUX / DMUX de modes spatiaux, ROADM, …) ne sont pas matures. Il est alors très prématuré aujourd’hui de penser que cette solution pourrait être utilisée si nécessaire. En tout état de cause, il faudrait que le progrès technique permette d’augmenter la capacité globale d’au moins deux ordres de grandeur (x100) pour justifier le déploiement d’une nouvelle génération de fibres (comme par le passé, le gain de performances entre les câbles coaxiaux et les fibres optiques).

Faire coopérer de nombreuses technologies pour faire face à la croissance du trafic Internet

Mais l’optique n’est pas seule à pouvoir, par ses progrès, aider à acheminer un trafic Internet en croissance rapide. La recherche d’Orange, et plus globalement celle de l’industrie travaille à « attaquer le problème » de nombreuses manières:

Il est possible d’améliorer les performances des technologies de transport physique (fibre optique, radio), ou de réduire la quantité d’information nécessaire pour transmettre une vidéo ou un contenu donnée. Les nouveaux codecs vidéo de type HEVC, auxquels Orange a contribué, demandent 2 fois moins de capacité réseau pour la même qualité de vidéo transmise.

On pense à optimiser l’emplacement des données : en pré-positionnant des contenus les plus demandés au plus proche du consommateur, on réduit statistiquement le besoin de transports à longues distances. Cela se fait à travers des « caches » (Content Delivery Networks).

Il est également possible d’optimiser globalement les architectures, faire converger les réseaux fixe-mobile via des points de présences de nouvelle génération qui ont été décrits dans ce blog, la signalisation et les besoins en énergie pour l’Internet global

Enfin… il sera toujours possible de déployer de nouvelles capacités de transport en maintenant un investissement permanent sur de nouvelles infrastructures et en posant de nouveaux câbles…

Alors, fin de l’Internet en 2023 ?

La communauté mondiale des chercheurs s’accorde sur le fait que les fibres monomodes classiques, celles que nous déployons dans nos réseaux de transport optiques depuis plusieurs dizaines d’années, arrivent au maximum de leur capacité. Nous nous rapprochons rapidement et inéluctablement de cette limite, qui serait autour de 75 Tbit/s par fibre.

Il est toutefois prématurée de prédire un « point de blocage » (unique et non contournable), et encore moins un « écroulement » de l’Internet un certain jour de 2023.

En effet, l’Internet a justement été prévu pour fonctionner sans effondrement, et des solutions nombreuses sont à l’étude pour reculer ces limites.

Pour ne pas être rattrapés par la croissance du trafic, nos entreprises et le secteur public doivent continuer à investir en recherche, et les chercheurs doivent continuer de faire feu de tout bois, en particulier pour développer des réseaux bien plus efficaces d’un point de vue énergétique. L’internet est aujourd’hui un bien commun tellement essentiel à l’humanité, qu’il serait dangereux de ne pas investir pour assurer sa pérennité.

Rechercher et trouver des solutions techniquement et économiquement viables face à la croissance du trafic, c’est un peu comme dans Pacman : s’arrêter d’avancer, c’est se faire rattraper par les fantômes. Au fait, vous connaissez la stratégie des fantômes de Pacman ?

En savoir plus :

[1] « Is the internet on the brink of collapse? The web could reach its limit in just 8 years … »

[2] The Victorian Internet : The Remarkable Story of the Telegraph and the Nineteenth Century’s On-Line Pioneers, Tom Standage, 1998

[3] Cisco, Global IP Traffic Forecast and Methodology, 2006-2011

[4] Cisco, Visual Networking Index: Forecast and Methodology, 2013–2018

[5] Cisco, The Zettabyte Era—Trends and Analysis, 2013

[6] Scaling Optical Fiber Networks: Challenges and Solutions, Peter J. Winzer, 2015

[7] understanding Pac-Man Ghost Behavior, 2010

Ecosystème :

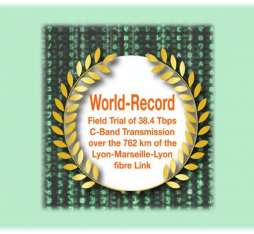

Saser : une experimentation « héroïque »

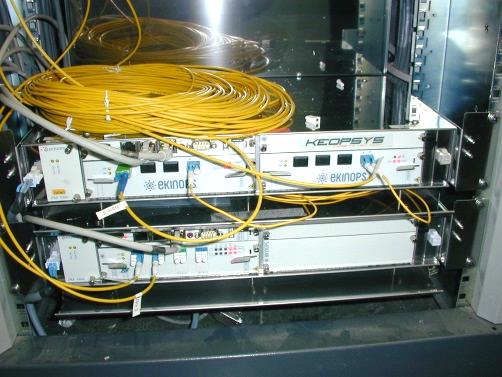

Dans le domaine de la transmission optique, le projet européen SASER auquel les chercheurs d’Orange participent vient justement d’effectuer le 26 mai 2015 une 1ère mondiale : 1 Tbit/s par « super canal » à travers les 762 km d’un aller/retour Lyon-Marseille- Lyon. Cet essai sur le terrain a utilisé les technologies de transmission les plus avancées (modulation QAM-32, codes de correction d’erreurs avancés à « décisions douces », amplificateurs hybrides Raman / EDFA à faible coût et à faible consommation), et une infrastructure de fibre de haute qualité. Un super-canal utilise 4 longueurs d’onde, et est, dans cette expérience, 2.5x plus efficace que les équipements industriels actuellement déployés.

Amplificateurs optique Hybride Raman / EDFA